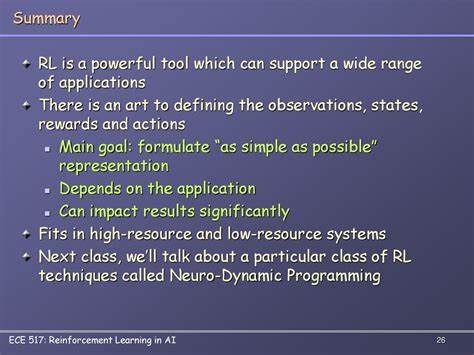

在当今信息爆炸的时代,如何快速高质量地获取文档关键信息成为众多企业与个人迫切需求。传统基于规则或简单生成模型的摘要方法,常常面临信息遗漏或冗余严重的问题。尽管大型语言模型(LLM)在文本生成方面表现优异,它们所强调的重要信息与用户实际需求存在偏差,导致生成的摘要未必符合预期。为克服这些难题,科研人员与工程师们探索将强化学习应用于文档摘要场景,催生了专门针对总结任务的Summary-RL模型。Summary-RL以其强大的问答覆盖率和摘要准确性,彰显了强化学习在自然语言处理中的独特优势。Summary-RL模型基于Qwen 2.5 14B大规模语言模型,通过引入强化学习架构优化文本摘要生成任务。

其核心理念在于对模型生成的摘要进行评分,并以此评分作为强化学习的奖励信号,指导模型生成更符合预期的内容。为了实现科学公正的评价体系,团队设计了一个judge LLM(即裁判模型),利用它评估摘要对原文问题的覆盖度。具体而言,给定文档中的五个问题,judge LLM根据摘要尝试回答问题,然后计算与标准答案的匹配率,作为摘要质量的客观指标。与此同时,为防止模型泛化为简单复制原文,设置了摘要长度严格限制为350字,超出则奖励为零。有了这样明确的奖励函数,模型能够在保持高信息含量的基础上控制文本长度,保证摘要的简洁明了。训练数据主要采用ServiceNow旗下的Repliqa数据集。

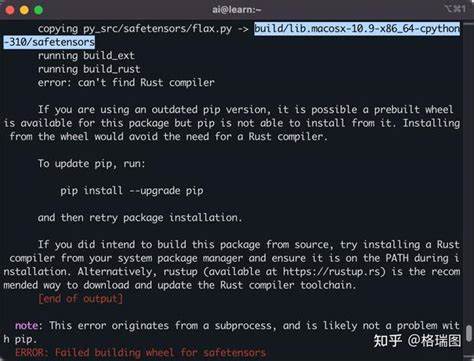

该数据集由合成文档组成,模拟真实但虚构的信息,配备对应的问题与准确答案,旨在避免judge模型通过记忆原文外的信息进行辅助回答。尽管数据集具有一定难度,经由筛选剔除judge模型无法完整回答问题的文档,确保训练过程集中于可学习的样本。初步基线测试显示,Sonnet 4等顶级模型生成的摘要仅能正确回答约七成问题,而Qwen 2.5 14B原始模型成绩则较低,仅为43%。这种差距正是强化学习调优的突破口。训练过程中,开发团队利用开源ART(Agent Reinforcement Trainer)库实现训练流程自动化。ART库专注于多回合推理与策略优化,同时也支持单次任务如文档摘要。

训练流程包括数据批次加载、为每个文档生成多条摘要、利用judge LLM评分、根据奖励函数计算梯度并更新模型权重。训练以稳定提升模型覆盖率为目标,不断迭代直至验证集表现趋于平稳。强化学习训练显著提升了模型性能。最终Summary-RL能回答85%的问题,较初始模型提升了42个百分点,甚至超越了Sonnet 4和Gemini 2.5 Flash Preview。除了准确率的提高,模型摘要保持严格的350字以内,保证了信息密度与可读性的平衡。实际对比发现,Summary-RL生成的摘要更加详实且现场感强。

例如针对某环保项目的文本,Summary-RL不仅涵盖了时间、地点与发起人等关键信息,还倾向于保留原文中的直接引用,有效辅助回答细节问题。训练经验中,一项值得注意的教训是,过早在奖励函数中惩罚摘要长度并不理想。若所有摘要都能回答相同数量的问题,模型会倾向于简单缩短文本而非提升内容价值。因此仅对超出字数上限的摘要赋零分,使得模型先专注于覆盖尽量多的问题,随着训练深入逐步学会控制文本长度。此策略为训练过程带来了更平滑的性能提升曲线。成本方面,利用现代GPU如NVIDIA H100和优化推理方案,训练时间约为5小时,总花费仅约22美元,体现了高效且经济的训练范式。

这一低成本赋能使中小型团队也能尝试强化学习改进自身模型。强化学习赋予开发者精准定义个性化摘要目标的能力。除了目前关注的问题覆盖率和长度限制,用户还可将奖励函数扩展至其他内容偏好,如突出会议行动项、避免泄露敏感信息或生成适合社交媒体的简洁版本。只需调整训练数据和奖励反馈,Summary-RL框架即可轻松定制出满足多样需求的摘要模型。总结来看,Summary-RL标志着文档摘要领域一次重要跨越。它有效整合了强化学习和大规模语言建模的优势,用严谨的量化指标替代传统模糊评价,推动生成文本更加精准和实用。

随着科技不断进步,这一技术路线有望广泛应用于客户支持、法律档案整理、科研综述等多领域,极大提升信息处理效率。所有训练代码和工具均已开源,为广大开发者提供了宝贵资源。那些渴望打造专业智能摘要系统的团队,可以以Summary-RL为起点,通过不断迭代和优化,探索强化学习在语言理解和生成上的更多可能。未来,随着更强裁判模型的出现和更多样化奖励设计的引入,我们有理由相信机器自动文本摘要将更好地服务于千千万万用户的个性化需求,开启智能信息时代的新篇章。