作为当今最受欢迎的系统级编程语言之一,Rust以其安全性、高性能及现代语言特性备受关注。然而,Rust编译器在构建大型项目时普遍存在编译速度较慢的问题,尤其是在使用容器化构建环境时更为明显。本文将深入剖析Rust编译器运行机制及其慢速表现的根源,同时探讨有效的优化方法,助力开发者提升编译体验。首先,必须了解Rust编译过程的复杂性。Rust采用了高级的所有权系统和零成本抽象,使得编译器在编译阶段投入了大量工作来保证代码安全与性能。这包括诸如借用检查、泛型单态化(monomorphization)、类型推断等复杂流程。

尤其是泛型单态化导致编译器需要为不同泛型参数生成对应的代码实例,极大增加了编译工作量。使用泛型广泛的代码库因此编译时间也随之增加。其次,链接时优化(LTO)是Rust编译时间延长的核心因素之一。Rust默认启用的“thin LTO”虽较为轻量,但仍需在链接阶段对所有代码模块进行跨模块优化。这种优化能带来更小的二进制体积和更高的执行性能,但极大地增加了链接和代码生成的时间开销。不仅如此,“fat LTO”版本虽然优化效果最强,但编译时间几乎成倍增长,远超实际开发需求。

由此可见,Rust默认配置为保证最高执行效率,而牺牲了编译速度。第三,Rust编译器强烈依赖LLVM后端进行代码生成及优化。LLVM的优化流程包括大量复杂转换和多轮迭代,优化通路中诸如函数内联(Inlining)、控制流图简化(CFG Simplification)及死代码消除等多项通过消耗大量CPU资源完成。尤其是在编译大型或复杂async函数时,LLVM需要处理的中间代码异常庞大复杂,导致优化时间激增。此外,生成的中间表示(IR)中包含大量闭包和异步块展开的状态机,也使得编译过程更加耗时。第四,依赖管理和增量编译策略在容器环境下对Rust构建体验影响显著。

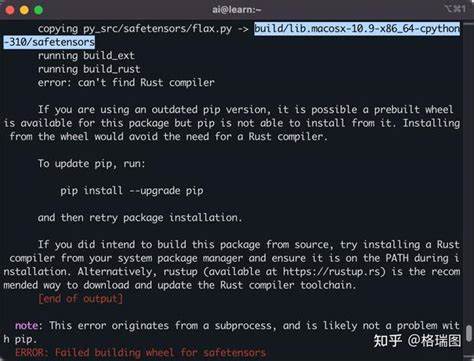

容器化流水线每次构建往往从零开始,导致大量依赖包重新编译。虽然有cargo-chef等工具通过缓存依赖构建层优化构建时间,但最终构建主程序仍需耗费大量时间。此外,开启全debug符号以及开启全优化组合,会进一步放大编译消耗。通过合理关闭debug信息,调整优化等级,可以有效缩短主程序的编译时间。第五,代码结构和Rust特性自身也影响编译性能。大函数尤其是带有大量async调用和泛型的异步函数会产生庞大状态机,给LLVM优化带来沉重负担。

闭包过度嵌套和泛型多态实例化会导致编译器重复生成多版本代码,延长编译时间。针对这一点,拆分长函数、减少闭包层级,使用Boxed Future而非巨大inline async函数,有助于缓解优化压力,从而减少编译时耗。第六,针对LLVM的内联策略,Rust可以调整多种llvm-args编译参数,比如降低inline-threshold来限制函数内联规模,以此减少编译时的优化压力。将此与cargo配置文件结合,可实现灵活控制不同编译阶段的优化深度,从而达到权衡运行时性能与编译速度的平衡。第七,针对泛型实例化的重复编译开销,Rust提供了编译时选项 -Zshare-generics(目前仅夜间版支持),能共享泛型实例化,减少重复代码生成和优化负担。部分项目已经实测开启后可明显降低编译时间,尤其是带有大量依赖和泛型的项目。

第八,基础镜像和环境对编译性能影响也不容忽视。例如,使用Alpine Linux常见的musl标准库默认分配器相对缓慢,切换至Debian镜像以及搭配更高效的内存分配器(如mimalloc)能显著缩短编译用时。部分实践表明,环境层面的优化和硬件资源合理调配是改善容器内Rust构建性能的关键。通过以上分析,我们可以理解Rust编译器为何表现较慢并非单一故障,而是多层次因素综合作用。幸运的是,围绕编译性能已有诸多成熟方案。合理调节LTO选项(关闭或者降低到thin甚至off)、适当调整优化等级、开启增量编译和并行编译缓存、合理拆分复杂函数结构、使用cargo-chef等工具分层缓存构建依赖、切换编译环境及基础镜像、尝试开启实验性 -Zshare-generics等,都能有效缩短编译时长。

未来,Rust社区持续致力于完善异步函数编译和LLVM优化相关子系统,势必能带来更好平衡的性能体验。与此同时,开发者应保持代码结构清晰简洁,避免泛型滥用和单体函数臃肿,提前关注编译性能瓶颈。总的来看,Rust编译器的编译速度问题是一场技术深度与实用需求之间的博弈。选择最适合自身项目和团队的配置,合理取舍编译速度与执行效率,配合工具与环境优化,便能在享受Rust安全性能优势的同时,提升日常开发体验。随着Rust生态成熟、工具链不断改进,未来编译速度瓶颈必将逐步缓解,Rust将成为兼具高效开发与一流性能的首选语言。