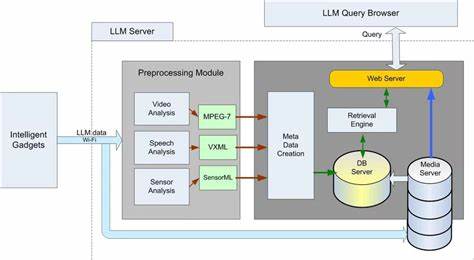

人工智能(AI)技术的飞速进步让其在各个领域展现出前所未有的潜力,同时也带来了一些令人担忧的隐私问题。特别是在AI训练过程中使用大量数据时,人们开始关注个人文件是否可能被用作训练材料。这个问题引发了众多用户的焦虑,尤其是那些在云端存储大量个人照片、文档和其他重要文件的用户。本文将深入探讨AI训练模型是否有可能使用个人文件进行训练,相关的法律合规问题,以及如何保护个人隐私,合理备份数据。随着云存储服务的普及,用户越来越倾向于将重要数据存储在像谷歌云、微软OneDrive和苹果iCloud等平台上。虽然这些服务承诺对数据进行加密保护并遵守隐私政策,但底层是否存在利用个人文件进行AI模型训练的可能性,仍是外界争论的焦点。

一些技术观察者和用户担忧,个人照片或文件可能会在未经充分授权的情况下被用作提高AI模型性能的数据源,尤其是在图像识别、多模态生成模型(如扩散模型)训练中。比如,个人照片可能被训练成某些AI生成图像或者内容的基础,进而产生个性化偏差甚至隐私泄露的风险。此外,隐私政策和用户协议中部分细节往往不易被普通用户察觉,例如允许服务商为改进服务而分析用户数据,从而夹杂了对数据训练的潜在授权。虽然法律层面通常要求服务商在进行数据使用变更时通知用户并获得明确同意,但实际操作中用户不仔细阅读条款,或者变更通知被掩盖在大量信息中,也可能导致用户难以辨识数据是否被用于训练目的。另一方面,云平台出于安全目的,经常扫描用户文件以检测恶意软件和垃圾邮件,这使得技术上读取文件内容成为日常工作的一部分。部分用户因此担心,这种数据访问是否会延伸为用于训练AI模型,尤其在缺乏透明公开声明时更加令人忧虑。

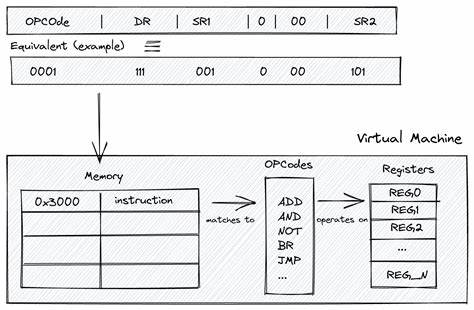

据业内专家分析,从技术角度看,将大量未经筛选的个人数据直接作为训练数据并非最佳路径,因为训练数据的质量对AI模型性能至关重要。杂乱无章或低质量的数据对模型提升作用有限。同时,从商业角度考虑,未经用户同意利用个人文件存在法律风险与品牌声誉隐患,因此大型科技公司更可能采取谨慎态度。尽管如此,人工智能的长远发展难免需要不断扩展数据来源,如何在保护用户隐私的同时兼顾技术进步,是目前行业亟待解决的核心矛盾。鉴于此,用户应当采取有效措施保障数据隐私,避免个人文件被未经授权访问或利用。最重要的做法之一是将重要资料定期备份到离线或本地存储设备,如外接硬盘、NAS存储设备等,避免依赖单一云存储服务。

且对于在线存储服务,可以考虑加密保存个人文件,确保即使云端数据被访问,内容仍无法被轻易读取。此外,选择云服务时应优先考虑那些公开透明、重视隐私保护且遵循严格数据保护规定的服务商。认真阅读隐私政策和用户协议,关注是否允许将数据用于训练或改进AI模型的条款,并尽量避免授予同意。对于家庭照片或私人文档,推荐使用加密软件进行预先加密后再上传,从技术层面提升数据安全性。用户还可以借助专门的备份工具和应用程序,将个人数据同步到安全的本地或自建服务器,如利用文件夹同步程序、加密存储介质等,保持对数据的完全控制权。除了技术手段,社会层面和法律规范的完善同样关键。

各国政府和监管机构近年来逐渐加强对数据隐私与使用的监管,强化用户对个人数据的掌控权。比如欧盟《通用数据保护条例》(GDPR)和中国《个人信息保护法》(PIPL)等法规,都明确限制未经授权的数据利用行为,对违规行为设立了高额罚款和整改措施。未来,随着AI技术的普及和日益复杂的应用场景,数据隐私保护法律法规会更加严格,迫使大型科技企业在采集和利用个人数据时更加透明并且合规。用户也应积极关注相关政策动态,合理利用法律武器保护自己的数据权益。总之,虽然存在部分用户担忧AI训练可能直接使用私人文件的情况,但目前来看,技术壁垒、商业风险与法律约束三方面共同作用,降低了这样的风险发生率。用户可以通过采取合理的备份方案、加密措施以及审慎选择云服务商等手段,有效保障个人数据安全。

同时,政策法规的不断完善也为用户隐私提供坚实的保障。展望未来,人工智能的发展与个人隐私保护将继续相互影响,只有在技术进步和法律监管共同推动下,才能实现二者的良性平衡,确保每个人的数字生活更加安全、自由和透明。 。