随着人工智能技术的广泛应用,数据中心的需求和规模持续爆炸式增长,成为推动计算能力提升的关键动力。作为领先的云计算服务商之一,CoreWeave在AI数据中心建设方面的积极布局引发业内广泛关注。公司首席执行官近日公开谈及了其对未来AI数据中心的发展规划,同时详细介绍了与美国芯片制造巨头Nvidia的紧密合作关系,以及如何借助尖端硬件和创新技术保障服务的高效与稳定。CoreWeave自成立以来,一直致力于为各类计算密集型应用提供弹性且高性能的云资源。面对AI模型训练和推理对计算资源空前旺盛的需求,CoreWeave明确了以GPU为核心的硬件策略,坚定采用Nvidia最新一代加速卡,为客户提供稳定且领先的算力支持。首席执行官指出,随着生成式AI和大模型技术的不断突破,计算负载和数据吞吐量要求急剧提升,这促使CoreWeave加快数据中心扩展步伐,不断引入先进的冷却系统和网络架构优化,以实现能源效率与运算效能的平衡。

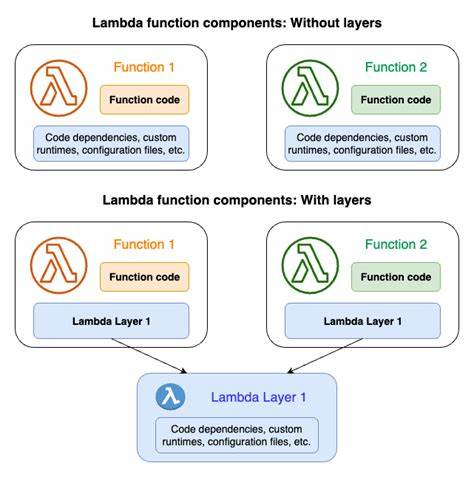

除此之外,CoreWeave注重打造灵活的调度平台和API接口,帮助开发者和企业灵活调用底层资源,提升AI研发和应用的效率。对于Nvidia的选择,CoreWeave CEO强调这一合作不仅仅是硬件层面的供应关系,而是深层次的技术协同和产品生态融合。双方在芯片设计、软件平台和AI系统优化方面展开多维度合作,特别是在加速AI训练的技术方案和高性能计算集群建设上实现了显著共赢。CoreWeave利用Nvidia强大的CUDA生态和最新发布的H100 GPU,为客户提供无缝兼容的算力环境,支持主流深度学习框架如TensorFlow、PyTorch的高效运行,从而满足多样化AI应用需求。展望未来,CoreWeave准备进一步扩大数据中心规模,布局全球节点,确保客户无论在何地都能享受到低延迟和高带宽的计算资源。同时,公司也关注绿色计算,致力于采用可再生能源和优化设施设计,降低碳排放,实现可持续发展目标。

CoreWeave的这种前瞻性战略布局预示着云计算基础设施正在向更加专业化和智能化转型,满足AI时代对算力的爆炸式需求。Nvidia作为全球GPU领域领导者,其硬件和软件优势为CoreWeave的数据中心赋能,加速AI技术的商业化落地与创新应用。整体来看,CoreWeave CEO的分享为行业展现了一个典型的AI计算服务提供商如何通过技术创新和合作伙伴生态构建来领跑未来市场。其对高性能GPU资源的依赖,以及对智能调度和绿色计算的关注,都彰显了在AI风口上的实力与责任。随着人工智能的不断发展,类似CoreWeave这样的企业将在数据中心和算力资源领域扮演愈发重要的角色,引领技术进步和产业升级,推动数字经济迈向新高度。