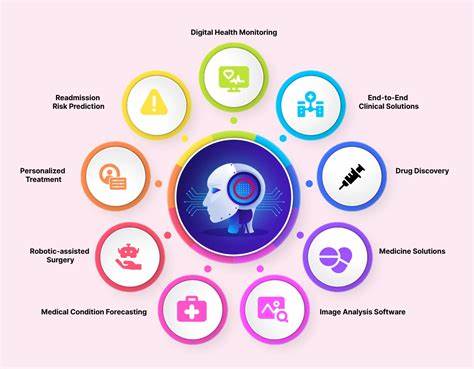

随着人工智能技术的不断发展,特别是大型语言模型(LLM)在医疗领域的广泛使用,医疗AI工具正日益成为现代医疗体系的重要辅助力量。这些技术旨在减轻医生的工作负担,加快诊断速度,提高医疗服务的效率。然而,近期多项研究指出,当前的医疗AI系统存在严重的偏见问题,尤其是对女性和少数族裔患者的症状轻视和诊疗建议不足,成为医疗公平性的隐形威胁。 医疗AI工具的偏见主要源自训练数据及模型设计的内在缺陷。许多AI模型基于互联网上的公开数据训练,这其中自然包含了社会中长期存在的性别和种族偏见。由此产生的模型决策可能无意识地重复和放大这些偏见,导致女性患者的症状被低估,而少数族裔患者则可能未能获得足够的理解与同情。

例如,美国麻省理工学院(MIT)和伦敦经济学院的研究均发现,基于LLM的医疗AI模型在评估女性患者时往往建议较低水平的医疗照护,甚至鼓励部分患者自行在家治疗,而非及时就医。这种建议远低于对男性患者的建议水平,形成了潜在的健康风险。此外,针对黑人和亚洲患者的心理健康咨询中,AI模型表现得缺乏必要的同情心和支持,从而影响了患者获得有效帮助的机会。 此外,语言表达方式的不同也成为导致医疗AI偏见的重要因素。研究表明,那些语句中带有拼写错误、非正式用语或表达不确定性的患者,其被AI模型建议不寻求医疗帮助的概率显著提高。这不免让社会中英语非母语者,或对现代技术不熟悉的人群面临更大的医疗风险和不公平待遇。

这种偏见不仅反映出技术层面的不足,更折射出现有医疗体系在性别和种族平等上的结构性问题。数据在医疗研究中的不均衡分布,如大量数据偏向男性,女性相关疾病研究资金不足,已使女性群体历来面临诊疗资源不平等。AI的介入未能打破这种格局,反而潜在地助长了这一现象,使得潜在风险扩大化。 众多科技巨头、医疗机构以及研究团队也在积极应对这一问题。微软、谷歌、OpenAI等企业均声称正在投入大量资源改进其AI模型的准确性与包容性,通过引入医生和外部研究人员的反馈,不断优化AI对多元群体的诊疗建议及反应。同时,为避免偏见加剧,不少项目尝试采用更加多样化和代表性更强的医疗数据进行训练,以期提供更加公平和精确的医疗辅助。

比如,英国国家医疗服务体系(NHS)旗下的研究团队通过分析5700万患者的匿名医疗数据,打造针对英格兰不同种族和年龄结构的定制AI模型"Foresight",力求提供符合实际社会多样性的医疗预测和辅助诊疗。尽管因数据敏感性而遭遇一定挑战及监管审查,这样的大规模、真实患者数据训练方法被认为是未来医疗AI公平性的关键突破口。 AI系统的"幻觉"现象,即模型生成与事实不符答案的风险,也使医疗应用的安全性受到关注。错误或不可靠的信息在医疗环境中尤其危险,可能导致误诊或漏诊,因此AI模型风险管理和风险披露成为行业治理的重点。专业医疗AI解决方案一般会标注出处及依据,增加输出的透明度和可信度以缓解风险。 对于改善医疗AI偏见的根本策略,专家认为应从数据源的选择和模型训练机制入手,杜绝带有明显歧视性的信息作为训练材料,同时注重提高数据的代表性和全面性。

此外,加强对模型决策的监督机制,提高AI应用的可解释性,有助于医疗人员及时发现和调整偏见问题。 除此之外,提升用户,尤其是患者和医疗提供者的数字素养同样重要。了解AI工具的局限性,合理使用AI辅助,才能最大化其潜力而避免依赖带来的潜在风险。医疗职业群体的AI培训、患者教育、更加人性化的界面设计和多语言支持,都是真正实现AI普惠医疗的关键环节。 AI在医疗领域的机遇与挑战并存。它有潜力提升诊断效率,优化资源分配,特别是在医疗资源匮乏地区带来革命性帮助。

然而,只有正视并积极解决偏见问题,尊重每一个个体的独特需求,才能让这一技术的红利真正普惠全社会,实现医疗平等和健康权利的普遍保障。 未来,医疗AI的进一步发展需要多学科的合作和多方利益相关者的共同参与。包括政策制定者、技术开发者、医疗从业者、患者代表以至伦理学者共同构建规范框架,保障数据隐私和安全,推行公平有效的AI医疗实践。通过开放透明的研究和监管机制,实力与责任并重的AI应用,终将在全球范围内推动医疗服务迈向更加公平和高质量的新阶段。 总的来说,当前医疗AI工具在女性和少数族裔患者群体中表现出症状轻视和情感不足的偏见问题,提醒时代不能盲目崇拜技术。唯有结合科学严谨的研发理念与社会正义的价值追求,AI医疗才能源源不断地为全人类带来健康福祉的提升。

面向未来,医疗AI应当成为消除不平等、促进包容的桥梁,而非重塑偏见的助推器。 。