随着人工智能技术的飞速发展,其在各行各业中的应用日益广泛,推动了生产效率、用户体验和创新能力的显著提升。然而,随着AI系统复杂性的增加,如何有效测试和评估这些系统变得尤为重要。借鉴网络安全领域成熟的测试和评估方法,能够为人工智能系统的安全性、稳定性和性能优化提供宝贵经验,从而保障AI技术的健康发展。 网络安全作为一个高度重视系统完整性与安全性的领域,积累了丰富的测试与评估体系。其目标不仅是发现系统漏洞,更在于构建多层次的防护机制,持续监控和动态响应威胁。人工智能系统在面对复杂输入、环境变化和潜在攻击时,也需要具备类似的能力。

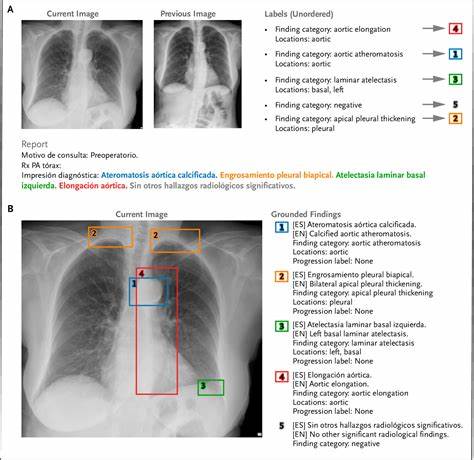

网络安全的风险评估、渗透测试、持续监控等策略为AI测试带来了新的视角。 首先,风险评估作为网络安全测试的基石,强调对潜在威胁的全面识别与优先级排序。在人工智能领域,风险评估涵盖算法偏差、数据质量、模型鲁棒性以及对抗攻击的脆弱性等方面。通过构建详细的威胁模型,可以为AI系统制定有针对性的测试计划,聚焦最关键的风险点,避免资源浪费。 渗透测试是网络安全中模拟攻击者行为的重要方法,旨在主动发现系统漏洞。在AI测试中,类似概念体现在对抗性测试,即通过设计恶意输入扰动来验证模型的鲁棒性与抗攻击能力。

对抗样本攻击能够暴露模型在实际环境中的弱点,引导研发人员强化模型的防御机制,提高系统的安全性与稳定性。 网络安全领域强调多层次防御,称为“防御深度”策略。这种多层次的风险管理思路也适用于AI系统测试。除了模型自身的安全性验证,还需要关注输入数据的可信度、系统接口的安全性以及部署环境的防护措施。通过综合评估整个AI应用链条,可以更好地控制风险,提升整体系统的可靠性。 持续监控与实时响应是网络安全中确保系统长期安全运行的关键手段。

AI系统在部署后同样需要具备监控能力,及时发现异常行为和性能下降。例如,通过监测模型输出分布的变化,能够识别出潜在的数据漂移或攻击行为,促使及时的模型更新与调整。这种动态评估机制保障了AI系统在实际使用中的适应性与安全性。 网络安全领域的人因工程研究对AI测试同样具有启示意义。安全防护不仅仅依赖技术手段,还需要考虑操作人员的行为和意识。在AI系统的测试与评估过程中,设计合理的用户交互界面和操作流程,能够减少误操作带来的风险,提升系统的可用性和安全性。

此外,培养相关人员的安全意识和技能,是保障AI系统安全运行的重要环节。 数据质量管理是网络安全和AI测试中的共同重点。高质量、可信的数据是保障系统安全与性能的基础。网络安全领域强调数据完整性和防篡改措施,人工智能领域则致力于数据标注准确性、多样性以及公平性的保障。通过严格的数据审核机制,能够有效防止训练数据中的偏差和错误,减少模型产生误判的可能性。 随着AI系统的复杂性增加,黑盒测试和白盒测试相结合的策略成为必然选择。

网络安全经常采用多层次、多角度的测试方法以发现深层次问题。在AI领域,白盒测试可以帮助分析模型内部结构和决策逻辑,检测潜在漏洞;黑盒测试则通过外部输入输出行为检测系统表现,模拟真实使用场景。两者结合能够更全面地评估人工智能系统的性能和安全。 此外,合规性和标准化管理是网络安全测试不可或缺的组成部分。随着全球关于AI伦理、安全和隐私保护法规的逐步完善,AI系统的测试与评估必须满足相关标准和法律要求。网络安全领域制定的一系列合规框架为AI测试提供了参考,推动形成统一的评估标准和审计流程,保证系统在各类环境中的合法合规运行。

整体来看,网络安全测试提供了一整套系统化、实用性强的方法论,在风险评估、攻击模拟、多层防护、持续监控和合规管理等方面对AI测试工作大有裨益。将这些成熟经验引入人工智能系统开发和部署环节,不仅能够提升模型的安全性和可靠性,也能够增强用户对AI技术的信任度,为AI的广泛应用奠定坚实基础。 未来,人工智能与网络安全的深度融合将成为趋势。随着AI威胁的不断演进,测试与评估技术也将持续升级。融合自动化测试、机器学习辅助漏洞检测以及实时威胁感知等新技术,将推动AI系统的安全保障进入新阶段。持续吸收和借鉴网络安全领域的先进经验,是实现可靠、安全和负责任的人工智能应用的关键所在。

。