人工智能(Artificial Intelligence,简称AI)已经成为当今科技领域最热门的趋势之一。随着各种大型语言模型(Large Language Models,简称LLM)和智能算法的快速发展,越来越多的开发者和企业开始依赖AI接口来构建创新应用。然而,伴随着AI调用的普及,开发者们也越来越感受到传统的AI服务计费机制所带来的压力和限制。特别是在复杂推理任务和大规模上下文处理时,费用的高昂让许多个人开发者和小型创业团队望而却步。面对这一现状,服务器无服务器、按秒计费的AI推理模型作为一种新兴的定价方案引起了广泛讨论。该模式借鉴了云计算领域的无服务器计算理念,即用户只需为实际使用的计算资源付费,无需管理底层硬件。

这种创新的计费方式或许能够解决现有AI调用费用难题,同时优化资源利用率,促进AI生态的可持续发展。本文将从多个角度深入解析服务器无服务器按秒计费的AI推理模型,探讨它的优势、潜在挑战以及未来的发展机遇。首先,理解传统AI服务的计费模式对于认识其局限性至关重要。当前主流的AI接口多数按照调用次数、生成文本的字数甚至是固定套餐收费。例如某些大型语言模型的API,复杂的一次调用可能花费数美元甚至更多,尤其是涉及到多轮对话和长文本时开销进一步增加。这种收费机制对于企业客户和大型项目虽然较为合理,但对独立开发者、学生以及爱好者来说则是很大的经济负担。

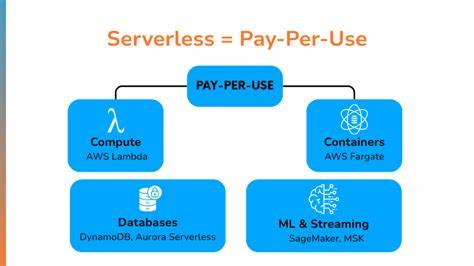

同时,由于费用的不确定性和偶发性,开发者难以进行精细预算和成本控制,影响了创新实验的积极性。与传统固定计费相比,服务器无服务器的按秒计费模式有着明显优势。这一模式的核心在于,计算资源完全由云端统一调度,开发者无须配置或维护任何服务器,直接调用API接口提交请求即可完成AI推理任务。同时,计费则根据实际GPU计算时间来计算,类似于云计算中的无服务器函数计算(如AWS Lambda)。这种方式不仅提升了资源的共享和利用效率,而且使得用户只为实际消耗付费,极大降低了不必要的闲置开支。更重要的是,这种按秒计费模型为用户提供了更大的灵活性和透明度。

开发者能够明确地了解每一次AI推理请求的时间和成本,从而更好地规划应用逻辑和调用频率,实现更科学的成本管理。此外,这种模式还极大地降低了门槛,使得个人开发者和小团队能够更容易承担AI调用的费用,从而激发更多创意和实验。尽管服务器无服务器按秒计费的概念具有诸多优点,但在实际落地过程中仍面临着不少挑战。首先,底层硬件资源的高昂成本是最大难题。GPU和其他专用AI算力设备价格不菲,维护和运营大规模共享集群需要投入大量资金和技术力量。如何在保证服务质量的前提下,实现成本的有效摊销,关系到这一方案的经济可行性。

其次,推理任务的延迟问题需要重点关注。由于请求需由云端调度并等待空闲GPU资源,初次冷启动和高峰期可能导致响应延迟,加大对实时应用的风险。此外,公平调度和资源分配策略的设计也关乎用户体验和系统稳定性。最后,市场上的竞争压力也不容忽视。目前大型云服务商和AI平台均在积极推出类似的无服务器计算产品,如谷歌云的Cloud Run GPU支持,这些成熟产品拥有丰富的资源和行业经验,新参与者面临技术、资金及客户基础的多重压力。尽管如此,服务器无服务器按秒计费AI推理模式仍被广泛看好为AI生态下一阶段的发展方向。

它契合了云计算“按需付费”和“弹性伸缩”的核心理念,能够帮助开发者更合理地控制成本,推动更广泛的AI应用创新。在未来,随着硬件成本的持续下降和调度技术的不断完善,该模式有望成为中小型开发者和创业者的首选服务。展望未来,服务器无服务器按秒计费AI推理的推广还可能带来整个AI供应链的革新。更灵活透明的计费机制能够促使AI模型供应商、算力提供方和终端用户形成新的生态共赢局面。开发者可以享受到更低门槛、更优质的服务,企业则能够乘势加快AI产品落地的步伐。同时,这种模式也有助于催生更多创新型服务和工具,比如支持定制化推理流程、自动化成本监控的云端平台。

总结来看,当前AI推理的高成本问题确实成为制约创新的瓶颈。服务器无服务器按秒计费模式凭借其灵活、透明和用户友好的特性,为解决这一问题提供了可行路径。虽然面临运营成本、调度效率和市场竞争等挑战,但其潜力不可忽视。对于开发者来说,拥抱这种模型意味着可以以更合理的成本尝试更多可能;对于整个AI产业而言,它则是实现普惠智能的关键一步。随着技术的成熟和生态的完善,这种计费模式极有可能在未来几年内成为AI推理服务的新标准,赋能更多人参与到AI创新热潮中。