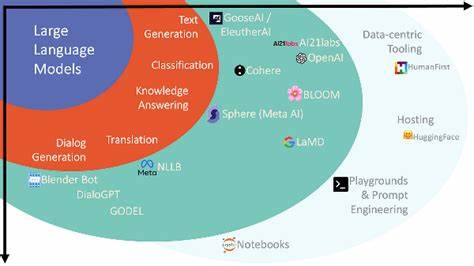

随着人工智能技术的迅猛发展,大型语言模型(LLM)如OpenAI的GPT系列,已成为自然语言处理领域的核心工具。它们凭借强大的上下文理解能力和生成能力,广泛应用于文本分类、问答、翻译等任务。随之而来的是一个重要问题:LLM是否能够高效地完成批量分类任务?或者说,能否在单次调用中处理多个输入,并保证分类结果的独立性和准确性?这一问题在实际应用中尤为关键,直接关系到系统的性能效率及成本控制。传统的机器学习模型在处理批量分类时表现优异,每个输入样本的分类通常是独立且一致的,用户可以一次性批量处理大量数据。然而,LLM的工作机制决定了其在批量分类时面临一些独特挑战。本文将从技术原理、实际案例以及未来展望多方面进行详细分析。

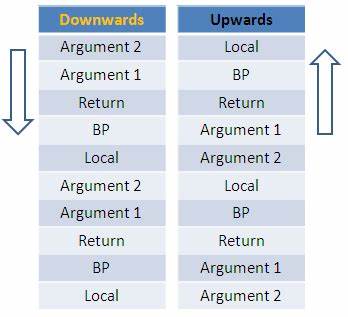

大型语言模型本质上是基于自回归生成的神经网络模型。它们通过对上下文的理解和预测,生成符合语义的文本序列。在单次调用中同时输入多个分类实例时,模型会将所有输入视为一个整体文本序列来处理,这就导致了分类之间的相互干扰。在某些实验中,用户将包含多个文本输入的批量字符串发送给模型,请求其进行分类输出,却发现单个文本的分类结果受到同批文本影响,表现为分类不稳定甚至出现偏差。这种情况与传统的独立样本假设截然不同,限制了LLM在批量分类上的直接优势。有来自Hacker News社区的一次讨论揭示了这一现象的普遍性。

一位用户尝试使用LLM进行10条文本的批量分类,要求模型以JSON格式返回分类结果。结果显示,文本的分类严重依赖于它们在批量内的邻接文本,导致单个文本的分类不够独立准确。另一位用户分享了类似经历,即尝试分批传入数据并让模型按照初始指令独立处理每条输入,然而随着批次逐渐变大,模型的上下文混淆问题加重,错误率上升。显然,LLM的上下文窗口在面对多条数据时存在天然限制。上下文窗口大小限制是批量分类困难的根本原因之一。现有LLM的有效上下文长度有限,当输入文本长度过长或包含过多样本时,后续文本的信息会受到前面内容的挤压或者被遗忘。

加之,模型对输入顺序和语境有敏感性,导致批量中的不同文本彼此影响,分类结果无法做到互不干扰。尽管如此,部分技术社区指出,通过底层架构和推理方式的优化,仍能实现某种形式的批量处理。例如某些高效推理库(如vLLM)支持将多个独立文本数据的特征向量同时输入神经网络,并行计算加速推断过程。这种批量在神经网络层面上的实现,是在保证每条输入独立处理的前提下,实现效率的提升,但不等同于在单一文本上下文中混合多条分类指令。对于实际应用场景而言,是否必须单条调用LLM进行分类,取决于对效率和准确性的权衡。批量调用带来的效率提升在规模极大时极具吸引力,但是当前主流LLM的上下文处理机制尚无法保证结果的独立性和准确性,这使得开发者在设计系统时必须谨慎选择。

未来技术发展可能带来突破。一方面,上下文窗口的扩容和模型架构的创新,可能帮助LLM更好地处理长文本和多示例场景。另一方面,结合传统机器学习技术与LLM的能力,通过混合智能系统进行批量分类,也是不少研究方向。此类方法在保持结果准确性的同时,提升整体处理效率,已逐渐成为热点。此外,新兴的指令学习和少样本学习策略,为批量分类提供了新的思路。通过设计精巧的任务格式和清晰的指令提示,帮助模型更好地“理解”批量分类任务的独立性需求,从而减少样本间的干扰。

总的来说,LLM在批量分类上的应用尚处于探索阶段,虽然存在一定技术瓶颈,但未来随着模型能力的提升和算法优化,批量分类的优势有望实现。对于开发者和研究者而言,深入理解LLM的工作机理,合理利用上下文窗口,结合传统方法,是目前提升批量分类性能的关键路径。人工智能技术的快速演进必将推动这一领域迎来更广阔的发展空间,为各种大规模文本处理任务带来全新的效率和质量提升体验。