随着人工智能技术的不断进步,视觉与物理理解能力成为评估人工智能综合智能水平的重要指标之一。视觉物理理解测试(Visual Physics Comprehension Test,简称VPCT)作为衡量模型在物理现象预测和场景理解能力上的标准测评,近年来备受关注。本文深入剖析了大型语言模型(LLMs)在VPCT上的最新表现和发展趋势,探讨背后所依赖的技术革新以及这一领域未来的研究方向。 VPCT测试旨在评估模型对基于视觉的基础物理问题的理解和预测能力。测试中,模型需观察一些物理现象实例——例如一个球沿着不同配置的斜坡滚落并最终落入不同水桶的场景——并预测最终结果。虽然题目设计简单直观,但对机器来说却极具挑战,尤其是在需要推理物理因果关系的情况下。

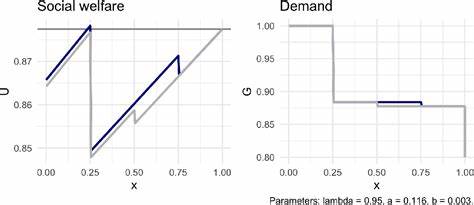

VPCT包含100个问题,涵盖多种斜坡形状及球体运动轨迹变换,考验模型的视觉感知及物理常识推断。 在人类的测试中,这类问题几乎轻而易举。实验数据显示,志愿者均实现了100%的正确率,表明普通人对这类视觉物理问题的理解非常自然且无障碍。然而,从过去对视觉语言模型的测试结果来看,许多领先的模型表现并不理想,甚至徘徊在随机猜测水平(约33%左右)。这一现象反映了模型在跨模态推理和物理因果推断方面的不足。 近年来,随着大规模语言模型及多模态模型的快速迭代,VPCT的测试成绩出现了令人鼓舞的变化。

例如,Claude系列模型(版本3.5、3.7至最新的4 Sonnet)以及谷歌旗下的Gemini 2.5 Pro系列模型均展现出显著的性能提升。其中,Claude 4 Sonnet版本的表现尤为突出,准确率已大幅超越此前的随机猜测水平,达到50%以上,且未来版本的升级预示着更高的潜力空间。较之早期模型,这些新一代模型已不再局限于单纯的语言理解,而是在视觉数据处理与物理推理中融合了更复杂的能力。 这种进步的背后有着多方面的技术驱动。首先,强化学习(Reinforcement Learning, RL)的引入为模型提供了优化推理策略的有效手段。通过引导模型不断试错和调整预测,RL极大提升了模型的物理场景理解与准确推断的能力。

其次,融合视觉和语言的多模态学习框架更加完善,通过联合训练大规模图片及文本数据,模型在捕捉视觉信息细节和语言表达关联时更为精准,从而更好地进行跨模态推理。同时,扩容参数和增加训练数据的规模,也为模型学习复杂物理规则和动态场景提供了基础。 Claude 3.7 Sonnet和Gemini 2.5 Pro(特别是2025年6月版本)在VPCT上的成绩平均提升至40%至50%区间,明显领先于以往三十几百分点的猜测水平。某些特定任务或模型版本甚至突破60%。这标志着大型语言模型不仅在传统的语言理解任务上逐渐趋近甚至超越人类表现,在视觉物理推理领域也迈出重要一步。 未来,VPCT及相关测试无疑将成为AI系统评估的重要标杆。

提升模型对物理世界的直观理解能力,将有助于开发更智能、更接近人类推理水平的通用人工智能。具体而言,下一步技术重点可能集中在更细致的因果关系推断、动态场景模拟、实时交互性增强等方向。通过结合更多现实世界物理规律和复杂环境多样性,模型的泛化能力与实用价值将显著提升。 此外,这一趋势对工业界的影响同样深远。具备较强视觉物理理解能力的模型可广泛应用于机器人导航、自动驾驶、智能监控、医疗影像分析及教育辅助等领域。它们有望赋能机器智能更准确地理解周围环境做出合理判断,显著降低风险,提升效率与安全性。

综上所述,VPCT在大型语言模型领域的表现进步充分体现了近年来人工智能技术在视觉推理和物理认知维度的创新发展。虽然距离完美模拟人类认知仍有较远距离,但现有成果表明AI具备快速追赶并超越过去限制的潜力。未来随着算法优化、数据质量提升和计算资源增强,视觉物理理解必将成为AI智能化进程中的重要里程碑。持续关注这一领域的进展,将为理解和预见人工智能的未来发展提供重要视角与参考。