随着人工智能技术的快速发展,大型语言模型(LLM)在各类智能应用中的作用日益凸显。传统上,大型语言模型的推理与逻辑处理通常集中部署于后端,确保安全性和数据隐私。然而,随着产品创新速度的不断加快,后端频繁部署导致的迭代缓慢,成为团队发展的瓶颈。本文以一次具体的项目经验为基础,探讨将LLM逻辑迁移到前端的实践过程、优势、风险及应对措施,为相关开发者和技术管理者提供参考。 在我们的初始架构中,整个LLM的推理流程和Prompt(提示语)管理全部由后端承担。前端仅承担基础的用户界面交互功能,向后端发送请求,等待后端处理完毕返回结果。

这种架构最大的优势是安全性高,所有核心算法、API密钥及业务逻辑均集中管理,易于管控权限、日志以及访问频率限制,从而保证数据隐私和系统安全。 然而,随着产品需求的不断变化和用户界面的迭代,Prompt与AI逻辑调整的节奏明显加快。每一次Prompt的微调,都需要后端重新部署,耗费大量时间和人力资源。后端频繁部署不仅影响开发效率,更在团队协作中形成瓶颈,限制了前端快速响应用户需求的能力。这种体制下,前端团队只能被动等待后端更新,创新灵感难以即时得到验证,用户体验的优化也受到限制。 面对这一困境,我作为团队的技术负责人,决定尝试一种更灵活的架构设计:将AI逻辑、Prompt管理和调用流程的编排从后端迁移至前端。

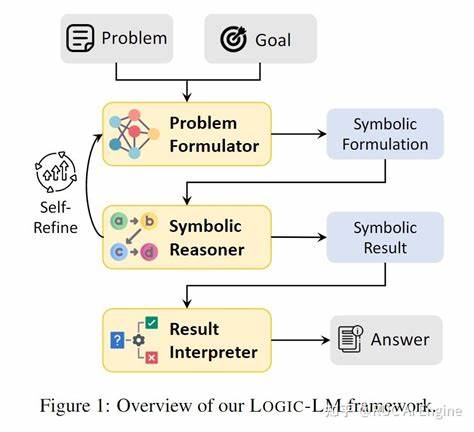

后端仅保留密钥管理、业务数据接口以及安全代理的功能。该架构创新在于让前端直接负责OpenAI SDK的调用(通过安全代理),在浏览器端完成Prompt模板的迭代与调整,甚至管理多步对话的流程和工具调用。 通过这一转变,前端团队获得了更大的自主权,能够快速测试和上线新的AI交互功能,无需等待后端频繁部署。开发流程明显加速,团队的整体创新氛围和响应速度都得到了显著提升。用户体验得以实时优化,应用的智能化程度不断进阶。 然而,前端承载更多核心逻辑的同时,也带来了不少安全挑战。

由于OpenAI API的调用必须通过后台代理以防止API密钥泄露,后端代理必须实现严格的认证、调用记录、成本控制和访问限制。否则,若前端直接暴露部分业务逻辑,极易导致滥用、数据泄露甚至业务风险。 因此,架构迁移不仅是技术实现的转变,更要求后端和前端团队在安全策略、权限管理和资源监控上携手保障系统健壮性。我们设计了一套多层防护机制,确保代理请求合法,监控API调用频率并及时报警,同时限制敏感操作只能在后端完成。通过细粒度的角色权限划分和日志分析,实现了安全与灵活性的平衡。 此外,前端技术栈的发展也为这一转变提供了坚实基础。

现代浏览器及前端框架支持更复杂的数据处理与异步任务管理,使得LLM交互流程可以在客户端高效执行。通过结合前端缓存、状态管理和API聚合,用户体验更流畅,聊天机器人应答更及时,界面交互更灵活多变。 总结来看,将LLM逻辑转移至前端的架构革新,成功打破了传统后端部署带来的效率瓶颈。团队开发灵活性大幅提升,市场反馈周期缩短,新功能迭代迅速,有力支持了产品的持续创新。与此同时,该策略提醒我们关注系统安全边界的重构,在保障数据安全与API密钥隐私的基础上,打造合理的客户端与服务器分工体系。 未来,随着边缘计算和前端算力的提升,LLM在客户端的运行和管理将变得更加普遍和高效。

结合本次实践经验,企业可根据自身业务场景,权衡安全需求与创新速度,灵活选择AI架构部署方式。通过合理设计前后端职责边界,强化安全防护,实现AI驱动产品的快速发展和高质量交付。 此次架构调整不仅为项目带来了显著的绩效提升,也为我个人积累了宝贵的技术管理经验。相信随着行业的不断进步,更多团队将探索基于前端的AI逻辑管理,实现更敏捷、更智能的产品迭代。