PostgreSQL作为目前最流行的开源关系型数据库系统之一,以其高性能、高可靠性和丰富的功能深受广大开发者和企业青睐。通常,围绕Postgres性能的讨论和研究都是为了如何让其运行更快、更高效。然而,本文将从一个截然不同的角度出发,深入解析如何通过合理调整PostgreSQL的配置参数,将其性能极端恶化,甚至达到降低42000倍之多。这不仅是一场有趣的技术实验,也能帮助数据库管理员更清晰认识性能调优中的关键因素。通过这次探索,我们能够更好地理解Postgres引擎内部的工作机制以及参数调节对系统表现的巨大影响。首先,性能巨幅下降的第一步在于减少缓存大小。

Postgres在性能优化中极度依赖于内存缓存,特别是shared_buffers参数,这个参数决定了数据库用来存储数据页的共享内存大小,缓存越大,数据读取的响应时间越短。将默认的10GB缓存缩减到仅仅8MB,会导致缓存命中率急剧下降,读取请求不得不大量访问磁盘,导致系统调用次数激增,性能骤降近300倍。试图进一步缩小缓存至仅128KB失败,因为这个大小无法满足Postgres并发访问基本需求,经过调试,将shared_buffers调整为2MB,系统还能维持运行,但性能降至不到500每秒事务处理能力。具备一定内存缓存的基础虽不足,却保证了数据库至少能完成最基本的运行,这也是实验原则之一。除了缓存之外,设置Postgres进行大量后台任务是另一个重灾区。数据库的autovacuum进程旨在清理无用数据和统计信息,保障查询计划的准确和避免存储空间浪费。

但将自动清理的阈值调整到极低,例如将autovacuum_vacuum_insert_threshold设为1,以及将其他阈值和比例全部归零,迫使autovacuum频繁运行,几乎每秒都对数据表执行清理和分析操作,严重拖慢主业务进程。维护操作时耗的CPU资源和磁盘I/O迅速上升,导致系统吞吐能力锐减至初始状态的二十分之一。进一步结合日志分析,我们可以看到每秒多次的自动真空和分析操作,表明数据库忙于后台维护,主业务响应明显受阻。针对日志中的checkpoint和WAL(Write-Ahead Log)相关配置的调整,是降低性能的另一大关键。Postgres利用WAL保证事务的持久性,将修改先写入日志后再应用到磁盘数据文件中。通常系统会适当批量提交和延迟写入以优化性能,但将wal_writer_flush_after设置为0,强制所有WAL变化立刻同步写入磁盘,同时将max_wal_size和min_wal_size减到最低,频繁发起checkpoint操作,导致大量I/O争用和等待,整个系统的响应速度下降到原始性能的百分之一以下。

日志记录显示,checkpoint操作距离极近且频繁发生,甚至有频率过高的警告,建议增加max_wal_size以缓解压力,但这里刻意保持其最低,目的就是极端降低性能。此外,调整random_page_cost和cpu_index_tuple_cost为天文数字,实质上取消了索引的价值,数据库查询规划器会倾向全表扫描,由于全表扫描涉及大量顺序扫描,利用硬盘顺序访问优势理论上能更快,但将缓存调低后,多次的随机I/O仍不可避免。如此一来,数据库执行计划丧失了优化索引的机会,查询效率大幅降低,实际检测到系统TPS(每秒事务数)甚至低于1,创下性能极限。最后,结合Postgres 18版本引入的新I/O控制参数,进一步将io_method配置为worker,并限制io_workers为1,令所有磁盘I/O请求只能由单个线程同步处理,彻底破坏并行I/O能力,令Postgres在多连接并发场景中成为性能瓶颈的焦点。此举配合前述配置,共同造成数据库承载能力跌落到了42000倍性能衰减的骇人境地。通过这次反向优化实验,很多性能提升的关键点得以揭示,也表现出Postgres调优系统的精妙设计——系统参数的限制就是为了避免配置导致性能瓦解。

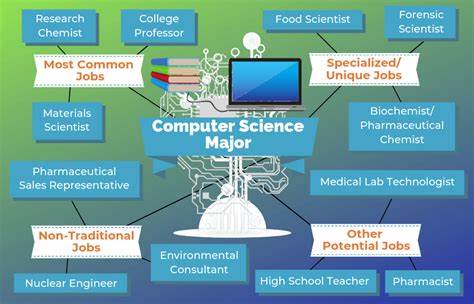

虽然在绝大多数生产环境中不会刻意让数据库变慢,但了解这些极限边界,有助于深入掌握Postgres的运行机制。在实际业务中,缓存大小、autovacuum策略、WAL参数、查询计划成本参数及I/O方式设置等都是影响性能的核心因素。合理调整这些参数,才能在高并发和大数据量场景下,保证系统高效稳定运行。总结来说,这场以“让Postgres变慢”为目标的实验,通篇只修改postgresql.conf配置,未触及任何代码或索引结构,却成功制造了极端性能瓶颈。它提醒我们,数据库不仅只是靠硬件或版本升级来获得性能提升,配置调优是不可或缺的关键环节。通过精准配置,Postgres才能发挥其最佳性能,而不合理的调整则可能让系统陷入瘫痪或极度卡顿的窘境。

除此之外,这个实验也为数据库从业者提供了宝贵思路:理解并掌握各参数的影响,对于排查性能问题和提升整体架构设计至关重要。适度降低某些操作阈值或更频繁地执行后台维护,并非总是提升体验的方法,反而往往带来意想不到的负面效果。今后,数据库性能优化必将越来越细致和多面向,只有系统全面把控配置、架构、硬件等因素调整,才能实现真正高效且可持续的数据库运行。最后,提醒所有数据库管理员和开发者,审慎修改数据库配置,充分利用其文档说明和官方推荐,避免盲目追求极端优化,保持平衡和稳定,才是长远之计。希望这场极致让Postgres变慢的奇妙试验,能为广大数据库爱好者和从业者带来启发和实用参考。