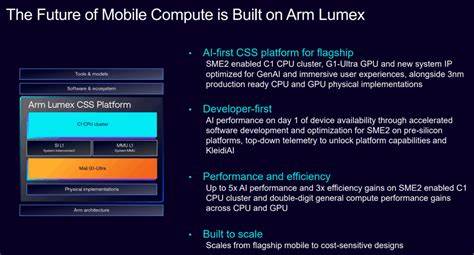

Arm正式发布Lumex平台,目标是为旗舰智能手机和下一代PC提供端侧AI的完整计算子系统解决方案。该平台将Arm最新的CPU架构与可扩展矩阵扩展第二版(Scalable Matrix Extension version 2,简称SME2)、高性能GPU以及系统级IP相结合,旨在在功耗和性能之间取得更好的平衡,并通过本地部署的AI能力提升用户隐私与实时性。对于芯片设计者、设备制造商、应用开发者和消费者,Lumex带来的不仅是性能提升,更有生态层面的协同价值和市场格局的潜在变化。 Lumex的技术构成和亮点值得深入理解。平台通过在CPU中引入SME2来大幅提升矩阵计算能力,这对深度学习推理尤其重要。Arm将SME2与基于Armv9.3的CPU集群配对,用于旗舰级设备,而C1-Premium则面向性能略低但仍需卓越AI体验的次旗舰机型。

此外,Lumex引入了Mali G1-Ultra GPU,强调了硬件对光线追踪和AI加速的支持,使得图形渲染与推理任务能够协同加速,满足未来影像处理、增强现实和沉浸式交互等场景对算力和能效的双重需求。系统级IP的集成则有助于缩短芯片开发周期,降低合作方的设计难度。对有意采用的平台伙伴而言,Lumex既可以作为现成模块直接应用,也可以按需定制进入自身片上系统(SoC)设计,提供了极高的灵活性。 在性能指标上,Arm宣称到2030年,SME与SME2技术将为多达30亿台设备新增超过100亿TOPS(每秒万亿次运算)的AI算力。无论这一预估能否完全兑现,其传达出的信息非常明确:Arm视端侧AI为大规模普及的方向,并期待通过授权模式把矩阵计算能力嵌入到更多设备中。这一策略对生态系统的影响深远。

对芯片厂商而言,Lumex不仅是性能模块,更是快速搭建AI能力的工具;对设备厂商而言,它意味着能够在差异化体验上更快迭代;对开发者而言,统一的硬件能力将帮助软件优化与模型部署效率的提升。 为何在当前时点推出Lumex具有战略意义?一方面,设备端AI需求正在爆发,图像生成、实时语音识别、智能相机与个性化推荐等功能越来越依赖低延迟与隐私保护,这些都推动了对本地算力的渴求。将更多推理计算从云端迁移到终端,可以显著降低响应时间、减少网络依赖并提高用户数据的本地化处理,从而缓解隐私与合规压力。另一方面,制造工艺的进步与异构计算架构的发展,使得在移动或笔电功耗预算内实现强大AI能力成为可能,Lumex正是顺应这种技术进步,将矩阵计算能力与图形渲染及系统IP结合以实现更高能效比。 生态与市场竞争层面也不容忽视。Arm的独特优势在于其授予架构与IP的商业模式,数以千计的芯片设计商依赖Arm的指令集与IP进行定制。

Lumex作为一种可授权的平台,将使Arm在端侧AI市场占据更有利的位置。与之竞争的则包括具有整合生态的厂商与专注AI加速的设计公司。高通与MediaTek等传统手机芯片厂商、NVIDIA与苹果等形成的各类组合,都是Lumex要面对的竞争对象。不同的是,Arm采取的是开放授权而非整机垂直整合的路径,这可能更容易实现大规模部署,尤其是在那些希望保持SoC差异化的厂商中更受欢迎。 对于设备制造商和SoC厂商而言,Lumex的灵活性是关键卖点。厂商可以选择直接采用Arm提供的参考实现,以缩短产品上市时间,也可以基于Lumex进行定制,整合自有的AI IP、优化电源管理策略或在制造工艺上做出差异化。

此种自由度意味着终端产品会在保有各自品牌与特性的同时,具备相对统一的基础AI能力,有利于跨设备体验的一致性和开发者生态的成长。软件层面,统一的硬件能力将促使开发工具链、编译器与AI推理框架逐步优化以适配SME2与Mali G1-Ultra,从而降低模型迁移成本并提升推理效率。 从消费者角度看,Lumex代表的最直观收益是更流畅的本地AI功能和更少对网络和云端的依赖。拍照时更快的图像处理、实时翻译更低的延迟、语音助手更强的离线识别能力、增强现实更高的帧率和更真实的渲染效果,这些都将直接改善终端体验。同时,本地化数据处理也提升了隐私保护能力,许多敏感数据无需离开设备便能完成智能化处理,这对于监管日益严格的市场尤为重要。 不过,Lumex的落地仍面临若干挑战。

首先,尽管ARM授权模式具有广泛影响力,但实际部署还取决于生态伙伴的采纳速度以及他们在工艺节点、功耗热设计等方面的实现能力。次旗舰和中端设备受限于成本与散热,而旗舰设备虽然更易承载高算力,但市场普及速度有限。其次,软件生态的成熟度将直接影响Lumex的实际价值。开发者需要时间优化模型以充分利用SME2与GPU协同计算能力,AI框架与编译器也需更新以提供更好的自动化支持。再次,竞争对手的动态也必须考虑。诸如苹果等厂商虽然不直接使用Arm平台化方案,但他们在自研芯片方面的领先、以及高通在移动端AI加速器上的优化,都对Lumex形成压力。

从市场策略角度,Lumex的成功在很大程度上取决于Arm能否与关键客户达成快速且广泛的授权部署。 在安全与隐私方面,Lumex通过强调端侧AI来提高用户数据保护能力。数据在设备本地处理不仅减少了数据传输带来的泄露风险,也降低了对云端服务的依赖。不过这并不意味着所有安全问题迎刃而解。设备本身仍需加强数据存储加密、安全启动与软硬件协同的威胁防护,以防止恶意模型或越权访问造成的危害。Arm与合作厂商在发布硬件时,往往需要同步提供安全建议与参考实现,确保平台在实际商业化过程中能够满足企业级与消费级场景的安全要求。

从产业链的角度来看,Lumex的出现或将加速终端AI算力的分布式扩展。过去,多数高性能推理任务依赖云计算中心,而随着端侧能力的提升,大量推理工作将转移到本地设备,从而改变云-边-端的算力分配与服务模式。云服务提供商可能需要调整其业务重心,专注于训练与模型托管,而推理服务则更多落在设备端或边缘侧。此外,Lumex的普及也可能催生新的软件服务与商业模式,例如基于设备本地推理的订阅式功能增强、本地模型个性化服务以及在隐私合规场景下的行业解决方案。 展望未来,Lumex能否成为行业标准的一部分,取决于几个关键因素。其一是合作伙伴的采纳速度与规模,尤其是主要的手机与PC芯片设计厂商是否将Lumex作为其产品路线的重要组成部分。

其二是软件生态的成熟程度,包括开发工具、推理框架与优化库的广泛支持。其三是市场对端侧AI隐私与低延迟需求的持续增长。若这些因素均向好,Lumex将在5G普及、AI模型轻量化优化及用户隐私意识增强的大背景下,成为推动端侧AI普及的重要引擎。 对开发者与厂商而言,如何准备以适应Lumex时代?关键在于掌握基于SME2的矩阵运算优化技巧、理解异构计算的任务划分原则以及熟悉Mali G1-Ultra在图形与AI加速方面的特性。优化模型结构以降低内存带宽需求、采用量化与蒸馏技术以在设备端实现更高的吞吐率与能效、以及在应用层设计更合理的任务裁剪与本地/云混合策略,都是现实而务实的步骤。对于希望在市场上快速推出创新功能的厂商而言,利用Lumex提供的参考实现加速产品验证与迭代,将显著缩短研发周期。

投资者与行业观察者也应关注Lumex可能带来的长期影响。Arm通过增强端侧IP的能力,进一步巩固了其在移动与嵌入式领域的地位,并有望在PC端获得更大话语权。然而,任何文明的技术迭代都伴随风险,生态采纳的不确定性、来自自研和封闭生态的竞争、以及宏观半导体供应链瓶颈,均可能影响Lumex的商业化速度与市场份额。因此,评估Lumex潜在价值时,应综合考虑技术可实现性、生态合作深度与全球供应链状况。 总结来看,Arm Lumex平台代表着一次面向未来端侧AI能力的系统性升级。它通过将SME2、Armv9.3 CPU集群、C1-Premium子系统、Mali G1-Ultra GPU与系统IP组合为可授权的平台,为设备厂商与SoC设计商提供了灵活且高效的路径来实现本地AI。

若生态合作顺畅并且软件堆栈迅速成熟,Lumex有能力推动更广泛的本地AI部署,提升用户隐私保护并为移动与PC终端带来更丰富的智能体验。对产业链各方而言,如何利用Lumex的灵活性、优化软件与硬件协同,以及在产品化进程中把控成本与功耗,将决定能否在下一波端侧AI浪潮中取得领先。 。