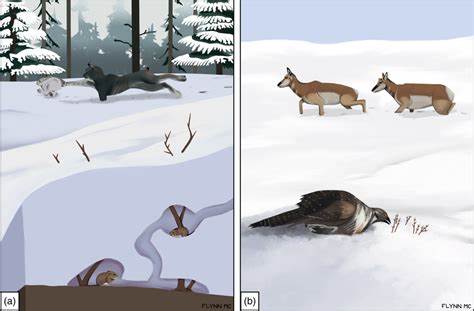

在现代编程世界中,性能和效率始终是开发者追求的重要目标。对于众多程序员来说,Vim作为一款强大的文本编辑器,以其轻量、高效和高度可定制的特性,在全球范围内拥有广泛用户基础。随着人工智能技术的迅速发展,将大语言模型(LLM)融入到编程流程变得越来越流行。LLviM作为一款基于Vim的本地大语言模型对话式编码插件,通过独特的交互方式革新了程序员的编码体验。本文将深入探讨LLviM的主要特点、安装及使用细节,并分析其对日常开发的积极影响。 LLviM诞生于对Vim用户需求的深刻理解和对AI技术的前瞻应用。

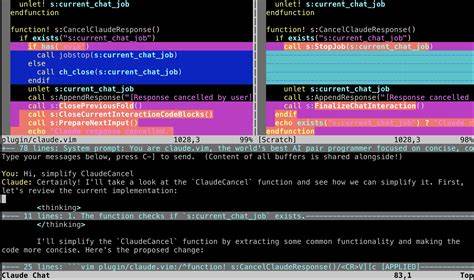

它的核心功能是通过与本地或远程运行的LLM服务器对话,实现代码片段的智能重写、扩展及改写。在传统编辑过程中,开发者常常需要手动编写或者调整复杂代码。利用LLviM提供的一键发送选中代码片段至语言模型进行处理,能够显著减少重复劳动,快速产出质量更高的代码。 一个显著的优势是LLviM允许用户在Vim内部打开一个专用的聊天窗口,用户可以直接在该窗口中输入指令,向语言模型说明需求,如“重写此函数以提升性能”或“根据测试样例调整此算法”。生成的代码块会自动复制到指定的寄存器,实现无缝插入和复用,极大提升了编程流程的流畅度及效率。 LLviM还支持多种运行模式。

在插入模式下,用户可以通过快捷键快速将当前行或默认寄存器中的内容发送至后端,大幅度简化了对局部代码的交互编辑;在可视模式下,选中多行代码并调用插件,则可以针对特定代码块进行重写;而在普通模式下,利用命令不仅可以发送整份文件,还能同步多文件内容,方便在复杂项目和大规模代码库中完成上下文感知的代码生成。 安装过程相对简单。用户需先编译并运行支持的本地模型服务器,如llama.cpp或类似项目,选用如deepseek-coder等兼容模型,可满足大部分语言和任务需求。插件的核心文件llvim.vim需要放入Vim的autoload目录,结合自定义的Vim配置文件键绑定即可启用。常用快捷键包括CTRL-K用于触发生成操作,CTRL-B用以打开或关闭对话窗口,整体交互设计直观,入门门槛较低。 使用LLviM时,插件会自动收集当前文件及缓冲区上下文,并发送至语言模型,为代码生成提供充分背景信息。

这种设计确保生成结果不仅符合语法规范,更贴合项目的具体逻辑和风格。同时,LLviM还允许用户通过变量和自动命令灵活覆盖默认参数,如生成温度、最大预测长度等,更细致地把控AI生成文本的多样性和准确性。这样,用户能够根据不同文件类型或项目需求调整模型行为,提升代码质量和实用性。 尽管LLviM在提升Vim编辑器智能化水平方面表现突出,但其目前还存在一些限制。例如,在代码生成过程中如果编辑缓冲区被操作,可能导致异常或整个Vim崩溃。开发者已经注意到此问题,后续版本计划通过更稳定的异步处理机制改善用户体验。

此外,目前同一时间只建议打开一个Vim实例使用LLviM,以避免上下文缓冲区冲突带来的混淆。虽如此,插件依然凭借其开放性和兼容性被热情拥护,尤其是对于喜欢掌控本地数据和隐私的技术爱好者。 其与其他类似工具如llama.vim的设计初衷有所差异,LLviM刻意避免与其冲突,使用户能够根据需求灵活选择或同时使用,丰富了Vim生态内的AI辅助编码方案。兼容多个主流量化模型,以及对远程API服务器的支持,也方便了不同硬件环境的开发者无缝切换。 LLviM的出现为传统Vim编辑器注入了新的生命力。它结合了最前沿的人工智能技术与经典编辑器的高效响应特性,实现了一种自然、便捷且功能强大的交互式编程体验。

无论是进行代码重写、测试用例调整还是功能扩展,开发者只需通过简洁的指令与模型对话即可完成复杂任务,极大节省时间和精力。 展望未来,随着本地大语言模型技术的不断成熟,LLviM以及类似插件在代码辅助创作、自动化维护和智能调试方面的潜力将被进一步挖掘。插件开发者社区的持续参与、用户贡献的使用反馈及生态环境的不断完善,无疑将促使这类工具愈加智能和易用。此外,更加安全的权限控制和多实例支持也将丰富插件的适用场景。 总结来说,LLviM凭借其紧密集成Vim环境、强大的上下文感知能力和灵活多样的交互方式,成为了适合技术极客和实用主义者的理想选择。它不仅赋予了Vim用户利用大语言模型的强大力量,还推动了传统文本编辑器迈向智能化新时代。

对于渴望提升开发效率和代码质量的程序员而言,试用并掌握LLviM将是走向高效编程的重要一步。