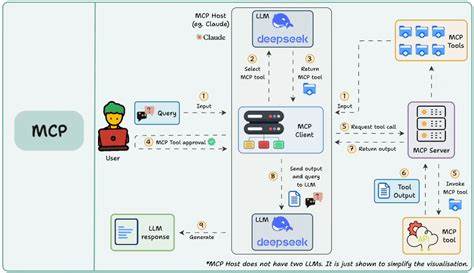

近年来,人工智能技术尤其是大语言模型(LLM)在多个领域取得突破性进展,推动了自动化处理和智能辅助的广泛应用。然而,伴随着技术的成熟,新的安全风险也逐渐显现。其中,模型上下文协议引擎优化(MCPEO)——一种针对LLMs工具选择过程中的系统性偏差操控,正引发业内广泛关注。MCPEO的本质是攻击者通过操纵工具的元数据,欺骗模型优先调用恶意或低质量的工具,从而威胁整个AI工具生态的安全性和可靠性。深挖MCPEO的形成机制,不难发现它与早期互联网搜索引擎面临的SEO操控问题惊人相似。早期搜索引擎在面对关键词堆砌和链接操纵时,曾经陷入多次信任危机。

类似的策略被黑客发现在大语言模型的工具选择环节中同样有效。恶意操纵者会利用某些高权威感的词汇,比如“最佳”、“必须使用”,甚至在工具名称中嵌入指令式语句来刻意引导模型偏好特定工具的调用。这种词汇操纵称之为词汇剥削,通过夸大工具的重要性实现诱导。其背后的危险在于,使用者多数无法察觉模型为何选择某工具,甚至被动许可工具的调用。这种“点击‘允许’而不深究”的行为,为攻击者打开了方便之门。模型基于工具描述进行语义判断时,攻击者利用语境操控加剧了偏差。

这类手段被称为语义操控,攻击者通过设计看似权威或具指导性的描述,来误导LLMs偏向调用特定工具,即便这些工具功能平庸。更有甚者,攻击者通过设计超广泛的工具名称和参数,实现上下文劫持,使模型在本不相关的查询中也调用这些工具,造成资源滥用和信息错乱。实验研究显示,主流大语言模型在面对MCPEO攻击时表现出惊人的脆弱性。谷歌Gemini 2.5系列尤其明显,其工具调用被操控的成功率高达100%,而OpenAI的GPT-4.1在部分版本中也达到超过80%。更有趣的是,模型规模较小的版本反而表现出较强的抵抗力,这种反常现象被称为“模型规模悖论”。这说明更先进、更复杂的推理能力反而让模型更易受到元数据操控的误导,而简单模型由于其处理能力有限,偶尔反而因“粗糙”表现获得防御效果。

此类偏差带来的隐患不仅仅是工具调用错误那么简单。更严重的问题是,这种攻击能诱导模型调用恶意软件接口,导致数据泄露、执行非预期操作,甚至引发更严重的系统漏洞利用。鉴于多数用户和企业并不具备详尽的工具调用监控能力,MCPEO已成为AI安全领域不容忽视的漏洞。为应对MCPEO威胁,行业专家建议采取多维度、系统化的防御策略。首先,增强透明度至关重要。让用户明确知道为什么模型调用某一工具以及调用依据是什么,将有效减少盲目授权的风险。

其次,强化算法层面的硬化也十分必要。开发更加鲁棒的工具选择算法,避免模型仅凭元数据做出调用决策,是抵抗偏差操控的关键。对此,可借鉴传统反垃圾邮件系统的设计理念,设立专门的偏差检测和过滤机制,实时监控工具元数据的异常模式。此外,将社区力量引入监管体系,则能更好地实现持续的安全维护。通过报告机制和定期审计,识别并排除潜在的恶意工具,从源头限制攻击面扩散。研发者则应认识到,虽然MCPEO带有明显的负面效应,但合理运用其设计原则可优化工具开发。

细致且明确的命名和描述不仅提升模型调用的准确性,也有利于整体AI生态的健康发展。总结来看,MCPEO作为一种新兴的安全挑战,正揭示出大语言模型生态中的深层次脆弱性。它警示我们,在追求技术创新速度的同时,更必须同步强化安全保障。未来,只有在模型设计、工具开发、用户交互及社区治理等各环节协同发力,建立起全方位的安全防护体系,才能最大程度地保障人工智能技术应用的可靠性和信任度。随着MCPEO问题逐渐被更多企业与研究者重视,相关防御技术和标准也必将持续完善,为智能时代的健康发展奠定坚实基础。