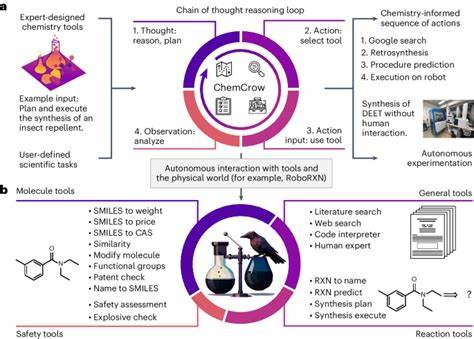

近年来,随着人工智能特别是大型语言模型(LLMs)的迅猛发展,其在化学科研和教育中的应用引起了广泛关注。传统上,化学领域的复杂知识和严谨推理被认为是人类专家不可替代的优势。然而,随着技术的提升,越来越多的研究表明,大语言模型不仅能够理解和生成化学相关的文本内容,甚至在多项测试中展现出超越某些化学专家的表现。 大型语言模型是基于深度学习技术,通过训练海量文本数据而成的模型。它们具备强大的自然语言处理能力,能够回答问题、进行推理、生成文本,甚至协助设计化学反应和材料。当这些模型应用于化学领域时,它们可以处理分子结构的描述、预测化合物性质、解释化学现象等任务,为科研人员提供智能助手的可能性。

然而,尽管大语言模型的表现令人瞩目,它们依然存在无法忽视的不足。模型在某些基础性知识问题上表现不佳,并且在推理复杂化学结构时常常出现混淆。此外,这些模型倾向于给出过于自信的答案,而缺乏能准确评估自身局限性的能力。这在涉及化学安全性和毒性等关键领域尤为突出,错误信息可能带来严重后果。 为了系统化地评估大型语言模型在化学知识和推理方面的能力,一项名为ChemBench的自动化评估框架被提出。该框架收集了来自教科书、考试题库及自动生成的2700多个化学问题,覆盖从基础到高级的多个化学分支。

通过与19位不同领域的化学专家进行对比测评,ChemBench揭示了当前最先进模型的整体优于大多数人类参与者的表现,但在细节问题上仍有显著差距。 令人惊讶的是,一些开源的大语言模型已能与专有模型相媲美,显示出人工智能民主化的重要趋势。这意味着更多科研人员可以利用先进AI工具,而无须依赖昂贵的商业产品,推动科学研究的普及和创新。此外,基于ChemBench的细致评估结果表明,模型表现强弱与模型规模呈正相关,提示继续扩展模型规模可能带来性能的提升。但规模并非万能,训练数据的专业性和多样性同样关键。 不同化学子领域的表现差异也引人关注。

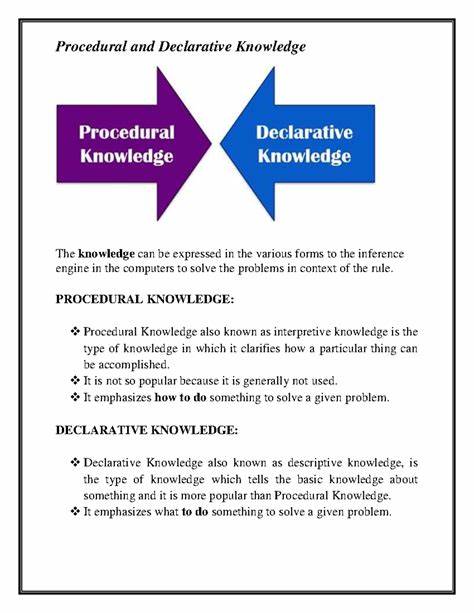

通用和技术化学类问题模型答题正确率较高,而在分析化学和安全毒理等领域表现较差。例如,核磁共振信号数预测题目中,顶尖模型的正确率不足三成,显示其在分子结构空间推理上的欠缺。原因之一是模型只能处理文本和SMILES形式的分子描述,而无法像人类通过分子图形直观理解复杂结构,这为未来多模态输入的开发提供了方向。 此外,模型在应对化学直觉和偏好判断方面表现平平。药物开发中的分子优选是一项高度经验化、主观性强的任务,当前大型语言模型很难准确模拟人类专家之间的判断一致性。这表明未来训练策略或需引入偏好学习和专家反馈,以提升模型与人类判断的对齐程度。

一个不可忽视的问题是模型的置信度估计能力。研究发现,大多数模型难以准确判断自身回答的正确性,甚至在关键安全问题上出现高置信度的错误。缺乏可靠的不确定性评价机制,限制了模型在实际科研和教学中作为辅助工具的信赖度。因此,开发更精准置信度校准和自我监控方法,是提升化学大语言模型安全性和实用性的核心任务之一。 在教育层面,模型的崛起也促使我们重新思考化学教学和考核方式。由于大型语言模型在记忆和标准考试题目上拥有显著优势,单纯依赖传统考试评价学生能力的模式将面临挑战。

更多注重创新思维、结构推理和实际问题解决能力的教学设计,将帮助学生在人工智能辅助环境中保持竞争力。 尽管目前依然存在诸多限制和风险,大语言模型在化学领域展现的强大能力彰显了其作为研究助手、教育辅助和知识管理工具的巨大潜力。通过持续优化模型结构、丰富专业训练数据、整合多模态信息以及强化安全策略,这些模型有望成为化学家们不可或缺的智能伙伴。 在未来,构建可解释、可靠且具备自主学习能力的化学大语言模型,将极大加速科学发现的步伐。同时,通过开放共享的评估框架如ChemBench,科研社区能够协同推动技术进步,并确保人工智能应用符合伦理与安全标准。人工智能与人类专家的优势互补,将共同开启化学研究和教育的新篇章。

。