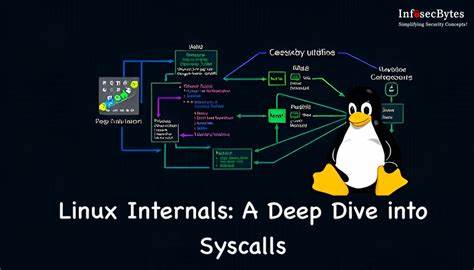

系统调用是用户程序与操作系统内核交互的桥梁,是实现文件操作、进程管理、时间获取等关键功能的基础。然而,尽管系统调用功能不可或缺,但其代价却异常昂贵,往往成为系统性能分析中的热点。无论是开发人员还是系统架构师,都对系统调用为何如此"重量级"感到好奇。深入理解这一现象背后的内核机制和处理器微架构影响,有助于更好地设计高效的软件和系统。 系统调用的高成本,表面上看是进入内核执行的代码需要特殊权限并执行复杂操作,但其远不止于此。多年来,硬件设计的微观优化手段让CPU能够高效执行指令,譬如深度流水线、多发射执行和分支预测等技术。

当用户态程序发起系统调用,通过特殊的指令(如x86-64上的syscall指令)进入内核态,这一转换不仅仅是权限的切换,更牵涉到处理器状态的切换和重建。 在x86-64架构下,用户态程序将系统调用编号放入rax寄存器,其余参数按约定放入rdi、rsi、rdx等寄存器后,执行syscall指令。CPU接收到该指令后,进入内核态,切换到内核的堆栈和页表,保存用户态重要寄存器以便后续恢复,并调用内核内部对应的系统调用实现函数。完成后,内核同样将结果放回rax寄存器,逆向恢复用户态环境,最后通过sysret指令返回用户空间。 这条路径看似简洁,但背后涉及到的状态恢复和保护机制极为复杂。首先,内核需要通过切换CR3寄存器指向内核页表以访问内核空间。

然后,因内核与用户存在不同的上下文环境,CPU必须保存用户的堆栈指针,切换为内核堆栈执行,从而确保内核数据安全。恢复到用户空间时,则要反向执行这一流程,保证用户态代码环境如初。 除了硬件权限和内存环境的切换,处理器微架构的状态变更是系统调用开销的重中之重。在系统调用过程中,CPU内部的指令流水线需被清空,防止尚未完成的指令影响内核代码执行。这就像工厂流水线在更换生产线时需要停顿和清理,保证新一批产品不会受到前一批次的干扰。流水线被清空后,重新填充和达到满负荷运行状态需要一定周期,这无形中造成了性能损失。

处理器的分支预测器,也被系统调用的切换严重影响。分支预测是现代CPU的重要优化手段,它通过记录历史分支信息来预测程序流程,从而实现指令的预取和并行执行。但是,在系统调用进入内核时,为防范潜在的安全漏洞(例如Spectre和Retbleed等利用分支预测机制的攻击),Linux内核会清空分支历史缓冲区和返回地址栈。恩拓清空后的预测器失去"记忆",导致用户态代码在系统调用后的一段时间内分支预测命中率下降,大量错误预测引发流水线刷新,进一步拖慢程序执行。 这些安全措施是近年来应对CPU漏洞的新响应,但它们代价不小,进一步加剧了系统调用的间接性能损失。不同CPU型号对这些微架构攻击的缓解特性的支持程度不同,有些较新的处理器引入了增强型间接分支限制(Enhanced IBRS)等硬件特性,部分减少了软件层面的强制清空动作,从而缓和性能影响。

除了流水线与分支预测破坏,系统调用期间缓存污染同样是性能杀手。内核代码和数据载入CPU缓存,占用了用户态程序的缓存空间。虽然后续的缓存回收遵循LRU等算法正常进行,但频繁系统调用可能导致缓存被替换,用户态数据回填缓慢并影响执行效率。更多复杂的缓存一致性和内存屏障机制参与,也使得性能开销进一步叠加。不过,相比流水线和分支预测器的清空,这部分缓存影响更加微妙且依赖具体硬件实现。 那么,系统调用的直接开销如何量化?研究表明,简单系统调用如clock_gettime在现代CPU上通常需要约一千多CPU周期,相比仅仅几百周期的用户态函数调用,差距极大。

Linux通过虚拟动态共享对象(vDSO)机制将某些系统调用代码映射到用户空间,减少进入内核次数,实现性能大幅度提升。例如clock_gettime的vDSO调用能够比传统syscall调用快近十倍。 理解了系统调用的成本来源后,自然带来思考如何优化避免这些开销。开发者可以优先利用vDSO等内核提供的用户空间接口实现时间、环境变量等读取,避免无谓跨越内核边界。对于频繁I/O操作,采用缓冲区、批量读写或mmap映射方式替代小规模频繁系统调用,也能削减开销。新兴的io_uring架构允许用户态组织多个I/O请求,然后一并提交给内核,极大地减少用户态与内核态切换次数。

此外,借助eBPF技术,将部分应用逻辑直接移至内核执行,避免了重复调用和数据拷贝,是系统调用优化的前沿趋势。 缓存系统调用结果、合理设计程序流程逻辑,减少不必要的同步原语调用,也是一种行之有效的减少系统调用策略。例如读取系统时间可以按需读取并缓存,除非环境发生变化才重新读取,避免循环中多次访问内核。 总体而言,系统调用的高昂成本并非单纯的代码路径执行长短,而是CPU微架构在切换内核态时所需重建优化状态的复杂代价。流水线排空、分支预测器清空、返回栈失效、缓存污染等诸多因素,将影响传递到调用系统调用的用户态程序,带来可观的性能折损。 未来随着CPU厂商逐步推出硬件级安全隔离和状态切换优化,系统调用的这些开销或将逐步减少。

与此同时,软件层面的优化技术和设计理念依然不可或缺,合理利用内核提供的工具与功能,将系统调用次数降至最低,依然是提升程序效率的关键途径之一。 深入了解Linux系统调用的复杂性与底层实现,对于希望构建高性能应用的开发者极具价值。掌握系统调用的开销来源与优化手段,有助于避免性能损失,打造既安全又高效的现代软件系统。在当今性能驱动的开发环境中,这样的底层洞察尤为重要,不仅提升代码质量,也为系统架构提供坚实基础。 。