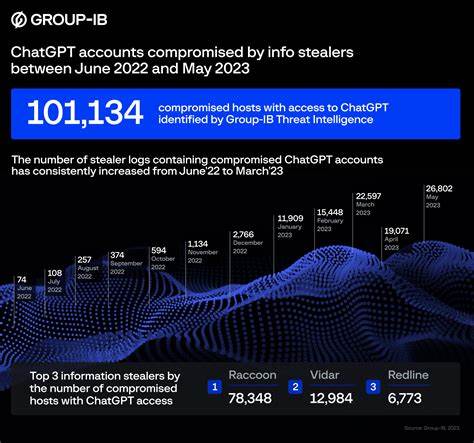

近年来,人工智能技术的飞速发展引发了广泛的关注,其中ChatGPT作为领先的语言模型之一,为用户提供了丰富的对话体验和智能服务。然而,随着AI应用的普及,关于ChatGPT数据安全的疑虑也逐渐浮现,尤其是有关其数据可能被泄露的可能性。本文将详细探讨ChatGPT数据被泄露的潜在风险、影响以及如何加强数据保护,从多个角度解读这一备受关注的话题。首先,需要理解的是ChatGPT背后的数据和模型训练所依赖的庞大数据集。AI模型的构建过程中,通常会使用公开数据和经过许可的数据来训练模型,以增强其语言理解和生成能力。但是,任何数据传输和存储的环节都存在安全隐患,包括黑客入侵、内部人员泄露以及第三方服务安全性不足等问题。

最近网上流传的关于某用户在使用ChatGPT进行AI专利工作的过程中,收到了多次来自Linkedin的异常连接请求,这些请求来自疑似与中国AI相关领域人士的账号,这一现象引发了人们对于ChatGPT数据安全的广泛讨论。这些请求账号的运营者甚至是长时间未活跃的虚假资料,进一步加剧了安全风险的猜测。尽管目前尚无确凿证据表明ChatGPT具体的数据被泄露,但这种现象提醒我们必须高度重视AI数据安全问题。数据泄露不仅可能威胁用户隐私,还可能对企业知识产权造成重大损失,尤其是在涉及创新技术专利和商业秘密时。面对这一风险,AI开发者和平台运营商必须投入更多资源加强安全防护措施。技术层面,采用先进的加密技术保护数据传输过程、防范中间人攻击,同时确保数据存储环境的安全隔离,防止非法访问。

严格的权限管理制度可以限制内部人员对敏感数据的访问权限,减少事故发生的概率。除了技术保障,政策法规同样重要。随着人工智能技术渗透到各行各业,完善的法规体系将成为保护用户数据和企业机密的基石。例如,加强对AI数据使用的透明度要求,明确数据所有权和使用范围,设立严格的违规惩罚机制,都是保障安全的重要环节。用户自身也应增强安全意识。避免在公共或不安全网络环境中输入敏感信息,定期更新密码,不轻易点击可疑链接或接受不明来源的联系人邀请。

同时,企业在选择AI服务平台时,应仔细审核平台的数据保护措施,确保符合行业安全标准。此外,AI技术本身的发展也应强调隐私保护。发展差分隐私、联邦学习等技术,通过在不暴露原始数据的前提下进行模型训练,有效降低泄露风险。多方协作和技术创新相结合,方能为AI数据安全筑起坚固屏障。总的来说,ChatGPT及类似AI产品在带来便利和创新的同时,数据安全问题不可忽视。公众、企业、技术开发者和监管机构需密切合作,共同构建安全、可信赖的AI生态环境。

通过技术升级、政策完善和用户教育等多方面努力,才能最大程度地降低数据泄露的风险,保障AI技术健康持续发展。未来,随着AI技术日益深入生活的各个层面,数据安全的重要性将愈发凸显。只有不断提升安全防护能力,才能让智能科技真正成为推动社会进步的正能量,而非潜藏风险的隐患。 。