在人工智能迅猛发展的时代背景下,AI推理成本的优化成为行业内广泛关注的焦点。Tri Dao,作为Together AI的首席科学家兼普林斯顿大学教授,近期在Unsupervised Learning Podcast中深入分享了推理优化的最新进展。他所创造的Flash Attention和Mamba技术,以及对推理系统的整体设计思路,标志着当前AI硬件和软件在推动性能提升和成本降低方面迎来了一次重大变革。Tri Dao认为,自ChatGPT发布以来,推理成本已下降了100倍,这背后关键在于内存优化、稀疏性技术以及硬件与软件的紧密协同设计。他还预测,随着这些技术的逐步成熟和应用,AI硬件生态将打破目前Nvidia占据的90%市场份额,实现更加多元和竞合共存的格局。过去几年,Nvidia因其强大的GPU架构和生态系统在AI推理领域取得了主导地位,但同时也带来了推理效率和成本的瓶颈。

Tri Dao指出,未来的硬件设计需要更深层次地结合软件算法,特别是在数据访问模式和模型结构的适配上做出创新。例如,Flash Attention通过优化内存访问和减少计算冗余,大幅提高了模型推理效率,而Mamba则在稀疏性和参数利用方面实现了突破,有效压缩了计算资源需求。推理性能的提升不仅仅体现在硬件加速器频率的提升或芯片面积的增大,更重要的是实现硬件设计与算法的协同创新。Tri Dao强调,硬件软件的协同设计能满足AI模型大型化对资源和时延的挑战,这种跨领域融合是未来AI推理系统发展的关键。另一方面,稀疏技术的兴起成为降低推理成本的另一重要驱动力。通过智能化地跳过不必要的计算,稀疏模型不仅能保持甚至提升模型准确率,还显著降低了计算负载和能耗,极大地优化了整体推理效率。

Tri Dao预计,未来的AI推理技术将会围绕稀疏化、低精度计算、量化以及内存访问优化等方向展开,带来性能和能耗的深度提升。此外,随着新兴芯片厂商和架构的涌现,行业内的竞争和创新正变得日益活跃。曾经壁垒较高的硬件市场,受益于开源项目与基础工具链的多样化,推动更多公司参与到AI硬件的创新中来。Tri Dao相信,这种多元化的生态将打破单一厂商主导的局面,推动AI硬件市场走向更加健康和富有活力的发展阶段。从长远来看,AI推理技术的进步不仅会显著降低成本,还将催生更多实际应用场景。例如,自动驾驶、智能安防、语音识别等领域均对推理速度和实时性提出了极高的要求。

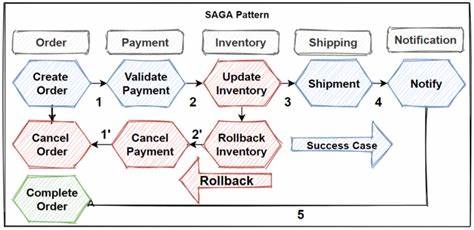

通过Flash Attention和Mamba等技术,这些应用的性能瓶颈得以有效缓解,推动产业升级和智能化转型。此外,Tri Dao还谈到未来AI系统的架构趋向模块化、灵活性增强和适配多样化硬件环境。随着AI模型种类与规模不断扩增,系统设计必须兼顾通用性与定制化,最大化利用硬件潜力。这种设计理念不仅提高了系统的可维护性,也利于生态系统成员协同创新,促进整个行业繁荣发展。从AI推理的实际开发角度来看,针对不同应用场景进行针对性优化成为常态。通过深度剖析模型结构和功能模块,开发团队可以结合Flash Attention等技术,降低内存带宽瓶颈,提升计算资源利用率,从而实现推理速度的显著提升。

Tri Dao的观点和技术创新为产业界带来全新视角,推动AI推理进入更高效、更经济的发展阶段。在这场硬件与软件共舞的变革中,未来AI推理不仅要实现10倍、100倍速度提升,更要实现能耗的跨越式下降,助力智能应用普及于千家万户。总之,Tri Dao在Unsupervised Learning Podcast的分享为理解当前AI推理优化的方向提供了重要参考。Flash Attention和Mamba等技术的应用展现了软硬件协同设计的巨大潜力,也预示着AI硬件格局正迎来多元化和创新驱动的新时代。未来,随着这些技术与生态的扩展,AI推理速度将再攀新高,成本持续下降,这对学术研究和产业发展均具有深远意义。 。