在数字化和人工智能迅猛发展的今天,文化遗产的保护与传播方式也发生了巨大变化。印度博物馆收藏着丰富多样的历史艺术品,涵盖绘画、雕塑、工艺品等多种形式。然而,这些艺术品的查询和探索一直面临着信息碎片化和检索不便的问题。传统的博物馆数据库多依赖于文本标签和人工整理,难以满足现代用户多样化、精准化的搜索需求。Depict项目正是在这样的背景下应运而生,借助开创性的CLIP技术,赋能印度博物馆艺术品的智能视觉搜索,推动文化数字化迈上新台阶。 Depict是一款基于人工智能的视觉搜索引擎,专注于印度博物馆艺术品数据的智能索引与检索。

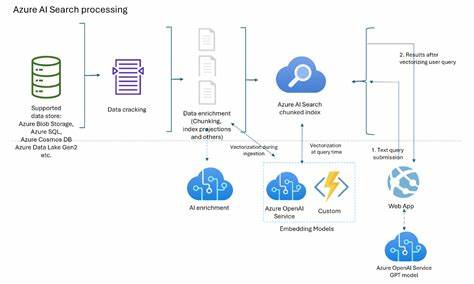

其核心技术依托于OpenAI提出的CLIP(Contrastive Language-Image Pre-training),这是一种预训练模态对齐模型,能够同时理解文本信息和图像内容,从而实现跨模态的相似性匹配。用户无需输入精确的关键词,只需使用日常自然语言描述,如“蓝色雕塑”或“传统绘画”等,系统即可理解语义含义并在图像数据库中找到与描述高度相关的艺术品。 该项目的数据集包括来自印度国家现代美术馆(National Gallery of Modern Art, Bangalore)、国家博物馆(National Museum, Delhi)、印度博物馆(Indian Museum, Kolkata)以及阿拉哈巴德博物馆(Allahabad Museum)等多家知名博物馆的图像与信息。这些数据均由项目团队通过网页爬虫技术从印度博物馆官方网站抓取,涵盖数千幅艺术品。面对结构多样、格式不一的网页数据,团队克服了重重困难,整理出统一格式的图像和其基本元数据,为后续的模型训练和应用奠定基础。 CLIP模型的引入为传统博物馆数据的检索提供了革命性的解决方案。

它通过分析文本描述与图像特征,将两者映射到同一个512维向量空间中,让文本和图像在高维空间计算中实现有效匹配。相比传统关键词匹配,CLIP能够理解抽象语义,识别视觉模式,极大地摆脱了对标签准确度的依赖。Depict项目团队利用Python语言结合h5py库,预先计算并存储所有艺术品图像的CLIP嵌入向量,在用户输入查询时即时计算文本的嵌入,快速通过向量相似度检索获得最相关结果,实现了高效、准确的云端搜索体验。 为了提升访问体验,Depict前端采用React.js开发,结合简洁的纯CSS设计,打造了响应迅速、界面友好的搜索平台。用户通过搜索框输入自然语言,后端API基于Modal AI平台无服务器架构部署,确保了模型的稳定运行和高效响应。整个系统架构兼顾性能与可扩展性,方便未来集成更多博物馆数据及功能拓展。

尽管功能亮点突出,但Depict仍有局限性。在计算资源受限的情况下,目前搜索仅覆盖部分博物馆数据集,且暂不支持基于图像的查询与更复杂的筛选条件。项目也缺乏对艺术品丰富元数据的深入挖掘,如艺术家背景、时代属性等。未来,团队计划通过筹集资金提升计算能力,扩大数据覆盖范围,并加入上传图片的视觉搜索功能。同时,集成时间、材质等多维度筛选,有望满足更专业的研究和欣赏需求。 Depict项目不仅是技术创新的范例,更体现了人工智能在文化保护与传播领域的巨大潜力。

通过智能化方法连接普通用户与博物馆珍贵藏品,降低了文化获取的门槛,激发公众对印度丰富艺术遗产的兴趣与认知。此类AI驱动的数字博物馆应用,为传统文化机构的现代化转型提供了实用路径,也为全球多元文化的交流和融合贡献了力量。 此外,Depict的开发历程同样透露出生态开放与社区协作的重要性。项目由一群热爱技术与文化的年轻开发者发起,开放源代码,积极寻求来自开发者和文化爱好者的反馈与贡献。这种共享精神鼓励更多人参与到文化遗产数字化的事业中,不断完善和创新,使得人工智能的价值被更广泛地发挥。 总结来看,Depict项目通过引入CLIP技术,为印度博物馆艺术品搜索提供了一种便捷智能的新方式。

它突破了传统文本检索的局限,实现了基于视觉语义的跨模态搜索,极大地提升了用户体验。随着技术进步及数据资源的丰富,类似的智能搜索工具将在全球范围内得到广泛应用,推动文化遗产数字化保护和公众普及再上台阶。未来,人工智能与文化的结合必将开辟更宽广的空间,助力人类更好地认识和传承多样的文明瑰宝。