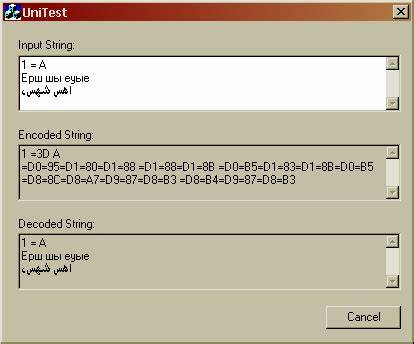

UTF-8作为现代计算机系统中最广泛应用的字符编码方式,兼具向后兼容ASCII的优势和对Unicode字符的高效支持,使其成为互联网和多语言处理的主流选择。理解UTF-8编码的内部机制对于软件开发者、编译器设计师以及从事字符处理相关工作的程序员而言至关重要。尤其是在解码环节,准确、高效地确定UTF-8序列的长度不仅是正确还原文本的前提,也直接关系到程序性能优化和安全防护。本文将深入探讨通过查找表(lookup table)来无分支地确定UTF-8字符序列长度的方法,详述其原理、实现与优势,帮助读者全面掌握这一技术细节。 UTF-8编码设计巧妙,采用变长字节序列编码Unicode字符。单字符可能占用1到4个字节的长度,首字节(lead byte)信息明确告诉我们该字符的总字节数。

解码时,如何快速判断序列长度成为关键。传统方法中借助条件分支判断首字节的高位比特位模式,由此直接决定解析时该读取多少字节。然而此种实现有时会带来较多的分支跳转,对于现代CPU流水线来说可能造成性能损失和分支预测失败等问题,影响整体执行效率。为避免这些缺点,查找表应运而生。根据UTF-8的编码规则,首字节的256个可能取值被划分为不同区间,每个区间对应一个确定的序列长度或者非法状态。比如,以二进制形式考察首字节的高位,0开头的字符显然是单字节ASCII编码,长度为1;110开头的字节标明该序列有2个字节;1110则是3个字节,11110表示4个字节。

除此之外,UTF-8中还有专门的续字节,其高位二进制是10,这类字节不能作为首字节出现,因此在查找表中赋予长度0以标识非法。 使用查找表的核心思想是:预先生成一个拥有256个元素的数组,每个索引对应一个字节值,数组元素代表该字节作为首字节时的有效序列长度。这样,只要拿到待解码字符的首字节,即可用其数值作为数组下标,直接取出长度结果,无需条件判断和分支跳转。以此方法实现的代码非常简洁且效率极高,例如如下C语言函数示例: int utf8_sequence_length(unsigned char lead_byte) { static const unsigned char lookup[256] = { [0 ... 0x7F] = 1, [0x80 ... 0xBF] = 0, [0xC0 ... 0xC1] = 0, [0xC2 ... 0xDF] = 2, [0xE0 ... 0xEF] = 3, [0xF0 ... 0xF4] = 4, [0xF5 ... 0xFF] = 0, }; return lookup[lead_byte]; } 上述查找表涵盖了所有UTF-8首字节可能的长度情况,并针对非法首字节,例如过长的起始字节和续字节区间均赋值为0,代表无效序列。特别强调处理0xC0和0xC1范围字节是因为它们标记为"过长编码",攻击者可能利用此类字节进行编码规避攻击,因此一律算作非法。查找表的初始化采用GNU扩展的范围设计器实现,简单高效。

采用查找表实现首字节长度判定,有多方面的优势。首先,从性能角度看,无条件访问数组元素避免了分支指令,减少CPU流水线等待和缓存抖动,CPU执行路径更加直接顺畅。其次,代码简洁易懂,逻辑清晰,维护成本低。第三,可扩展性强,一旦UTF-8编码规范调整或者有新的限制加码,只需调整查找表内容即可,无需改写复杂条件分支。 然而,查找表方案并非无懈可击。查找表占用固定的256字节只读数据区,较大的表数据在嵌入式、小内存环境中可能带来空间压力和缓存资源竞争问题,导致整体性能不升反降。

另外,查找表方法本身没有进行代码点范围及合规性验证,如对非法码点、超出Unicode上限的情况仍需后续处理,必不可少以保证安全健壮。 现代编译器可以帮助改善查找表的生成,并利用CPU高速缓存更优地布局数据,进一步缩减访问延迟。同时,通过软硬件结合的技术,例如SIMD指令扩展也能利用查找表实现向量化处理,批量判断多个字符序列长度,发挥更大性能提升潜力。 除此之外,查找表思路还能应用在广泛的字符编码处理中,尤其在UTF-8的编码验证、错误检测和自动修正上,为编解码器开发提供简洁直观的基础技术。理解并掌握这类查找表设计思想,对于底层字符处理、编码转换和国际化软件架构设计者来说意义重大。 总结来看,在UTF-8解码领域,利用查找表将首字节映射至序列长度是一种巧妙且高效避免分支的方案,兼具性能和实现简便性,是许多高性能文本处理库和编解码器采用的标准技术。

未来随着处理器架构演进以及编码需求更高,进一步的优化和验证方法仍将出现,但查找表依旧是关键基石。希望本文对于技术爱好者和专业工程师理解UTF-8变长编码的内部运作机理,及其性能优化提供了有价值的视角,从而提升文本处理系统的稳健性和效率水平。 。