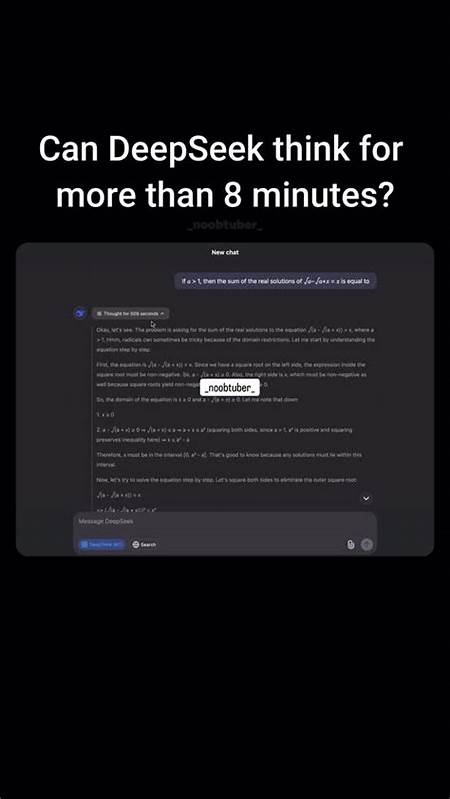

随着人工智能技术的不断发展,大型语言模型(LLMs)在自然语言处理领域的应用日益广泛。在众多创新工具和功能中,DeepSeek因其独特的“思考”展示功能而备受关注,这种功能让用户能够观察模型内部推理的过程,理解它是如何一步步给出答案的。本文将深入探讨DeepSeek“思考”机制背后的技术细节,解析其与传统大型语言模型的区别,并剖析多专家系统在其中的应用与价值。 首先,需要明确的是,DeepSeek并非通过多个独立的大型语言模型相互通信来完成推理。关于用户疑问中提到的“多个模型协作”过程,技术社区的讨论表明,在DeepSeek的架构设计中,所有推理过程都是由单一模型完成的,而非多模型间的互相对话。用户“123yawaworht456”曾明确指出,DeepSeek并不采用多个语言模型互相通信来生成最终答案。

相反,DeepSeek通过训练数据中特殊设计的示例,赋予模型在生成答案之前展现“思考”过程的能力。 这种“思考”过程的体现,主要源自于其训练数据中包含大量示范推理步骤的文本,并用特定的标签(如<think></think>)将思考过程显式标记出来。在训练阶段,模型提前见过大量这样的例子,从而在实际推理时能够模拟这种步骤化思考,将内部推理步骤转化为易于追踪和理解的文本输出。这种方法本质上是一种监督学习的策略,使得模型不仅输出结果,还能输出生成该结果的推理轨迹,增强了模型输出的可解释性和透明度。 另一方面,DeepSeek在模型架构上也采用了先进的“专家混合”(Mixture of Experts, MoE)技术。这种架构是现代大型语言模型为了增加参数数量,同时避免计算资源线性增加而引入的新机制。

在MoE结构中,每一个Transformer模块内部都包含大量的“专家”网络,模型会根据输入的不同部分智能选择有限数量的“专家”进行专门处理。这样的设计让模型可以发挥每个专家模块的特长,实现更高效的计算资源利用和更强的表达能力。 DeepSeek的MoE设计并不仅限于单设备运算,而是利用了高级的分布式技术,比如GShard。该技术允许将模型中不同专家分布在不同的计算节点上,通过高级路由算法准确选择参与推理的专家,避免了资源浪费。这种分布式的专家机制使得模型在处理复杂问题时能够灵活调用多种专长,从而更好地模拟多角度思考的过程。 尽管MoE技术让模型内部能够灵活调度不同“专家”子模型,但这仍然发生在同一模型内部的不同模块间,跟多个独立模型之间的通信有所区别。

当前的DeepSeek设计尚未表现出多模型协作的模式,而是更注重通过内部专家模块的协同来完成推理任务。 DeepSeek所展示的“内部思考过程”不仅为用户提供了答案,还提供了答案产生的思考路径。这种可视化或文本化的思考过程极大地提升了模型输出的可解释性,是AI透明化的重要一步。对于用户而言,可以清晰地看到模型是如何一步步分析问题、考虑不同因素,最后得出结论的,这对于增强信任感和理解模型局限性具备重要意义。 此外,DeepSeek的“思考”流程还可以帮助开发者和研究者更好地调试模型,提高模型的表现和准确度。通过观察模型的思考轨迹,开发者能够发现模型在哪些步骤上存在偏差或错误,从而针对性地优化训练数据和模型参数,提升整体性能。

综上所述,DeepSeek的“思考”功能背后是两大技术支柱。其一是基于含有“内部思考”标记标签的优质训练数据,使模型学会在生成答案前模拟具体的思路解析;其二是采用Mixture of Experts架构,通过内部多个专家模块的智能协作,增强模型处理复杂任务的能力与效率。两者结合不仅提升了DeepSeek的性能,也赋予其独特的可视化推理能力,向用户真实展示了AI语言模型的“思维轨迹”。 未来,随着AI技术不断进步,或许会出现更多支持多模型协作、不同角色分工的智能系统。当前DeepSeek的设计更多聚焦于单模型内部专家的分布式策略,而不是多模型的相互通信。但无论如何,DeepSeek所创造的“展现思考过程”的应用体验标志着自然语言处理领域向更透明、智慧和可信赖方向的重要迈进。

用户在使用DeepSeek的过程中不仅能获得准确智能的答案,还能深入了解答案的形成脉络,这为教育、科研、商业决策等多个领域带来了巨大潜力。作为不断演进的语言模型,DeepSeek的探索和创新为未来AI的智能化、人性化发展树立了标杆,值得业界和用户持续关注与研究。