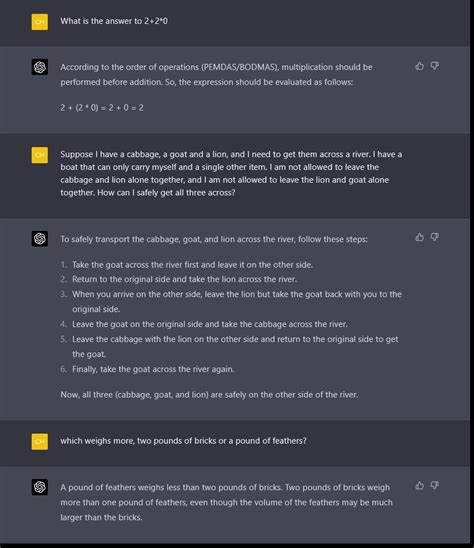

近年来,人工智能技术特别是大型语言模型在各领域的应用呈现爆发式增长,从智能客服、内容生成到辅助决策,AI正逐渐融入人们的工作与生活。然而,语言模型固有的"幻觉"问题,即模型生成与事实不符、虚假的内容,严重制约了AI进一步的普及和信赖。面对这一技术难题,创新平台CompareGPT应运而生,利用多模型对比与用户激励机制,为AI幻觉的识别和减少提供了新的思路。CompareGPT由Tina团队开发,旨在通过汇集来自不同AI模型的对比数据,降低单一模型产生幻觉的风险。不同于传统面对单一模型的信任挑战,CompareGPT整合了包括ChatGPT、Gemini、Claude、Grok等多款主流语言模型,通过跨模型输出的对比分析,帮助用户识别和甄别信息的准确度。多模型输出对比让用户能在实际应用中更有效地发现潜在错误,从而避免盲目信赖某一模型导致的风险。

在此基础上,CompareGPT引入了创新性的用户参与机制,鼓励广大AI使用者积极提交自身遇到的模型幻觉案例。作为奖励,平台会给予积分形式的回馈,用户可以利用这些积分解锁API使用权限,甚至将积分兑换为现金收益。这种基于信用和回报的激励体系不仅提升了用户的参与度,也激活了社区力量,促进了AI模型幻觉的快速收集与标注。通过不断汇聚和分析大量真实用户反馈的幻觉案例,CompareGPT为模型优化提供了宝贵的数据支持。开发者和研究人员能够利用这些数据对模型进行有针对性的改进,降低未来幻觉率,提高AI系统的整体可靠性和安全性。此外,CompareGPT平台的存在也有助于建立更为规范和透明的AI使用环境。

利用多模型对比的方式,用户在面对复杂或敏感问题时,能够更加明晰不同AI服务的回答差异,合理权衡信息源,从而做出更明智的决策。这种机制有望在金融、法律、医疗等高度依赖准确性的行业发挥重要作用,防止误导与错误信息带来的严重后果。从长远来看,将AI幻觉转化为具体的积分与现金奖励,既是对用户贡献的肯定,也是以经济激励驱动社区参与的示范。CompareGPT探索了一条通过多方力量合作共建可信AI的途径,彰显出开放协作与用户赋权的新趋势。实际体验中,参与者反馈显示平台不仅提供了趣味挑战,还切实提升了AI对话的准确率和透明度。值得注意的是,当前AI幻觉现象依旧普遍且复杂,CompareGPT并非万能钥匙,但其坚持数据驱动和社区共治的理念,为推动行业标准和用户教育提供了积极的示范效应。

AI发展日新月异,幻觉问题不可避免,但借助多模型对比、用户激励、持续反馈等多重手段,像CompareGPT这样的创新方案有望不断完善语言模型的准确性,促进AI的安全落地。未来,伴随更多模型接入和更广泛社区参与,CompareGPT或能构建起一个动态的AI质量保障生态,助力人人享用更靠谱、更智慧的人工智能服务。总体而言,CompareGPT为解决大型语言模型幻觉难题带来了全新视角和路径,通过技术和机制创新实现了技术风险的有效治理,为AI赋能赋信开辟了广阔空间。随着用户积极参与和数据积累,行业或将迎来更加稳健和可信的智能时代。 。