量子计算以其超越经典计算机的强大潜力,引发了全球科技界的广泛关注。量子比特作为量子计算的基本单元,其操作的保真度直接影响量子计算机的性能与稳定性。然而,由于量子态极其脆弱,量子比特在操作过程中容易受到各种噪声与误差的干扰,导致保真度下降。提升量子比特操作的保真度成为量子计算领域的核心技术难题之一。 量子比特操作保真度简言之即量子门执行准确性的度量。它反映了实际操作与理想量子门之间的接近程度。

高保真度意味着执行的量子门与理想门极为接近,量子计算过程中的误差极小,有利于降低量子误差纠正的复杂度。当前,提升量子比特操作保真度的研究聚焦于多方面:优化量子比特的设计与制造工艺、改善量子比特的环境隔离、提升控制与测量技术,以及发展新型的量子错纠技术。 首先,从物理实现层面来看,超导量子比特是目前最具实用潜力的方案之一。超导Transmon量子比特通过简化的电路设计与较强的抗噪声能力,成为量子计算领域的主流选择。近年来,多项研究致力于优化Transmon量子比特的材料与制备工艺,如采用高纯度的金属薄膜、精细控制结点的结构,以及利用纳米光刻技术提升电路的一致性。这些改进显著提高了量子比特的能量弛豫时间(T1)和相干时间(T2),是提升操作保真度的重要基础。

环境噪声的抑制同样至关重要。量子比特所在的量子芯片必须被严密屏蔽,防止电磁辐射、热噪声以及振动噪声等的侵扰。采用磁性屏蔽材料、多层超导屏蔽排布及低温冷却技术,是目前主流的隔离方案。此外,环境中的杂质和缺陷对量子比特的退相干具有显著影响,改进材料制备过程、采用真空环境生长薄膜和表面钝化处理,可以有效减少量子比特周围的杂质和缺陷密度,从而延长相干时间,提升保真度。 控制与测量系统的精确性同样是提升量子比特操作保真度的关键。量子门操作依赖于极其精细的微波脉冲控制,要求脉冲频率、幅度与相位等参数高度精准。

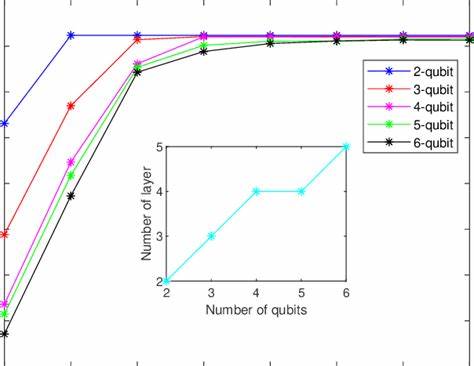

现代数字信号处理平台,如基于FPGA或专用ASIC的量子控制器,实现了高速、低延迟的信号生成与反馈,显著提升了操作精度。此外,改进的量子非破坏测量技术,有助于准确获取量子态信息,避免测量引发的附加误差。 另一个重要技术是量子纠错代码与容错量子计算的发展。真实量子处理器不可避免存在误差,通过设计合理的纠错码可以识别并纠正操作过程中的错误。成功实施纠错技术能够大幅提高量子计算的整体保真度,使得长时间和复杂的量子算法得以可靠执行。与此同时,容错门设计,包括复合脉冲序列和噪声自适应控制,能够利用物理误差渠道减少整体误差积累。

具体而言,近年来学术界报道了多个突破性的成果。例如某团队开发出的新型Transmon量子比特,其能量弛豫时间和echo退相干时间均达到了近毫秒级别,远超传统量子比特。这得益于其独特的设计优化,精细的材料选择以及先进的制造工艺。此类高相干量子比特为提升量子门保真度提供了坚实保障,也推动了量子计算迈向实用的大规模阶段。 此外,量子比特与外围电路耦合技术的改进,如引入Purcell滤波器,有效抑制了量子比特能量向读取通道的泄漏,降低致失效率。分布式泵浦和参数放大器技术则提升了读取信号的信噪比,降低测量误差。

通过这些技术,整体量子操作的信号完整性得以保证,同时控制误差显著降低。 未来,提升量子比特操作保真度还需结合更多交叉学科的力量。材料科学、纳米制造技术、量子控制理论、以及人工智能辅助设计均将成为推动技术发展的关键。例如利用机器学习算法分析和预测量子退相干机制,为制备最优器件材料和操作策略提供指导。并且,随着量子硬件规模的扩大,对多量子比特系统的误差识别与纠正需求激增,进一步推动保真度提升的研究迫在眉睫。 总之,提升量子比特操作的保真度是实现高效、稳定量子计算机的基础和前提。

通过物理器件的优化、环境噪声的抑制、精密控制与测量技术的创新,以及量子误差纠正方案的改进,量子计算正逐步克服保真度瓶颈。随着研究的不断深入和技术的日益成熟,未来或将迎来量子计算应用的全面爆发,推动科学计算、优化算法乃至材料设计等领域实现质的飞跃。科学共同体与产业界需携手协作,加速量子比特操作保真度的突破,为量子时代奠定坚实基础。