随着人工智能技术的不断进步,基于大型语言模型(LLM)的应用场景越来越广泛,尤其是OpenAI的GPT系列模型,为开发者打开了无限的可能性。然而,在实际开发过程中,如何有效调试和监控与这些语言模型的交互,成为提升产品质量和用户体验的重要环节。LLM Debugger作为一款轻量级、开源且本地优先的调试工具,专为Python开发者设计,助力他们全面洞察和管理与OpenAI API的对话流程。LLM Debugger能够详细记录每次模型调用的请求与响应元数据,不仅支持对话中各回合差异的直观展示,还能清晰可见工具调用、工具响应及系统提示,从而帮助开发者精准地比较提示策略并调试会话行为。尤其对于构建智能代理工作流、聊天界面或基于提示的系统而言,LLM Debugger提供了简洁高效的解决方案。从安装角度来看,LLM Debugger支持两种主要方案。

推荐方式是通过PyPI直接安装预编译包,快速实现环境搭建和日志记录功能。也可以选择克隆官方仓库进行本地集成或定制开发。无论哪种方案,工具都内嵌了静态前端文件,无需额外的Node.js环境或复杂构建步骤,确保用户使用的便捷性和稳定性。LLM Debugger的安装与开发门槛相对较低,仅需Python3.8及以上版本,对于需要修改界面代码的开发者,只需配置Node.js与npm即可。功能体验方面,LLM Debugger通过一行代码即可包装OpenAI客户端,实现自动会话跟踪,无需手动管理会话ID或状态。它将所有交互日志以结构化JSON格式保存在本地目录中,践行隐私保护和数据自主的理念。

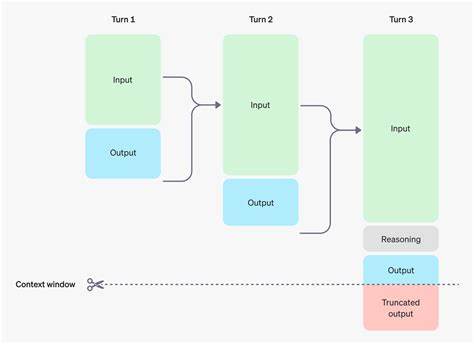

工具不仅捕捉调用延迟、模型版本和丰富的元数据,而且通过差异化分析,辅助开发者快速识别输入输出间的关键变化,极大提升了调试效率。从技术实现上,LLM Debugger通过消息指纹技术为每个对话创建唯一标识,它采用SHA-256算法对规范化的消息内容进行哈希生成,截取前12位简短标示,方便开发者识别对话会话。此外,工具支撑对话连续性的自动检测,通过前缀匹配算法查找已存在的部分内容,实现会话的无缝衔接和状态延续。会话ID基于UUID生成,同一对话的后续调用会继承相应ID,日志文件按日期和会话ID分类存储,方便开发者在海量数据中迅速定位相关记录。LLM Debugger还设计了持久化注册表用于跨进程和重启保持会话连续性,确保应用在任意阶段都能准确识别和归档每次模型交互。展示接口方面,LLM Debugger附带一个静态网页前端,通过本地服务展示丰富的日志视图及分析功能。

用户既可以通过命令行启动独立的调试服务,也能将其嵌入到主应用中(例如FastAPI框架的子路由),实现统一管理。其UI设计直观,支持对模型请求和响应细节的实时浏览及高亮差异,便于理解会话流转和模型行为。除此之外,LLM Debugger支持Docker部署方案,允许开发者在容器中同时运行应用与日志查看服务,极大提升部署的灵活度和可移植性。考虑到多样化需求,工具还在积极规划未来功能,如会话回放、更多模型的支持(包括Anthropic Claude)、交互分析过滤以及导出报告等,以满足更丰富的调试场景和团队协作需求。隐私保护方面,LLM Debugger采取本地存储和离线运行设计,所有日志均保存在用户设备,无需上传至第三方服务器或云端,保障数据安全和用户隐私。这样的设计理念十分适合注重合规性和信息安全的专业环境。

总的来说,LLM Debugger凭借其简单易用、功能全面及隐私优先的优势,正逐渐成为Python开发者调试OpenAI API对话的利器。它不仅提升了调试效率,更为理解和优化大型语言模型的交互方式提供了强有力的支持。随着AI应用的增长和复杂度提升,掌握并充分利用LLM Debugger,将成为开发者构建高质量智能系统的关键一步。未来,随着更多功能的加入和更多模型的集成,LLM Debugger势必在AI开发生态中占据更加重要的地位。对于希望深入掌握多轮对话、提示工程和智能代理调试技术的专业人士来说,LLM Debugger的出现无疑开辟了一条全新的研发现实路径。