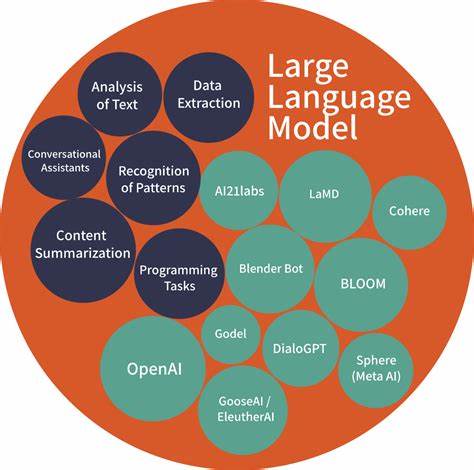

Adaline,全称Adaptive Linear Neuron,自适应线性神经元,是机器学习和神经网络领域的经典算法之一。它由心理学家伯纳德·韦德罗(Bernard Widrow)和泰德·霍夫(Ted Hoff)于20世纪60年代提出,成为早期神经网络研究和实际应用的基石。时至今日,虽然深度学习技术飞速发展,Adaline依然凭借其简单高效的特点,在某些特定场景和教学研究中占据着不可替代的位置。 Adaline本质上是一个基于线性模型的单层神经元,它与单层感知器类似,但在训练和更新权重的过程存在关键差异。单层感知器使用阶跃函数作为激活函数,输出离散值,通过感知器学习规则调整权重。而Adaline则采用连续的线性激活输出,然后利用均方误差(Mean Squared Error, MSE)作为损失函数,通过梯度下降法优化权重。

正是这种基于误差的最小化思想,使Adaline在处理连续信号及噪声数据时表现出较好的鲁棒性。 从结构角度来看,Adaline模型由输入层和输出层组成。输入层接收来自环境的数据特征,输出层产生线性组合信号,权重和偏置控制着这个线性组合的权重分配。通过比较模型输出与目标期望值之间的差异,计算误差后,利用梯度下降更新权重参数,逐步逼近最优解。由于其简单的线性架构,Adaline训练过程计算量较低,适合于基础的分类和回归任务。 Adaline的最大优势之一是其学习算法的稳定性。

因为它基于均方误差准则,使得训练过程更加平滑,避免了传统感知器中随机更新带来的震荡问题。此外,在面对线性可分问题时,Adaline能够通过不断调整权重实现准确的模式分类。然而,正因为其线性性质,Adaline不能解决非线性可分的复杂问题,这也促使后续研究者发展出了多层神经网络和非线性激活函数。 在实际应用领域,Adaline曾广泛用于语音信号处理、模式识别及预测系统。例如,在早期的通信系统中,Adaline被用于信号滤波和噪声抑制,提高信号传输质量。此外,它也被用作基础的分类器,辅助电子邮件垃圾分类、简单图像识别等任务。

虽然现代应用更倾向于深度神经网络和支持向量机等更强大的模型,但Adaline依旧是理解复杂机器学习模型的第一步。 Adaline的发展不仅促进了算法优化,也推动了心理学和神经科学的跨学科融合。其基于神经元激励机制的设计灵感源于对生物神经系统的理解,促进了人工智能的神经科学理论基础建设。在计算机科学教育中,Adaline常被用作教学模型,帮助学生理解神经网络的基本原理和训练方法,是入门级神经网络课程的经典范例。 随着深度学习的崛起,Adaline的应用范围虽然有所缩小,但其核心理念仍在多个现代算法中体现。梯度下降和误差最小化作为优化原则广泛应用于各种复杂网络结构,包括卷积神经网络和循环神经网络。

因而,掌握Adaline的工作机制,有助于更好地理解深度学习的本质和算法设计。 未来,随着人工智能技术的发展,Adaline可能会在轻量级机器学习模型和边缘计算设备中重新焕发活力。其简单高效的线性模型架构使它适合资源受限的环境,帮助实现低功耗、高效的数据处理需求。同时,结合现代技术手段,例如混合模型和增强学习,Adaline有潜力成为更广泛智能系统的一部分。 总结来说,Adaline作为人工智能领域的经典算法,不仅在历史上奠定了神经网络和机器学习的重要基础,也为今天的先进技术提供了理论支持和启示。了解和掌握Adaline的原理与应用,有助于科学家和工程师深入认识机器学习模型的本质,推动智能技术的创新和发展。

随着时代的演变,Adaline依然是一颗闪耀的学术明星,照亮着人工智能探索的前路。