在软件开发领域,数据库作为核心存储和数据管理工具,其设计与使用的合理性直接影响系统的性能和稳定性。一个成熟的系统往往需要根据业务复杂度和规模选择合适的数据架构,而错误的数据库使用方式则可能导致整个系统陷入崩溃的边缘,带来严重的业务中断和成本浪费。本文结合一个真实案例,深入剖析数据库利用的典型误区,特别是当团队为了修复旧系统的问题而走向极端、使数据库设计的钟摆摆动过头时所带来的挑战与教训。 故事起始于一家企业核心业务数据管道的接手。当时,该数据管道是公司底线和财务结果的关键,承担着不可替代的角色。然而,该系统继承自海外团队,技术架构和开发流程复杂且古老。

多个庞大的代码库相互依赖,修改小小一处代码需要耗费近半小时进行整体编译,且整个构建过程高度依赖特定的操作系统组件,开发者必须在虚拟机中完成开发和测试。此外,测试过程不稳定,系统经常出现意外故障,隐藏的功能和特性缺乏文档说明,增加了团队的维护难度。 其中数据库系统是问题的主要诱因。数据分布于多个SQL Server数据库和不同服务器中,这本身并非不可行的问题。真正的问题是,大量复杂的业务逻辑被密集地嵌入存储过程里,组成层层嵌套的查询链接。这种设计虽然让数据库承担了更多“计算”的角色,但也极大消耗服务器CPU资源,导致核心API调用几乎全部依赖数据库的性能表现。

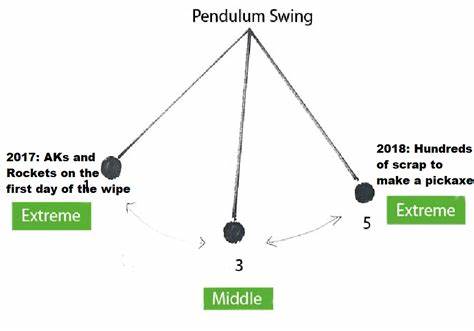

业务流程中一旦查询计划稍有变动,就可能出现哈希连接变成全表扫描,造成严重延迟和超时,系统频繁出现死锁,严重影响系统可用性和用户体验。 开发团队虽努力改进和优化,但结构性的缺陷决定了彻底重写代码不可避免。这种现象反映了一个经典的技术摆动问题,即初始阶段对数据库复杂逻辑的依赖过重,造成系统僵化和性能瓶颈。 重写过程中的另一个极端则是技术架构师试图完全回避关系数据库,拒绝使用存储过程和查询规划的复杂性,转向简单的键值存储(Key-Value Store)。这种设计下,数据库只允许基于单一键的读取、插入、更新和删除操作,没有事务或批量处理机制。 然而对于高度关联且复杂的数据模型而言,简化操作权限的KV存储并非完美解决方案。

团队尝试将复杂的关系数据通过嵌套文档形式序列化为JSON,存入键值数据库中,意图通过一次性加载整个文档避免复杂联表操作。 但缺乏专门的文档数据库支持,无法实现针对子字段的局部更新,每一次对数据的小改动都需完整读取、反序列化、修改后再重新写回,导致大量的重复IO开销,系统延迟大幅增加。为降低IO代价,团队尝试使用压缩技术(如Gzip)保存JSON数据,虽然减少了传输数据量,但也引入了额外的CPU消耗和调试复杂度,甚至影响到现有的数据库维护工具,迫使团队自制解压和数据查看工具。 此外,缺乏事务支持意味着无法保证多文档写入的原子性,中间失败和重试机制的设计变得尤为重要。团队引入checkpoint机制,通过记录写操作的唯一标识和状态来实现幂等性和恢复点。然而,这一设计进一步加剧了数据库写操作的复杂度和IO次数,延长了处理时间,反而重蹈旧系统效率低下的覆辙。

整体来看,这一系列设计选择体现了从数据库过度复杂化到过度简化之间的摇摆。任何技术决策的极端化都会产生负面后果。复杂的存储过程虽然提升了单次查询的聚合和效率,但牺牲了灵活性和可维护性;反之,过度简化的键值设计则导致重复的数据读取、写入增加了系统的延迟和资源消耗。 这些经历对于当下的软件工程和数据库设计仍有启发意义。首先,设计数据库架构时应充分理解业务复杂度和数据关系,以选择合适的模型和持久化策略。其次,团队需要权衡系统的性能、可维护性与扩展性,避免技术选择偏离业务实际需求。

最后,技术重构应注重渐进式改进,结合监控和回滚策略,减少因架构切换带来的风险和性能波动。 总结来看,数据库的合理使用不仅仅是技术问题,更是一门艺术,需要丰富的实践经验和对业务的深刻理解。避免在“数据库技术钟摆”上极端摇摆,学会中庸之道、扬长避短,才能真正构建高效、稳定且具有弹性的系统架构。那些看似简单的键值存储背后隐藏着同样复杂的设计考量,关系数据库虽然复杂但在很多复杂场景中依然不可替代。开发者应该借鉴历史经验,避免重蹈覆辙,不断追求技术与业务需求的平衡,推动系统持续健康发展。