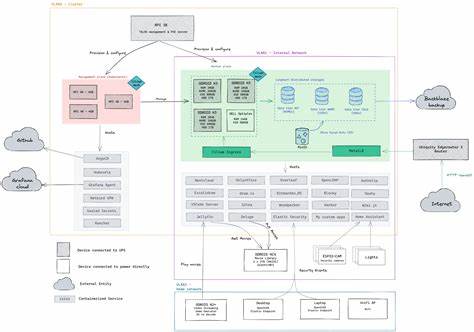

Kubernetes作为当今最为流行的容器编排平台,已经在全球范围内被广泛采用。然而,随着实际使用的深入,越来越多的运维人员和开发者意识到其复杂性和难以调试的问题。尽管功能强大,Kubernetes的设计却带来了高门槛和持久的管理难度。如何从零开始,重新思考和设计一个简洁、高效且更易上手的容器编排系统,成为了业界极具挑战性的话题。 在探索全新Kubernetes设计思路时,我们不再拘泥于与现有系统的兼容性,而是大胆地从根本理念出发,以极简主义和可操作性为核心准则构建未来的容器编排平台。这样的设计理念汲取了Go语言的哲学——简单、以意见驱动、逐步演进,让用户可以在短时间学习后专注于业务目标,而不是陷入系统的复杂性漩涡中。

首先,针对Kubernetes中最基础的调度单位——Pod,现有系统普遍采用了不可变模式。Pod一旦创建后,大部分字段便无法直接修改,要调整配置只能重新创建新Pod并删除旧Pod。这样的设计在一定程度上保证了状态的一致性,但也带来重新部署的不便和资源调度上的浪费。全新设计建议Pod应变为完全可读写对象,允许在原位重启和修改。这种改变不仅将Pod与系统服务管理如systemd相似化,也能够提升效率,减少因变更引起的调度压力和不必要的资源释放。 具有可变Pod的前提下,版本控制功能变得尤为重要。

通过将Pod定义及其更新版本进行持续记录和管理,运维人员可以实现方便的回滚操作、变更历史追溯以及集群状态的透明化。这种内置版本管理不仅避免依赖外部GitOps流程,也极大提升了调试效率和变更的可视化,帮助运维快速定位和解决问题。对集群持续变更的有效管理,是提升Kubernetes实用性的重要一环。 在部署管理层面,传统的Deployment机制虽然广泛使用,但常缺乏对状态版本的精准控制。创新推出的PinnedDeployment则是由一线SRE设计的强力工具,通过显式跟踪多个版本,实现对滚动升级的细粒度管控,显著提升了部署流程的透明度和可控性。这种基于版本管理的部署方式与可变Pod相结合,能有效避免传统多Pod调度中的不确定性,实现更灵活的多副本管理策略。

此外,现有Kubernetes调度机制依赖多个独立且相互竞合的控制循环,这种“松散编排”思想虽有其优势,但当系统出现故障时,诊断往往极为困难。面对复杂的控制循环相互作用及竞态条件,运维人员经常陷入日志海洋却难以定位根本原因。借鉴系统启动管理器systemd的经验,未来的容器编排系统应当采用显式的生命周期编排工作流,明确控制循环间的依赖和顺序关系,通过结构化日志和状态图形化展示,极大降低诊断难度。 这种面向工作流的控制循环约束,不仅改善了调试体验,同时促进了生命周期内操作的最大化并行执行。用户还可根据业务需求自定义控制循环插入点,轻松扩展生命周期事件处理,有效避免了诸如Istio等服务网格不得不通过复杂hook来插入流量管理的局面。整体来看,明确且可观察的控制循环工作流是提升集群稳定性和可维护性的关键升级。

针对控制循环的扩展性,进一步引入显式字段所有权管理也至关重要。在现有Kubernetes中,字段所有权较为隐晦,导致出现不同控制循环间争夺字段控制权的冲突,从而引发状态震荡和不可预测的行为。新设计建议每个对象的字段都由唯一的控制循环拥有并写入,除非明确授权允许共享。借助API级别的强制约束,可以避免双方对同一字段进行写入的“斗争”,提高整体系统的一致性和调试效率。 网络作为容器调度系统的核心部分之一,同样需要从根本重构。现有Kubernetes网络依赖覆盖网络、服务代理、CNI插件等多层复杂组件,维护难度高且配置复杂。

未来设计主张直接采用IPv6地址规划,每个Pod获得唯一的IPv6地址,利用局域网内的邻居发现和简单路由实现高效互联。如此大大简化了网络模型,实现零配置可通信的容器网络环境。对于IPv4访问,则采用节点端IPv4掩码转换或NAT64/CLAT方式实现双栈访问,保证了与外界的兼容性。 与此同时,入站流量的负载均衡应独立于核心调度系统,由专门的负载均衡组件或云厂商的LB服务完成,保持编排系统使命单一:尽最大努力将流量交付到正确的Pod。通过这种分层职责,避免了Kubernetes网络层因试图满足彩虹般功能而变得难以调试的困境,同时为裸金属和云环境提供了均衡的解决方案。 甚至可以考虑采用更为极简的网络策略,例如Borg风格的端口分配模型,所有容器运行在主机网络命名空间,通过分配唯一端口暴露服务,极大减小网络层复杂度。

虽然存在端口资源有限的风险,但其简洁直观帮助用户更快理解并控制流量路径,这对小规模集群或追求极简管理体验的应用场景尤为适合。 在安全方面,未来系统默认为最高级别的沙箱隔离。基于业界前沿的安全实践,默认开启AppArmor和Seccomp,禁止容器内以root身份运行,使用用户命名空间减少权限泄露风险,严格限制特权功能和主机资源挂载路径。通过“二次确认”机制强制用户显式开启不安全配置,扭转现有Kubernetes默认安全策略宽松的问题,打造更加安心的运行环境。 对于极致安全需求,可以预设开启轻量级虚拟机监控器如gVisor或Firecracker,实现更深层次的隔离策略,同时保持灵活性,让用户在性能与安全之间做出权衡。随着底层文件系统虚拟化技术(如virtio-fs)的逐步成熟,虚拟机沙箱与存储的整合也将更加高效和自然。

在集群边缘计算和极度分布式场景下,新设计强调节点高度独立性。节点应能离线运行数周,依赖本地存储的同步状态自动复原,无需持续依赖集中式控制平台。节点丢失事件的处理策略应支持多个运行模式——高度可用场景下自动重新调度,非关键应用则倾向最佳努力,体现更加灵活的资源管理理念。分布式集群和多地数据中心同时集成到统一调度框架内,推动混合云与边缘计算的无缝融合。 更进一步,原生集成虚拟机管理,统一容器与虚拟机混合调度的能力,是未来方向之一。整合类似kubevirt的功能,使虚拟机资源调度不再依赖独立系统,简化运维复杂度,为跨平台、多样化计算需求提供统一解决方案。

具体实现策略尚待打磨,但目标是实现无缝切换和统一监控管理,为用户提供一站式的资源编排体验。 存储依然是最具挑战的模块。新系统设计鼓励保持插件式架构,以便随着需求变化灵活替换底层存储方案。生命周期编排与存储深度结合,保证数据持久性与迁移的平滑,避免现有CSI接口过于繁复的问题。未来的存储设计还应兼顾分布式一致性、高可用及性能平衡,等待业界更成熟的解决方案涌现。 整体来看,从头设计的Kubernetes未来版,抛弃了兼容包袱和冗余复杂,拥抱简单、明确、可控和安全。

它将帮助开发者和运维人员减少陷入神秘难懂的系统细节,将更多时间和精力投入到业务创新中。面对云原生生态日益复杂的挑战,这种思路或许可以开辟一条全新路径,促进容器编排系统的跨越式发展。 虽然现阶段这些理念多为愿景与设计思考,需要大量工程实践打磨,但它们为下一代容器编排奠定了坚实的理论基础。无论是大型云厂商、开源社区还是企业用户,都可以从中汲取灵感,推动Kubernetes乃至整个云原生生态的健康进化,迈向更加智能、易用和安全的未来。