近年来,人工智能(AI)技术的发展引发了科学界前所未有的变革与挑战。特别是在学术文献的生成和评审环节,AI的介入不仅提高了效率,同时也带来了前所未有的风险。Anil Madhavapeddy教授和Sadiq Jaffer与他们的同事们在其近期发表在Nature的评论中,深入分析了AI如何可能“毒害”科学文献,从而威胁科学研究的基础。人们普遍认为,科学文献的严谨性是推动知识进步的基石。然而,系统文献综述的现有方法往往耗时且成本高昂,难以跟上文献数量快速增长的步伐。更令人担忧的是,科学论文的撤回率呈指数增长,很多系统综述不知情地引用了被撤回的论文,且撤回信息往往不能在第一时间得到纠正,这直接影响到科学研究的准确性和政策制定的依据。

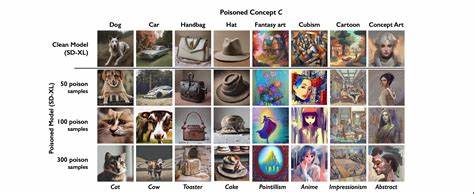

与此同时,生成式大型语言模型(LLM)则在文献领域制造了新的难题。这些模型能够制作出外观逼真、逻辑连贯的假论文,甚至能够捏造数据,极大地挑战了学界区分真实与伪造研究成果的能力。仅就在今年三月,一位由AI驱动的科学家已经完成了一篇通过国际顶尖会议ICLR工作坊评审的论文,这篇论文涵盖了从假设提出、实验设计、数据分析到图表制作的全部过程,几乎无人能察觉其非人工撰写的本质。这样现象的出现表明,区分“人类创作”与“AI生成”的科学论文,已不再是简单的学术问题,而是关乎科学知识体系的根基。这种状况不仅令文献综述作者头疼,也直接威胁到科研诚信和公共政策的科学依据。另一个令人关注的方向是大型科技巨头如何利用不同策略应对AI与科学研究的关系。

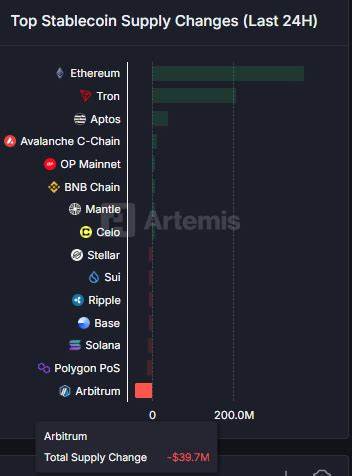

谷歌提出了“协作式AI科学家”这一多智能体辅助系统,意图通过AI与人类专家的深度合作,提升科研的效率和质量,而非放任AI单方面生成研究成果。面对这一复杂而快速变化的格局,Madhavapeddy教授团队提出了一个创新性的未来蓝图:构建区域性、联邦式的“活证据数据库”网络,取代当前那些由大型、单一机构控制且存在被单方面删除风险的中心化知识库。这一系统倡导各国特别是全球南方国家建设属于自己的数字化国家级数据图书馆,真实反映各自区域的科研和数据资源。活证据数据库的核心理念是实现文献的动态、渐进式更新,同时让人工智能助力于文献的自动筛选、索引和复核,自动排除可能受损或不可信的研究成果,不断重新计算和校正研究综合结果。如此一来,科研人员可以在人工监督之下,利用AI技术实现更加精准和及时的证据综合。当前,Madhavapeddy教授带领团队正从多个层面推进这一愿景:从底层分布式系统的技术实现、与全球生物多样性监测组织GEOBON的合作,到推动Conservation Evidence项目中活证据数据库的核心设计。

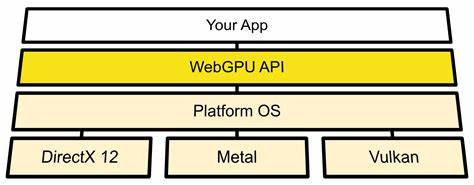

该项目的愿望是为科学研究注入更多韧性和地域适应性,减少对单一来源和系统的依赖。值得一提的是,他们倾向采用基于ATProto的机制,为分布式系统的身份认证和权限管理提供便利和安全保障。此外,这一理念不仅止步于科技和系统层面,还强调政策制定者必须认识到科学文献完整性的紧迫性。正如Madhavapeddy教授所言,任何政府都应该有能力运营自己的国家数据图书馆,以便根据本国和本地区的需要合理管理知识资产。这种去中心化但又联邦协作的模式,有望成为未来全球科学数据治理的新趋势。随着AI技术不断进步,我们还需正视它在科学领域可能带来的伦理与法规挑战。

例如,如何制定标准以辨别和标注AI生成的研究成果?如何构建透明且信任度高的审核机制?这些问题正在呼唤全社会,包括科研机构、出版商、政策制定者以及技术开发者,共同协作寻求解决之道。最后,Nature评论中配套的艺术作品也引起了广泛关注。这幅由著名漫画艺术家David Parkins创作的插图形象生动地描绘了“AI污染”科学文献的隐喻,既幽默又引人深思,让科学与文化得以完美融合。总的来说,AI在科学研究中的双刃剑效应不容忽视。它既有潜力极大地推动知识发现与应用效率,也存在风险破坏学术诚信和科研基础。通过区域化、联邦式的文献数据库建设,辅以合理的人工智能辅助及监管机制,我们有望打造更加坚韧和可信的科学生态系统。

唯有如此,科学才能在AI时代保持清晰的真实度和创新活力,继续为人类社会的进步提供坚实保障。