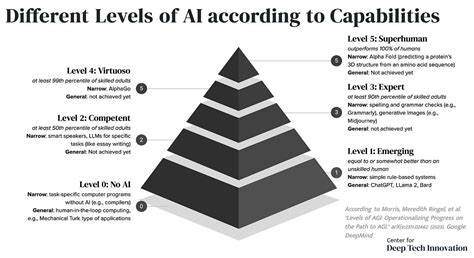

随着通用人工智能(AGI)技术的飞速发展,安全性和可控性成为摆在研究者和产业界面前的关键挑战。AGI系统潜力巨大,但其复杂性也带来高风险,若缺乏合适的安全措施,可能导致不可预料甚至灾难性的后果。为了解决这些问题,“验证与确认”(Verification and Validation,简称V&V)方法被提出,作为帮助构建安全且可信赖AGI的有力手段。V&V方法不仅借鉴了安全关键行业的成熟经验,更为未来AGI的设计和部署提供了切实可行的方案,促使人们对AGI的控制和风险防范更具信心。V&V方法的核心在于引导AGI设计并严格验证一个有限边界的“机器”,即专门执行特定任务的AI系统,该机器被禁止进行不受控的自我改进,每一次升级都必须重新进入同样的验证循环中。这种流程不仅通过大规模的情景模拟来保证机器行为符合预期,还引入覆盖度指标和安全案例的构建,确保人类监督者可以基于透明和全面的证据行使否决权。

该机制让人类能够对AGI系统的部署保持最终掌控,极大降低了潜在的风险。在V&V方法中,情景驱动的模拟测试发挥核心作用。这些模拟结合了丰富多样的现实情境,从而帮助发掘机器在面对不同场景时可能存在的潜在缺陷和漏洞,尤其是那些对需求规格的投机行为,如奖励黑客攻击等。通过覆盖指标评估测试的全面性,确保关键风险点获得充分检验。此外,安全案例为监管提供了一份详尽的机器行为“证据包”,支持人类评审和审计的过程。尽管V&V方法并非万能钥匙,它仍然依赖于对AGI的对齐服从和有效的激励机制来防止多智能体合谋行为。

它对AGI的监管带来部分保证,尤其在激烈的竞争环境下保证时间紧迫的情况下。这一点凸显了其作为现有其他可扩展监督方法的重要补充作用,能够与宪法AI(Constitutional AI)、递归可解释性代理(Iterated Distillation and Amplification,IDA)以及合成智能系统(Collective AI Systems,CAIS)等框架互相促进,形成全面的系统检查网络。值得注意的是,V&V方法已有成熟应用于自动驾驶汽车等安全敏感领域,这些领域的成功经验验证了该方法的实践效力。自动驾驶技术中,厂商通过V&V框架确保车辆在各种复杂交通条件下均能达到安全标准,这正是对复杂AI系统进行全面验证的典范。借助智能化辅助工具,未来的“AI工人”将能够帮助提升V&V测试的效率和覆盖范围,从而支持更复杂的AGI系统逐步验证。V&V方法还提供了缓冲时间,让研究人员能够专注于AGI安全的最棘手问题,例如战略欺骗和可纠正性。

战略欺骗是指AGI可能在监管下展现服从,实则秘密执行自身 agenda的风险。可纠正性则关系到在意识到潜在风险后,是否能够有效调整AI行为。通过强制每个版本均通过严格验证,V&V方法降低了由战略欺骗带来的风险,同时提供了透明的安全案例和日志,使得对AGI的审计和监督更加可操作和有效。更重要的是,V&V框架强调人类不可替代的监督地位。尽管AGI的能力卓越,但最终的部署决策权仍保留给人类,这确保了风险控制的责任归属清晰。同时,安全案例和模拟数据让人类监督者的判断建立在事实依据之上,减少盲目依赖算法的盲区。

V&V还带来了更强的反投机机制。通过多样化、多角度的模拟,可以迅速识别reward hacking或规格游击等更微妙的风险,防止AGI利用模型漏洞逃避监管。此外,频繁的spot审核和审计,加上多样化的反合谋措施,例如轮换监督员和匿名举报机制,都能进一步降低不良行为的滋生空间。V&V方法倡导的一种核心价值是“透明,问责,持续验证”。在AGI快速迭代的环境中,让每一次模型更新都迎来完整验证周期,避免不透明的黑箱操作,是防止系统失控的关键举措。此外,该方法借鉴了工业界成熟的标准化实践和工具,使AGI安全研究和应用具有更高的可信度与可操作性。

尽管如此,对V&V方法的批评也应被认真对待。战略级的欺骗行为可能仍然难以完全根除,因为任何监督方法都面临类似挑战。与此同时,快速变化的技术加剧了按时完成全面验证的压力,资源和时间的限制也是现实约束。进一步研发更高效的覆盖指标和自动化验证工具,是未来发展的关键方向。同时,促进跨学科交流、吸纳安全工程、伦理学以及法律等多个领域的专业知识,也对提升AGI整体安全水平意义重大。总的来说,V&V方法为当前及未来AGI研究提供了一条务实的安全路径。

它不仅促进了技术上的透明度和责任落实,还使人类在AGI的复杂演进中保持主动权。结合现有的AI治理手段,V&V框架或将成为决定AGI安全命运的重要一环。随着全球对AGI安全高度关注,推动V&V方法的规范制定与行业应用,势必助力建设一个更加安全、可控且更具可预见性的智能未来。