随着人工智能技术的不断进步,大型语言模型(LLM)在对话式智能体中的应用日益广泛。人们对智能助理的期待也在逐步提高,希望它们能够像《钢铁侠》中的J.A.R.V.I.S一样,精准高效地理解并响应各种复杂任务。但随之而来的一个挑战则是,如何在保持对话连贯和准确的同时,管理和优化聊天历史的上下文信息。上下文剪枝(Context Pruning)正是在这一背景下应运而生的关键技术。上下文剪枝指的是在对话过程中,有选择地删除那些对未来交互不再必要的信息,从而避免信息冗余和上下文膨胀,提高模型运行效率和响应速度。特别是在需要调用多个工具解决复杂任务的对话智能体中,上下文剪枝的重要性尤为突出。

例如一个数学助手,需要依次调用方程求解器和导数计算工具来回应用户的问题。如果将所有对话中产生的工具调用信息全部保留,上下文会迅速膨胀,导致后续模型推理时计算负担加重,且可能因信息冗余引入更多的认知噪声。为了克服这一问题,对话式智能体设计者引入了阶段感知的剪枝策略。系统根据当前任务的状态分为处理(PROCESSING)阶段和完成(COMPLETED)阶段。在处理阶段,智能体可能仍在向用户询问补充信息或调用多次工具,因此保持完整的上下文至关重要。而一旦进入完成阶段,说明当前任务已经顺利解决,相关的工具调用细节便可被安全地移除或汇总,以此缩减上下文长度,降低模型的计算压力。

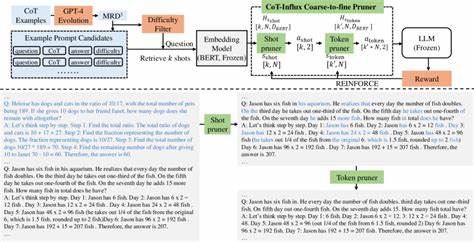

实现这一剪枝策略通常借助于任务状态标识。例如,通过在对用户的消息中附加任务状态字段,模型可以明确当前任务是否已经完成。基于此判断,剪枝机制能够有选择地触发上下文整理。整理操作不仅仅是删除工具调用记录,还能利用大语言模型自身的文本理解能力,将复杂的多轮对话摘要成简练的内容,从而既保留关键信息又极大节省token数。这种智能摘要的方法效果显著。一项实验证明,采用上下文剪枝技术的智能体,其输入token数量较无剪枝版本减少了约47%,输出token数量也有所降低。

由此带来的好处不仅仅是减少了API调用成本,更重要的是降低了模型 hallucination(幻觉)风险,提升了响应速度和对话准确率。上下文剪枝在实际应用中的体现非常丰富。举例来说,当用户请求求解一个二次方程,并随后询问其导数,智能体通过连续调用不同工具来分别获得答案,然后将结果合并反馈给用户。在这个过程中,智能体通过对话历史动态维护工具调用记录,确保理解和处理的连续性。而当任务标记为完成时,系统便自动触发上下文剪枝逻辑,清理不再必要的中间步骤,使对话历史保持精简,为后续的用户请求腾出空间。此外,剪枝策略还需灵活兼顾多轮对话中的澄清环节。

比如,用户首次请求积分计算时未给定具体表达式,智能体会先请求澄清。当用户提供详细信息后,智能体再调用相应的数学工具求解。此时,剪枝不能急于删除先前的对话内容,因为这些澄清信息对当前任务依旧重要。只有确认任务完全结束,系统才进行剪枝处理,防止意外丢失关键信息导致回答偏差。当前市面上也涌现出多种理论和框架支持上下文剪枝的实现方式,如文章中提到的BAML框架。BAML能够让开发者以函数式风格定义输入输出格式,自动生成类型安全的代码接口,大幅简化了上下文管理的复杂度。

结合BAML,开发者可以轻松实现多工具调用与上下文剪枝的高效协同,使对话智能体在功能丰富的同时依然保持良好的性能表现。综上所述,上下文剪枝是对话式智能体领域中提升用户体验和系统性能的关键技术之一。它通过精细管理对话历史,降低冗余信息带来的负担,减少计算资源消耗,并提升对话的准确性与响应速度。未来,随着更高级模型和工具集的涌现,上下文剪枝技术也将不断演进,成为智能助理构建不可或缺的重要环节。开发者应重视这一技术,通过合理的状态识别及动态上下文整理机制,为用户带来更智能、更高效的互动体验。 。