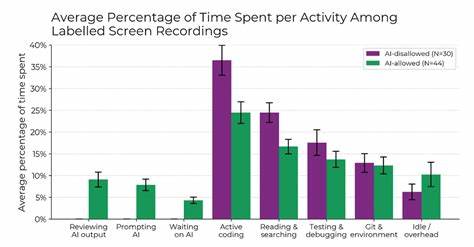

近年来,人工智能技术迅速渗透到软件开发领域,Cursor作为一种深度集成的AI编程辅助工具,因其能够加速代码编写和问题解决而备受开发者追捧。然而,最新由非营利组织Model Evaluation and Threat Research(METR)发布的研究却引发了行业广泛关注和讨论:使用Cursor等AI工具的开发者在处理真实bug修复时,整体耗时竟比不使用任何AI工具的开发者还要长19%。这一结果不仅打破了人们对AI辅助开发必定提效的普遍预期,也促使人们重新审视人在智能工具辅助下的工作效率和流程安排。研究招募了16位经验丰富的开发者,针对大型开源项目中的136个真实问题开展bug修复任务,并全程记录了146小时的屏幕录像。研究发现,虽然使用Cursor的开发者在实际编码的时间明显缩短,且在调研和测试环节花费的时间也较少,但他们在等待AI生成结果、审核AI输出以及在集成开发环境(IDE)内的相关操作上耗费了更多时间。这种额外时间几乎完全抵消了AI工具带来的编码与测试节省时长,导致整体任务完成时间反而增长。

更为有趣的是,研究中开发者对AI工具提升效率的预期与实际体验存在显著差距。在任务开始前,开发者平均预计AI会提升24%的速度,即使在感知到实际进度放缓之后,他们仍然坚信自己加速了20%。这反映出人们对新兴技术的高度乐观和认知偏差,也突显了主观感受与客观数据之间的落差。值得注意的是,虽然本次研究聚焦Cursor,但相关结论并不限于该工具,实际上适用于大多数当前市面上的AI编程辅助工具。Cursor的重要参与群体中,约44%的开发者此前未曾使用过该工具,而剩余的开发者使用时间多在50小时以内。令人期待的是,唯一一位使用Cursor超过50小时的开发者表现出高达38%的速度提升,但由于样本单一,这一现象尚无法简单外推到整体群体。

行业专家Simon Willison对此指出,AI辅助开发的学习曲线较为陡峭,开发者在将其引入现有工作流之初难免遭遇效率下滑,这与熟练掌握一项新技术所需的时间相符。深入分析AI工具的低效原因,可以发现几大核心问题。首先,AI工具的响应时间和生成代码的质量存在波动,等待期间的“死板时间”迫使开发者不得不中断手头工作,转而进行非核心事务,导致频繁的上下文切换,严重削弱专注力和“进入状态(in the zone)”的能力。软件开发是一项高度依赖持续专注和深度思考的工作,任何因等待或分心带来的中断都可能放大任务的整体时长。其次,AI生成的代码片段或解决方案并非完美无缺,开发者需要投入大量时间进行审核和调试,防止潜在错误流入最终产品。尤其是面对复杂或边缘性很强的系统代码,当前AI工具的表现参差不齐,且存在明显短板,这进一步增加了人工干预的成本。

第三,当前的AI辅助工具在较为低层次的系统编程或并行计算等领域表现欠佳,缺少足够的训练数据和针对性的能力评估标准,使得AI并不能成为某些特定开发环节的可靠帮手。技术从业者Quentin Anthony也在研究中分享了他的经验,指出AI工具既是生产力的加速器,也可能成为上瘾的“多巴胺快捷键”,诱使开发者反复尝试“神奇一键解决”的幻象,掉入效率的陷阱。此外,他强调合理设定时间界限、明确AI工具的适用任务范围,以及良好的数字习惯(例如关闭社交媒体通知、合理安排工作与休息)都能帮助开发者更有效地利用AI。从更宏观的视角看,AI辅助编程正处于快速进化和应用初期,未来的提升空间巨大。如何设计更加智能和高效的交互流程,减少等待时间的浪费,强化AI输出的准确性和相关度,将成为技术研发和应用优化的重点。同时,培养开发者对AI工具的正确认知与使用习惯,帮助其充分利用优势而规避陷阱,是提升整体生产力的关键。

在实际工作中,开发者需要理性看待AI工具,避免将其视为解决所有问题的万能钥匙。将AI辅助作为增强而非替代自身能力的辅助工具,合理规划使用场景和时间,关注代码质量而非单纯追求速度,才能带来真正的效率提升。总结来看,当前AI辅助编程工具如Cursor在帮助开发者减少编码时间的同时,却因等待响应、审核输出和多次操作所带来的额外开销,导致整体工作耗时增加。这种现象部分源于AI技术本身尚未成熟,部分则来自开发者对工具使用与工作流程调整的适应期。未来,随着AI模型性能的不断提升和工具设计的精细化,结合开发者对新技术的深入理解,AI辅助编程仍有望释放更大潜能,成为催生软件开发新时代的重要推动力。与此同时,技术社区、企业与研究机构应持续关注AI工具的实际影响,通过科学的实地评估和经验分享,推动技术与人类智慧的协同进步,从而真正实现提高开发效率、提升产品质量的目标。

。