在现代计算机视觉与图形学领域,三维场景的高效重建与渲染已经成为技术发展的焦点。传统的3D高斯点云渲染技术虽然在速度和效率上表现出色,但受限于其基于均匀加权近邻(EWA)点云投影的线性近似,难以处理复杂的相机畸变和时变效应,如鱼眼镜头的非线性畸变及滚动快门效应。此外,传统方法对次级光线的处理能力有限,难以真实模拟反射和折射等光学现象。3DGUT应运而生,通过引入Unscented变换(UT)的创新投影机制,不仅突破了传统高斯点云渲染框架的桎梏,同时兼顾了渲染效率和视觉质量,在多个关键应用领域表现出极大的潜力和优势。3DGUT是由多位来自NVIDIA和多伦多大学的顶尖科研人员合作研发,并将于2025年CVPR大会上以口头报告形式呈现的前沿成果。传统3D高斯点云渲染方法基于EWA splatting的线性化策略,需要为每一种相机模型导出专用的雅可比矩阵(Jacobian),这带来了数个不可忽视的问题。

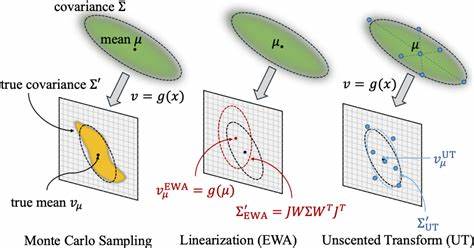

首先,线性近似在面对高度非线性畸变的镜头(如鱼眼、广角镜头)时,误差迅速积累,导致重建图像失真。其次,对于动态畸变因素,比如滚动快门导致的时间依赖变形,基于EWA的线性化方法难以进行有效建模,往往会出现撕裂和失配等视觉伪影。最后,EWA方法本身难以准确处理复杂的次级光线现象,限制了其在反射、折射等真实光学环境模拟中的应用。为解决上述挑战,3DGUT提出了基于Unscented变换的高斯点云投影算法。Unscented变换以一组称为Sigma点的特征采样点,捕捉高斯分布的关键统计信息,然后通过任意非线性投影函数对这些点进行精确投影,进而有效估计二维成像平面上的高斯椭圆。这种无偏估计不仅避免了对投影函数的线性化依赖,更能适应各种复杂且动态变化的相机参数,包括鱼眼畸变和滚动快门效应,稳定地提升投影精度。

通过替代原有的EWA splatting公式,3DGUT保持了实时渲染的高效性,且渲染质量显著提升。除了畸变相机的支持外,3DGUT还突破性地融合了次级光线追踪能力,弥合了传统基于体积渲染与光线追踪的技术差异。具体来说,3DGUT首先采用高斯点云的splatting方法完成初级光线的投影与渲染,对于每条光线,筛除发生在最近交点之后的高斯粒子响应,以保证场景遮挡关系的准确性。随后,基于场景的3D表示,3DGUT启用与3DGRT兼容的次级光线追踪模块,实现光线的反射和折射效应。这种混合渲染策略既维持了高性能渲染的优势,也充分展现了复杂光学现象,极大丰富了场景的真实感和细节表现。值得关注的是,相比专门针对鱼眼相机设计的FisheyeGS方法,3DGUT在保持粒子数量最低的情况下取得了更优视觉效果和感知指标。

其通用且无须衍生复杂雅可比矩阵的优势,使其能够灵活适应多种不同的相机模型和非线性效应,极大提升了技术的适用范围和实用价值。具体应用方面,3DGUT在自动驾驶及机器人领域的场景重建中表现出色。现实世界中,自主车辆采集的图像往往伴随动态时间畸变(如高频滚动快门效应)及复杂镜头畸变,传统技术难以保证重建效果的稳定与真实性。而采用3DGUT技术,可以自然地融入相机的时间依赖效应,实时产出高保真三维场景模型,助力导航、感知和决策系统的性能提升。技术验证层面,通过与蒙特卡洛采样的参考投影比较,3DGUT展示了更低的Kullback-Leibler散度,特别是在非线性鱼眼相机及滚动快门场景下,投影精度稳健优于传统EWA方法。渲染过程中常见的撕裂伪影问题也得到了有效抑制。

3DGUT的研发意义不仅在于理论方法的创新,更体现在其对行业生态的积极推动。随着增强现实(AR)、虚拟现实(VR)、自动驾驶和智能机器人等应用对高质量三维重建技术的需求日益增长,3DGUT所构建的灵活、高效、泛化能力强的三维表达与渲染体系具备广阔的市场前景和应用潜力。它可大幅减少对特殊硬件的依赖,实现硬件普适性的高质量渲染方案,为未来智能视觉系统奠定坚实基础。此外,3DGUT作为一种通用框架,其核心的Unscented变换策略也为其他基于概率分布的三维投影和渲染技术提供了启示,有望在医疗成像、地理信息系统、工业检测等领域引发进一步突破。综上,3DGUT代表了高斯点云渲染技术向智能化、多元化方向迈出的关键一步。它结合了数学理论的严谨性和工程实现的卓越性能,跨越了现有相机模型和光线模拟的局限,为复杂真实世界场景的高质量实时渲染开辟了新路径。

未来,随着技术不断完善和应用场景的扩展,3DGUT有望成为推动计算机视觉与图形学融合发展的重要引擎,助力智能时代视觉感知与呈现达到新的高度。