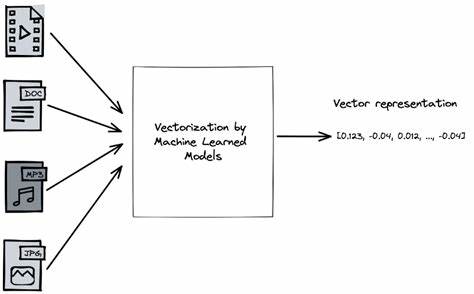

近年来,机器学习领域迅猛发展,其背后的计算效率和模型复杂度问题日益受到关注。特别是在神经网络训练和推理过程中,向量化技术已经成为提升计算速度的关键手段。向量化不仅减少了重复计算,提高了硬件利用率,还为实现更复杂的数学运算提供了基础。本文将深度剖析一种有趣的自动向量化思路,即通过对标量级别的计算图进行优化,转变为高效的向量操作,从而实现机器学习模型的性能跃升。 传统机器学习框架多数基于微分计算图,底层以标量运算为单位,逐节点执行。这种设计虽然易于理解和实现,但当面对高维数据时,其性能瓶颈十分明显。

例如,在多层感知机(MLP)前馈计算中,点积操作往往被拆解为大量标量乘法与加法节点的嵌套树形结构,导致图的规模膨胀,执行效率降低。以一个简单的点积计算为例,将两个向量相乘并累加的过程通常表现为多个二元乘法节点,随后通过大量级联的加法节点逐步累积结果,这样的计算图复杂且冗长。 而理论上,点积本质上是向量的内积运算,理应以“多输入加法节点”和“向量乘法节点”来表达,这样可以大幅度降低计算图的深度和节点数量。一旦能在计算图中发现并抽象出多个标量操作的共性结构,将分散的乘法和加法节点自动融合成高维向量操作,便能实现计算效率的提升。如何识别并实现这一自动向量化便是本文探讨的核心。 为了解决这一问题,研究者引入了联合查找(Union-Find)数据结构作为中间层的辅助优化工具。

联合查找结构能够将图中节点归并成等价类,定义了查询节点代表元素以及合并节点集合的操作。其根本作用是将多个等价节点关联在一起,通过代表元的查找实现节点的快速替代和优化。将其应用于计算图元素时,就能动态地维护节点之间的“等价关系”,标记那些能被优化成同一计算结果的节点。 在具体实现中,需要对标量级Value类进行修改,新增forwarded字段用以指向当前节点优化后的代表节点。利用find()方法可返回节点的最优代表,其余方法则支持获取经优化后的参数。此结构使得纯函数式图复制频繁发生的副本开销得以避免,优化链上的节点操作更为高效和简洁。

同时这种机制支持保留旧图节点,方便调试和验证优化过程的正确性。 联合查找的运用为实现多节点加法的扁平化铺平了道路。通常,点积中加法节点构成深度递归的冗余树,若能将嵌套加法节点的子节点统一提取并重新组合成一个宽的多元加法节点,则原本必须经过多次节点遍历的累加计算可合为一步处理。这不仅简化了图结构,也极大减少了计算步骤,提升了图的可读性和执行效率。 引入自动优化函数时,遍历由叶节点至根节点的拓扑排序序列,能依次将深层加法节点展开合并。该过程通过识别加法节点的子节点中是否还存在加法,递归提取其子节点,合并为一个节点的子节点列表。

最终生成一个更高维度的加法节点,将之前分散的计算统一。这样一次次的合并在图中层层递进,能显著降低加法节点数量。实验证明,此法能将数万个加法节点精简至少数几十个,带来爆发式优化效果。 得到高维度加法节点后,下一步是将“加法的乘法子节点”转换为高阶的点积运算核。以往的乘法节点仍是二元标量乘法,将其左右节点分别汇聚为两个同序数组,构造新的Array类型节点,代表向量集合。最终,以Dot节点代表两组向量的点积操作,替代原来的冗长标量计算链。

这里的Array节点本质上是将多个标量节点聚合,形成逻辑上的向量。Dot节点实现了前向计算和反向传播的自定义逻辑,使得梯度计算在向量层面完成,效率与效率俱增。 为了避免在每次遇到相同集合节点时重复创建逻辑相同的Array,系统利用缓存机制(Hashcons)对构造的Array节点进行记忆化处理,确保相同参数集合总共只创建一次,避免内存浪费和重复计算。此举极大地提升了资源利用率并加速图的构建。 至此,整个优化体系将原始三万多个标量乘法和加法节点,浓缩成数十个Dot和Array节点,同时仍保留其他操作节点(如ReLU等),不破坏模型的多样性和复杂性。通过这样的自动向量化,计算图变得更接近硬件支持的高效矩阵运算范式,有利于后续硬件加速器或指令集优化的开发。

除此之外,该技术的另一个优点在于其对图结构不可破坏的特性。优化过程通过添加forwarded指针建立版本替代,而非直接破坏原有节点,使得计算图的历史版本依旧可追溯,方便调试、错误定位和逐步改进。且在垃圾回收机制完善的语言环境中,未被使用的无效节点最终能自动清除,保障内存清洁。 尽管目前手动为Dot节点设计了反向传播函数,未来自动合成反向传播代数表达式的可能性也引发了作者浓厚兴趣。自动生成可复用、准确的梯度传播机制不仅能节约开发成本,还会让图优化技术更为灵活,适应更多复杂操作与复合算子。 此后,如何进一步将点积转换为更加通用且高效的矩阵乘法(Matmul)、提升指令调度以发挥CPU SIMD指令集优势,是未来研究和工程转化的重要方向。

对更高阶的机器学习模型如GPT系列的小规模版本(如femtoGPT)进行探索,有望充分验证该自动向量化方法带来的性能提升空间。 最后,作者提醒务必严肃思考机器学习技术的社会价值和潜在风险,警惕陷入“为解决问题而解决问题”的陷阱,确保应用真正惠及人类。通过一次深度的设计与优化实践,机器学习模型向量化从理论到代码落地得以展现,同时也让我们看见计算图优化背后的编译器哲学与创新思维。 综合来看,自动向量化技术作为连接底层标量实现和高效向量矩阵运算的桥梁,具有极大潜力提升机器学习模型表达能力和计算效率。通过融入联合查找数据结构和巧妙的图变换算法,能有效地简化计算图结构,挖掘高层次的数学表达,有望成为新一代机器学习框架性能革命的催化剂。未来在功能完整性和性能优化上持续探索,将为复杂模型的训练和推理开辟更高效、更智能的软件架构路径。

。