在数字时代,科技巨头已成为人们日常生活不可或缺的一部分。从社交媒体到虚拟现实,这些平台不仅塑造了人们的交流和娱乐方式,也影响着社会的整体结构。然而,科技企业内部存在的系统性偏见逐渐暴露出其深远的负面影响,尤其是在产品安全性方面。这些偏见不仅导致了产品设计的缺陷,更在虚拟空间和现实世界中制造了严重的安全隐患,特别是对女性和儿童的保护不足。探索这些问题的根源,有助于推动行业变革,确保科技发展真正造福社会。Meta公司的案例成为理解这一问题的典型代表。

Meta构建的“元宇宙”平台——Horizon Worlds,曾被调查者报告存在广泛的性骚扰和虚拟性侵行为,其中女性和未成年儿童更是频频成为受害者。不仅如此,平台对这些行为的监管缺失,以及对举报的忽视,加剧了问题的恶化。Laura Bates的调查揭示,进入Horizon Worlds后短短几个小时内,她便目睹了虚拟性侵的发生,孩子们受到成人玩家的言语和行为骚扰,而平台经营者未采取有效措施进行干预。从更广泛的背景看,Meta内部存在着系统性的性别偏见和文化缺陷,这种文化不仅在产品开发和管理层决策中显现,也直接影响了用户体验的安全性。Kelly Stonelake作为前Meta产品营销主管,亲历并揭露了公司内部对女性员工的系统性歧视和骚扰。她曾因揭露安全隐患和性别不公,遭遇职场打压甚至报复。

这种种迹象表明,产品设计中的安全缺陷并非偶然,而是深植于公司文化和组织架构的系统性问题。在Horizon Worlds内部测试时,管理层明知有年龄不足13岁的儿童使用成人账户进入平台,面对明显的儿童安全风险,却选择迁移测试环境以避开这些问题,而非正视和解决。这种应对态度暴露出公司将商业利益置于用户安全之上的倾向。与此同时,对女性员工的沉默和剥夺发声权,削弱了外部安全隐患的预警能力。多年来,关于Meta及其它科技公司安全事故的报道层出不穷。BBC发现儿童轻易进入虚拟表演场所,华盛顿邮报披露公司对元宇宙监管的放任,纽约时报揭示未成年用户长时间沉浸虚拟世界,所有这些都共同描绘出一个缺乏有效安全保护的数字生态系统。

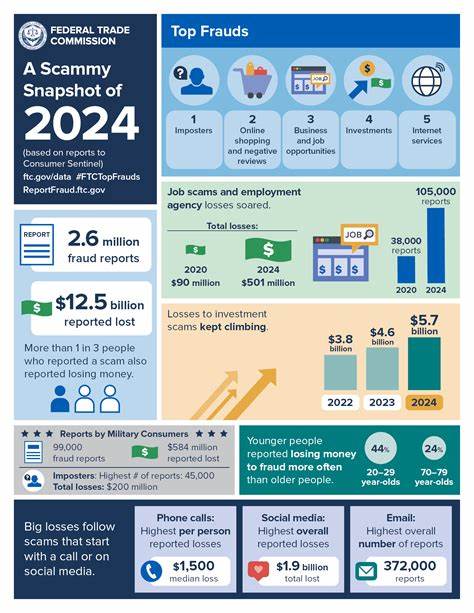

更严重的是,这种系统性问题不仅影响单一公司,而是普遍存在于多个科技巨头中。Instagram算法加剧青少年女孩的心理健康问题,前员工揭露的内部文件显示公司对相关研究视而不见。这些事件反映出,内部决策往往忽视甚至压制那些最有可能识别风险的人群,尤其是女性和弱势群体,使产品设计偏离真实用户的需求和安全保障。虚拟现实技术的沉浸性加剧了虚拟骚扰的心理创伤。研究表明,VR环境中的性骚扰可引发与现实中遭遇身体侵犯类似的生理和心理反应。用户平均每七分钟就会遭遇一次骚扰,儿童多次遭受露骨的性言语和行为侵害。

这些统计数字背后,是家庭、社会乃至整个网络环境的安全危机。业内声音指出,改变这一现状的关键在于改变公司内部文化,打破性别偏见和权力结构对声音的压制。管理层需要建立真正开放和包容的环境,积极听取来自不同背景员工的意见,尤其是那些直接关注产品风险的人。同时,监管机构也应介入,制定和执行更为严格的数字安全法规,特别是在儿童和弱势群体保护方面。当前,立法者正推动包括美国的儿童在线安全法案在内的多项法律,试图对数字平台设立安全门槛,防止类似Horizon Worlds中曝光的风险重演。然而,立法保障无法独立解决所有问题,企业内部的多元化、公平和包容政策的坚实落地同样至关重要。

撤销或削弱这些政策只会让潜在的风险监测和预警机制失效,埋下更多隐患。值得注意的是,面对业界和公众的质疑,大型科技公司经常采用“数据数字转移注意力”的策略,声称自身已实现性别员工比例平衡,却无视员工实际的工作环境和遭受的不公待遇。Kelly Stonelake与其他女性举报者的经历表明,职场性别偏见和骚扰如影随形,导致优秀女性流失,进一步削弱了企业创新能力和安全治理水平。总结来看,科技巨头内部根深蒂固的系统性偏见不仅侵蚀员工福祉,更直接体现在产品设计中,制造出大量安全隐患,特别是在虚拟空间中对女性和儿童的威胁。要解决这一问题,需从人才多样性入手,改变恶劣的企业文化,提升管理透明度和责任感。同时,结合强有力的立法监管,为用户设定最低安全标准,确保数字空间的公平与安全。

未来,只有真正聆听来自一线和多样化群体的声音,科技发展才能避免重蹈覆辙,创造出更加安全、包容和有益的数字生态环境。