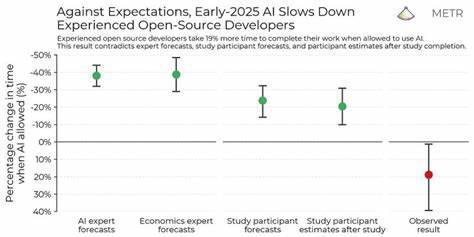

生成式人工智能(Generative AI)作为近年来科技领域的热门话题,尤其在编程领域展现出巨大的潜力。许多人将AI视为程序员的得力助手,期待其能够加速代码编写,优化开发流程,甚至在某种程度上实现自动编程。然而,最新来自AI基准测试组织METR的一项随机对照试验显示,现实状况远非预期那般理想,相反AI辅助反而可能带来效率倒退。METR的研究主要针对具有多年开源软件开发经验的资深程序员,任务涵盖他们熟悉的复杂项目代码。这些开发者起初对AI工具寄予厚望,预期可提升约二十个百分点的任务完成速度,但实际结果令人震惊:使用AI工具导致开发时间平均增加了19%。这一矛盾的结果引发了业界对AI编程辅助效用的深刻反思。

之所以出现效率下降,原因可能多方面交织。首先,生成的代码尽管能够快速完成初步编写,但往往缺乏针对具体项目需求的精细优化,开发者需要耗费大量时间进行审查、调试和修改。调试非自己手写代码本身就是开发过程中的难点,AI生成的代码复杂度不匹配项目实际需求时,这一挑战愈加突出。此外,AI助手并非总能理解代码的上下文及业务逻辑,导致出现逻辑漏洞或错误实现,进而需要更多人力纠正和测试。其次,研究所针对的开发者为经验丰富的资深程序员,他们在无辅助的情况下已具备高效编码的能力。AI工具的引入可能打破了已有流程和习惯,带来适应成本。

更重要的是,这类高级开发者在面对复杂问题时,往往依赖自身深入的领域知识和创造性思考,AI工具在当前阶段还难以替代这种专业判断。 研究中也提及,在不同背景和项目规模下,AI工具的表现可能有所差异。对于新手程序员、小型项目或者不要求极高质量标准的快速迭代环境,AI的辅助作用可能更为明显。换言之,AI编程工具并非毫无价值,而是在特定场景下更具优势。此外,METR团队乐观地认为,这项研究数据仅为2025年早期的快照,随着技术的不断进步,AI在编程领域的辅助性能仍有望得到显著提升。与此同时,也有开发者分享了个人体验,说明AI编程助手在某些情况下确实成为了他们实现目标的关键。

特别是当面对自己不了解的技术栈或需要快速原型开发时,通过与AI模型的互动,他们能高效获得代码片段、解决方案甚至是调试建议,极大地降低了入门门槛和时间成本。这种基于对话的协作模式也为未来AI与程序员的关系设定了新基调。 然而,伴随AI编程助手的使用,业界也需警惕不少潜在问题。首先是对代码质量的过度信任和浅层次测试。简单依赖生成代码而忽视后续严谨审查,很可能导致积累隐患,影响软件的稳定性和安全性。其次,复杂项目中的协作和代码维护要求高度一致的风格、规范和理解,AI生成的代码往往难以完全符合团队标准,也可能增加协调成本。

更深层次的挑战在于认知偏差。开发者容易陷入“感觉上节省了时间”的错觉,忽略了AI辅助背后的认知负担和隐藏成本。正如研究中提及的“心智幻觉”现象,个体主观体验与客观效率指标存在脱节,进而引发对AI工具效用的误判。 长远来看,AI编程技术仍处于飞速演进阶段。未来的突破可能源自更精准的上下文理解、更强的逻辑推理能力以及与人类开发者更自然高效的交互方式。模式融合、自动调试与代码评审一体化、行业特定模型的深度定制等方向均充满潜力。

与此同时,教育培训也需与时俱进,帮助程序员提升使用AI工具的能力和辨识代码质量的眼光。要实现“让AI真正成为程序员的生产力助推器”,离不开技术、流程与文化的协同优化。总结来看,当前生成式AI在编程领域的实际效用与行业期待尚有较大差距。研究结果提醒我们,不能单纯凭借直觉和个别成功案例评价AI技术,必须坚持数据驱动、实证分析,全面理解工具带来的正负面影响。AI编程助手应被视为一种辅助选项,而非万能钥匙,程序员的专业知识及批判性思维仍不可替代。随着更多研究与技术迭代,我们有理由期待这一领域的未来更加精彩与高效。

对于从业人员而言,理性看待AI带来的便利与挑战,在实际工作中不断摸索最佳协同方式,才是驾驭这一变革的关键所在。