在现代计算领域,线性规划作为一种重要的数学优化工具,被广泛应用于供应链管理、金融风险控制、资源分配等诸多领域。随着问题规模不断扩大,传统CPU求解器在处理大规模优化问题时面临性能瓶颈,迫切需要更高效的计算平台。NVIDIA的CuOpt项目,通过GPU加速的优化算法,为线性规划求解带来了革命性的变革。本文将深入探讨CuOpt的发展背景、安装使用体验、性能表现及其未来应用潜力。 NVIDIA在去年宣布了基于GPU加速的PDLP(Primal-Dual Linear Programming)实现方案,并展示了其在MIPLIB基准库中的表现。该技术声称在60%的测试问题上,运行速度优于当前最先进的基于CPU的线性规划求解器。

这一结果为传统优化领域注入了新活力,但与此同时,早期的报告中也提及该方法在某些问题上存在收敛性和准确度方面的挑战,业内如HiGHS通讯和FICO博客也对此表示了关注。 令人振奋的是,NVIDIA秉持开源精神,将CuOpt项目开源,并将其纳入了知名的COIN-OR代码库中,助力全球开发者更便捷地接入、使用和优化该工具。这一举措不仅推动了学术界与工业界的合作,也为优化算法的迭代升级奠定了坚实基础。 要体验CuOpt强大的功能,首先需要具备支持CUDA的NVIDIA GPU。GPU的强并行计算能力能够充分挖掘大规模优化问题中潜在的计算优势,从而显著提升求解速度。用户可以选择云服务提供商的GPU实例,如Linode的RTX4000 Ada GPU,合理控制成本并利用镜像服务管理实例,保证在闲置期间节省开支。

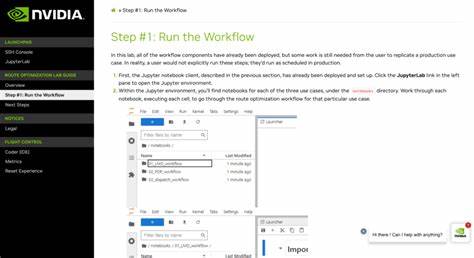

CuOpt的安装过程相对简单,唯一的挑战是初次配置CUDA驱动程序时可能遇到的复杂性。为此,有社区贡献的脚本能自动完成驱动安装与CuOpt库的搭建,显著缩短配置时间。经过测试,整个安装流程通常在十五分钟左右便可完成,用户可以迅速开始求解大规模优化问题。 启动CuOpt求解器后,用户可通过命令行轻松调用功能。例如,针对MIPLIB中的一个中型大规模问题triptim1,包含约3万个变量和1.5万个约束,用户可设置解的相对误差阈值及时间限制以平衡速度和求解精度。实际运行中,GPU资源长时间接近满负荷运行,而CPU利用率相较之下较低,显示出CuOpt充分利用GPU并行优势的特点。

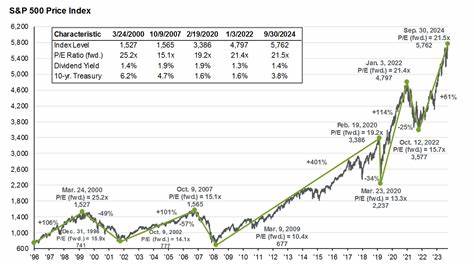

近年来,CPU主频提升趋于停滞,受限于功耗和散热极限,硬件性能提升逐渐依赖多核架构及算法优化。PDLP通过大幅度扩大并行计算比例,使得计算性能不再受单核频率限制。借助GPU集群的规模化扩展,求解器性能获得了质的飞跃,能够应对前所未有的超大规模优化模型。 关于CuOpt的性能扩展性,市场上不同型号的GPU在大规模线性规划上的表现值得关注。近期Mittelmann LP基准测试显示,NVIDIA的H100 GPU在处理百万级变量和数千万约束的超大规模模型时,相较于RTX A6000,平均性能提升约2至6倍,尽管H100价格高出五倍左右。这些数据显示,选择性能更强的GPU节点,能够显著缩短求解时间,极大提升工作效率。

然而,超大规模GPU在不同类型问题上的表现差异明显。某些问题因特殊结构或数据分布,可能未必完全受益于硬件升级。因此,用户应结合自己实际问题特点,合理评估CuOpt的适用性及硬件需求。积极尝试不同GPU配置,将有助于深入理解其实际扩展潜力。 从更广阔的视角来看,GPU正在重塑计算优化领域。人工智能和深度学习的迅猛发展推动GPU硬件快速升级,这也为数理优化带来前所未有的机遇。

CuOpt的开源策略及技术领先性,不仅激励开源社区与商业软硬件厂商持续改进和创新,也将促进更高效、更智能的优化方案问世。 总结来看,NVIDIA CuOpt为线性规划求解带来了可观的性能提升,充分体现了GPU加速的巨大优势。其开源并入COIN-OR平台,降低了科研及工业界应用门槛,为技术进步和跨界融合提供了坚实平台。面对未来日益复杂的优化挑战,CuOpt与GPU计算的结合无疑是推动行业迈向智能决策新时代的重要力量。 借助CuOpt,优化算法与硬件协同进化,将不断突破计算极限,赋能各类企业和研究机构,实现资源最优配置和运营效率最大化。无论是学术研究,还是工业应用,CuOpt都值得深入探索和积极实践。

展望未来,随着硬件架构与算法不断创新升级,GPU加速的数理优化技术毫无疑问将成为产业数字化转型的关键利器。