随着人工智能技术的快速发展,尤其是大型语言模型(LLM)在各行各业的应用,越来越多的工程团队开始探索将AI引入到运维(Site Reliability Engineering,简写为SRE)领域的可能性。AI SRE承诺能够实现自动化的故障诊断及问题解决,极大提升运维效率,减少人为干预。然而,构建一个可靠的AI SRE系统远非简单地将一个LLM连接至监控仪表盘那么简单。背后隐藏着诸多复杂的技术难题和实践挑战,需要系统性地理解和应对。今天,我们将深入解读构建AI SRE的复杂性,探索如何突破瓶颈,实现真正有效且可信赖的AI运维解决方案。首先,生产环境的动态变化成为AI SRE难以逾越的第一道坎。

传统的LLM擅长处理静态数据集,但现实中的生产系统却是一个持续演化、充满历史遗留痕迹和复杂服务交互的动态生态。每家公司的技术栈、配置、工具乃至隐性知识都有所不同,这让AI系统难以快速准确地"读懂"环境。举例来说,一个在公司架构图中未被记载的Redis实例,可能在突发流量模式下引发性能瓶颈,若AI未能侦测到这一隐藏依赖,定位问题将无从谈起。其次,真实运维事故的失败模式往往是组合性的恶梦。一次服务异常通常不是因为单一因素所致,而是多个问题交织叠加的结果。CPU飙升、连接池饱和、延迟陡升、错误率激增,随后引发下游服务的级联故障,整个事件犹如连锁反应般层层推进。

AI SRE不仅需要识别这些信号的时间顺序和因果关系,还需要在凌晨疲惫的环境下高效分析,避免被表面现象所迷惑。仅仅依赖表面模式匹配无法满足需求,更需要深入理解复杂系统的因果逻辑和多假设同步推理。知识管理的复杂性进一步加剧了AI SRE的构建难度。运维领域的知识来源既丰富又多样,包括文档、代码、日志、配置和团队经验等。且这些知识不断更新,甚至可能存在内部冲突。例如某服务依赖关系在不同时间或维护期间会发生变化,数据库主从角色的切换策略也不时调整。

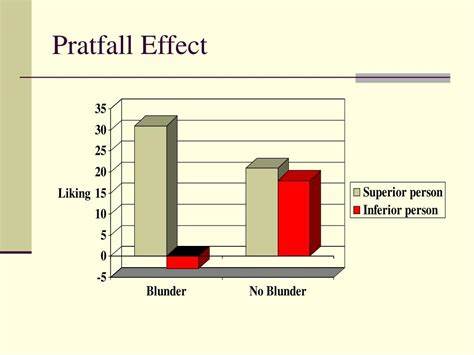

这种复杂多变的知识体系需要AI具备强大的动态更新与冲突识别能力。此外,合理表示和维护这些知识是构建自身学习系统的前提。关于信任问题,则是AI运维系统落地应用的另一大障碍。故障根因通常没有唯一确定的答案,多个因素均可能成为触发点。AI若过度自信地给出单一方案,很可能导致误判,进而浪费工程师宝贵时间和精力。相反,若过于谨慎,频繁给出模糊或多样选项,也会降低其权威性和使用价值。

因此,AI SRE必须在推理结果的置信度上做出精准平衡,在恰当时机坦承不确定并给出有限范围内的可靠建议。与此同时,运维工具的深度运用亦远超简单调用API。AI需要明确知道如何准确构造查询语句,如何设置合理的参数,以及如何结合历史数据进行多维度对比,进而有效过滤噪声、发现实质问题。例如,在使用Datadog监控时,对比当前CPU使用数据与上周同期的历史趋势能够显著提升分析准确度。大量调查往往不是一次性单查询完成,而是多轮、多系统、多维度的反复迭代,这对AI的运行效率和权限管理提出了极高要求。最后,运营数据的稀缺与质量问题限制了传统机器学习方法的发挥。

与代码补全或聊天机器人领域拥有海量干净的训练数据不同,运维领域缺少大量标注明确、因果清晰的"故障-根因"样本。工程师通常不会对每次故障做详尽记录,且解决方案的环境相关性极强,经验难以简单迁移。这使得AI系统难以借助监督学习直接产生卓越效果,必须依赖更灵活的知识图谱推理和多指标综合判断。面对上述挑战,目前业界尝试了多种解决路径。建立隐含依赖关系的知识图谱是关键技术之一,通过系统化地索引和关联生产环境中的各种服务和数据,AI能够更好地理解因果链条而非孤立事实。与此同时,支持并行多假设调研也是提升诊断准确率的有效方法,让AI能同时探查多个潜在故障线索,减少陷入局部最优解的风险。

置信度评估机制则不断进阶,结合拓扑结构距离、多源独立证据以及历史案例相似度等多维信号,为推断结果打分,力求在保障准确性的同时减少冗余警报和误导。此外,AI系统需要设计为自适应演进,随着新问题的出现与知识更新不断改良推理策略。总而言之,构建一个高效、可靠的AI SRE系统并非一蹴而就的过程,而是一项涉及复杂系统理解、深度知识管理、多源数据融合及信任构建的长期工程。虽然当前尚未实现AI完全取代人类运维的梦想,但借助先进的技术手段,AI正逐步成为运维团队的重要辅助力量,极大提升反应速度和诊断准确度。未来,随着监控数据质量提升和因果分析技术成熟,AI SRE有望在更多企业中实现规模化落地,推动运维智能化迈入新阶段。面对动态多变的生产环境和日益复杂的技术挑战,唯有持续技术突破和人机协作,方能让人工智能真正助力运维工程师轻松驾驭系统稳定性,保障业务持续高效运行。

。