近年来,随着智能设备和监控摄像头的普及,视频已成为信息传播和数据存储的主要载体。相比传统文字和图像内容,视频融合了声音、动作和场景变化,信息量庞大且动态丰富。然而,面对海量的视频数据,如何让人工智能系统具备持续、多时段的视觉记忆与理解却成为了一大难题。大型视觉记忆模型(Large Visual Memory Model,简称LVMM)的诞生和推广,正是在这一背景下的技术创新和产业需求的共同推动下实现的。大型视觉记忆模型代表了人工智能从单帧图像识别向跨时域视频理解的飞跃。它通过深度学习和记忆增强技术,使AI不仅能够实时“看见”场景中的物体和人物,还能像人类一样持续“记住”视频中的事件细节,并通过自然语言接口进行智能查询和交互。

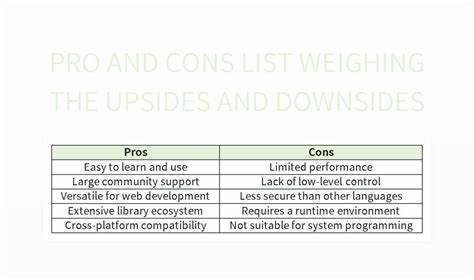

Memories.ai作为该领域的先驱,携手高通(Qualcomm)推出了大型视觉记忆模型2.0版本,将高效、隐私友好且功能强大的视觉记忆能力推向了移动端设备。不同于传统单一任务的视觉模型,LVMM具备全时段、多任务、多模态的记忆能力。它不仅支持对长时视频内容的快速检索,还能自动识别复杂行为,比如打斗场景计数、人物再识别、建筑风格辨析及经典台词提取。这种能力极大地提升了视频安全监控、媒体生产、视频营销、体育分析及机器人视觉交互的应用价值。在安全与监控领域,LVMM能够实时检测异常行为,自动生成视频证据,为事件响应和情报搜集提供强有力支持。同时,人物重识别技术支持跨摄像机多角度的持续追踪,即使人物外观发生变化,依然能精准匹配,极大地提升了安防监控的智能化水平。

跌倒检测、人员行为识别等功能则为工业安全和公共场所管理带来更高效的解决方案。媒体与内容生产领域,LVMM对长视频故事结构的自动理解与编辑,实现了视频内容的智能生成和快速剪辑。通过自然语言交互,创作者可以轻松制作清晰的分镜头脚本,自动生成影视素材,有效降低了繁重的人工编辑工作,让创意得到更快释放。视频营销借助大型视觉记忆模型的趋势分析和受众行为洞察,帮助品牌精准捕捉热门话题和热点内容,打造社交媒体上的爆款视频,实现更精准的用户触达和转化提升。体育领域通过对比赛视频的实时记忆和分析,支持战术研究与运动员表现评估,推动竞技策略的智能化升级。在机器人视觉中,LVMM赋予机器人持续感知环境的能力,结合任务记忆使其在动态环境中持续学习和调整行为,提升了机器人自主作业和服务交互的智能水准。

技术上,大型视觉记忆模型借助记忆增强强化学习、令牌压缩技术以及多模态融合,解决了海量视频数据处理时的计算瓶颈。MARC(Memory-Augmented RL Token Compression)技术的引入,有效减少了计算资源消耗,使得模型能够应对高帧率、时长极长的实际视频场景。与此同时,用户生成内容(UGC)成为视频生态的重要组成部分,UGC-VideoCaptioner模型及其相关评测标准应运而生,实现了对快节奏、多变视觉内容的深度理解和多模态描述,填补了细致视听内容自动化理解的技术空白。随着硬件端支持的加强,尤其是高通的强大芯片平台,未来消费者的手机、摄像头及可穿戴设备将直接搭载大型视觉记忆模型,实现“视频到记忆”的转换及智能搜索功能,突破了过往依赖云端计算的限制,提升用户隐私保护和响应速度。这一切进展标志着人工智能视觉理解进入了“眼见即所得,记忆即财富”的全新阶段。大型视觉记忆模型不仅仅是技术的创新,更代表人工智能从狭义工具向类人智能的质变跃迁。

它帮助机器真正理解视频内容的内在逻辑和时序信息,增强AI与人类用户之间的交互体验,让视觉数据转化为可操作、可分析、可利用的知识财富。伴随视频数据持续爆炸式增长,保持高效、准确、实时的视觉记忆和理解,将是各行各业实现数字化转型和智能升级的核心能力。大型视觉记忆模型无疑在此领域树立了行业标杆,推动视频智能迈向新高度。面对未来,随着算法持续优化和硬件性能提升,结合多模态数据和更加丰富的上下文理解,人工智能视觉记忆有望覆盖更多场景,服务于智慧城市、智能交通、在线教育、医疗健康等更广泛领域。个性化视频助手、智能视频知识库及自动创作系统也将成为现实,让视频数据的价值完全释放。总结来看,首个大型视觉记忆模型的诞生,是人工智能技术发展史上的重大里程碑。

它突破了传统视觉模型在长视频理解中的性能瓶颈,赋予AI“记忆”和“理解”的能力,促使智能系统能更深刻地洞察视觉世界,创造更大社会和商业价值。未来几年,随着产业生态的完善与应用落地,广大企业和个人用户都将因视觉记忆模型带来的技术革新而受益,迈入真正意义上的智能视觉新时代。