在数据库设计与维护过程中,主键的作用举足轻重。作为唯一标识一行数据的重要约束,主键不仅用于保证数据的完整性,也在查询优化、数据关联等方面发挥关键作用。然而,对于大量数据的批量导入操作,业界普遍存在一种观点:在数据加载时应先删除主键和其他索引,数据装载完毕后再重新创建,以获得更好的性能表现。本文将通过近期一组基于PostgreSQL数据库的实测数据,探讨主键对批量数据加载性能的真实影响,并着重分析为何在某些情况下保留主键反而可能带来性能优势。首先,我们回顾一下关于数据导入最佳实践的传统认知。传统的建议是:当需要向空表中导入大量数据时,先删除表中的所有索引和约束(尤其是主键和唯一索引),然后利用高效的批量导入命令加载数据。

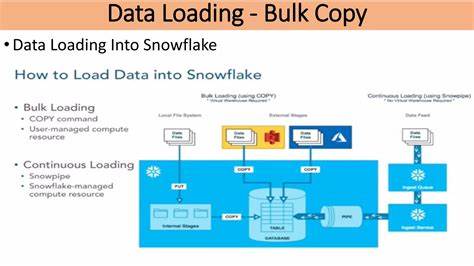

待数据导入完毕后,再重新启用约束并重建索引。如此操作可以避免在数据插入时频繁更新索引结构,从而大幅减轻磁盘I/O和CPU负担,理论上能够提升数据加载速度。很多数据库管理系统的文档和论坛也纷纷推荐采用如此流程。以PostgreSQL为例,官方文档明确指出,批量数据加载时关闭索引和约束,待完成后再重建索引,通常是优化性能的关键。但是,实际情况真的如此绝对吗?在近期对PostgreSQL 17版本的测试中,有一组令人有些意外的发现。测试以HammerDB工具生成的TPC-C基准订单行(order_line)表为对象,该表包含复杂的复合主键,数据量级庞大,达三亿至九亿行。

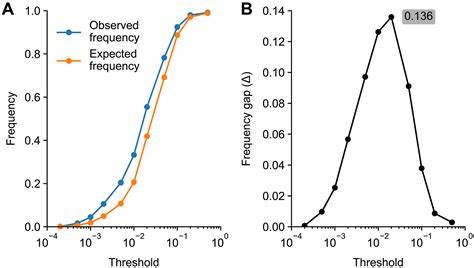

测试过程中,开发者分别进行了两种方案的大规模数据加载对比:一种是在保留主键约束的前提下直接导入数据,另一种则是在导入前删除主键索引,完成导入后再重建主键索引。出人意料的是,当数据量为三亿行时,保持主键索引的方案反而比先移除再重建主键的方案更快。数据显示,保留主键加载大约耗时二十分钟,而删除主键后加载数据仅花十分钟,但随后的主键重建耗时二十分钟,总计三十分钟,整体耗时实际更长。考虑到三亿行数据只占据约30GB空间,而测试机器配备了32GB内存,有猜测此现象可能与缓存机制相关。为验证这一假设,测试人员进一步扩大规模,产生了900百万(九亿)行订单数据,占用超百GB磁盘空间,明显超出内存容量。结果依旧显示保留主键更优,加载耗时一小时,先删除再重建方案总耗时约一小时半。

该结果挑战了长期以来的数据库加载性能优化经验。为确保测试的严谨性,诸多影响性能的变量均被控制,包括提升维护内存参数(maintenance_work_mem)、关闭干扰程序、使用多盘系统区分源数据和目标存储、避免网络瓶颈等。多次测试表明,主键在加载时并非性能的主要瓶颈。深入分析发现,PostgreSQL在不断发展中,其索引管理机制和写入优化算法得到了显著提升。在保持主键存在的情况下,数据导入时的索引维护成本被大幅削减,使得直接插入数据更有效率。此外,避免后期重建庞大索引这一操作也节约了大量时间。

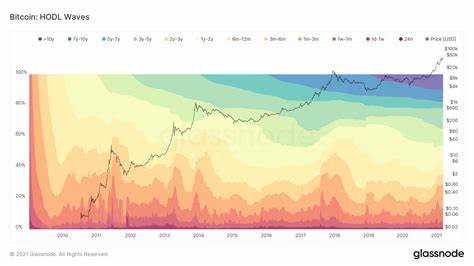

对数据库管理员和系统设计者而言,这一发现具有重要参考价值。面对大批量数据导入场景时,应摒弃盲目遵从“一定要先删除索引”的做法。相反,应结合具体系统环境进行性能测试,权衡各方面因素制定最佳策略。具体来说,如果硬件环境充足,维护内存参数得到优化且导入过程稳定顺畅,保留主键直接导入往往能够获得更快整体速度。与此同时,运维团队仍需关注磁盘性能、内存利用率及I/O分布等瓶颈因素,必要时进行硬件调整,优化文件系统和存储架构,保障导入环节顺利。不可否认,索引和约束在数据完整性和查询效率上扮演不可替代的角色,但从性能角度来看,现代数据库系统逐渐通过智能缓存和并行处理减轻了索引带来的写入压力,这给予更灵活的加载规划可能。

其次,重量级的主键索引往往是复杂复合索引,传统的分批删除和重建不仅效率低下,而且在维护高可用环境中存在风险。保留主键,结合速写数据导入方法如COPY命令和调整数据库参数(如sync_commit、wal_level、commit_delay等),效果更佳。总而言之,主键在批量导入过程中的性能影响已不再是固有瓶颈,这一点对于PostgreSQL数据库用户尤为重要。数据库管理员应根据真实环境进行一系列模拟测评,不断调整策略,避免因遵循过时规则导致的资源浪费和时间延长。未来,随着数据库系统不断优化,智能化数据导入方案必将成为主流。通过精准的参数调优和合理配置,主键约束与批量数据加载的矛盾能够得到自然平衡,推动数据库性能迈上更高台阶。

综上所述,主键存在与否对大批量数据加载性能的影响并非黑白分明。实际测试证明,保留主键在诸多现代场景下反而能发挥更佳性能表现。对于数据库性能优化者,这一结论提醒我们:不能盲目依赖传统经验,科学的测试和数据分析才是优化道路上最坚实的基石。面对不断演进的技术环境,唯有洞察本质,灵活应对,方能实现高效稳健的数据管理目标。