在当今信息爆炸和人工智能飞速发展的时代,数据科学的重要性日益凸显。然而,深度技术领域的数据科学远非简单地依赖海量数据与复杂算法就能成功。真正的科学分析必须追溯数据的根源,理解数据是如何从现实世界通过各种测量过程转化为可用信息的。只有这样,后续的一切分析、模型训练乃至决策制定才有坚实的基础。本文将深入探讨深度技术数据科学背后的两根支柱:如何测量和如何比较,以及为什么忽视它们会导致严重后果。以科学实验和创业环境中的实际案例,阐明严谨数据处理和统计分析的必要性。

任何成功的数据科学项目都始于对数据生成过程的精准把控。测量,是从现实世界到原始数字的转化过程,是特征提取的第一步。正如英国纪录片《克拉克森农场》中团队对于一间酒吧的细致装修,他们关注每一块砖瓦的用途和价值,数据科学家也应慎重对待每一个数据点的来源。仪器的精准度、测量条件、采样策略和环境因素都会影响数据的真实性和有效性。例如,荧光成像中,点扩散函数以及噪声特性决定了图像中光斑的看似亮度。若未充分理解这些测量局限,则所谓的“亮度翻倍”或许只是一场幻觉。

测量工具的微小偏差,如设备校准不当,都会在根本上影响结果,进而连带影响数据分析和模型表现。 数据的第一层清洗不仅仅是技术上的去噪,更是科学上的重构。这体现在Andrew Ng提出的数据中心AI理念中,即重视标签精准度、传感器漂移修正以及详细的来源记录,而非盲目追求更复杂的算法模型。完善的数据清洗和明晰的元数据管理能帮助我们更准确地反映现实状态,避免“垃圾进垃圾出”的陷阱。 另一根重要支柱是如何比较。数据背后是科学假设和实验设计,统计学和因果推断依赖于正确的比较规则。

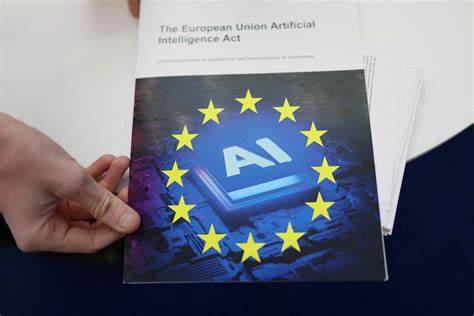

举例来说,若农场主只在阳光充足的地块施用新肥料,丰收的成果可能更多归功于光照条件而非肥料本身。缺乏科学的随机化、适当的对照和对潜在混淆因素的洞察,统计推断将失去根基,可能导致虚假的结论。在创业环境中,资源有限,实验规模小,错误的正负结果都可能带来巨大成本和机会损失。以新冠疫情初期为例,不同地区死亡率差异被错误解读为当地政策的奇迹,但当更全面的研究揭示年龄结构、检测覆盖和医疗压力的差异时,这些“奇迹”迅速破灭。 为何这两根支柱经常被忽视?快速而便捷的自动化工具和预训练模型令许多数据分析者迷失方向。Leo Breiman早在2001年就指出,数据科学界存在“两种文化”——一种关注算法性能,另一种关心数据生成过程。

当前技术趋势推动更多人沉迷于前者,忽略后者,导致错误风险升高。此外,学术培训中专业垂直划分严格,一个人很难同时掌握科学理论、仪器操作和统计方法,企业中更是如此。任务分工导致沟通壁垒,数据科学家承担了横向沟通与信息整合的关键责任,而领导层若不支持建立开放文化,则风险无形中增大。 在科学研究和创业项目中,真正的价值体现于能够守护好数据质量和比较规则的基础上,允许分析过程不断探求和反思。正如《克拉克森农场》中的酒吧开业需要千丝万缕的细节协作,数据科学也需多领域紧密配合,确保从现象到数值的转化精准无误。这样,构筑起的分析体系才有能力面对复杂问题,保持科学探究精神的活力。

深度技术数据科学不仅是一门技术学科,更多是一种综合能力的体现。它要求科学家的严谨态度、工程师的细致谨慎以及统计学家的逻辑思维。只有超越数据集本身,关注数据的起点和比较的基础,数据科学才能真正释放其潜力,驱动技术创新和商业成功。未来,推动数据科学文化变革、加强跨学科沟通将成为关键,唯有如此,才能避免浅尝辄止和自我迷失,让数据科学成为值得信赖的导航工具,助力社会迈入更智慧、更精确的时代。