随着人工智能技术的不断进步,语言模型的微调方案也日益丰富,强化微调(Reinforcement Fine-Tuning,简称RFT)作为一种新兴的训练方法,备受业内关注。OpenAI近期推出的基于强化学习的微调服务引发热议,不少开发者纷纷发问:花费高昂的RFT到底值不值得投资?为了给出准确答案,我们通过系统评测OpenAI的RFT与传统监督微调(Supervised Fine-Tuning,SFT)在三类典型任务上的表现和成本,对其优势和不足进行详细解析。探索清楚这三大使用场景,包括数据抽取、代理编码以及客户服务,对比两种微调方式的实际表现,能够帮助开发者规避盲目投入,同时也为未来技术改进指明方向。首先是在数据抽取任务中的表现。该任务依托于CoNLL++命名实体识别数据集,要求模型从非结构化文本中精确识别人名、地名、机构名称等实体类别。这类任务很考验模型对输入格式的理解以及对边缘案例的处理能力。

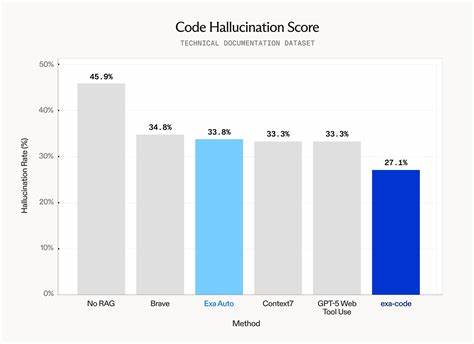

从实验数据来看,RFT在训练样本极少(仅10条)时,确实带来了性能提升,尤其体现出强学习能力和对奖励信号的敏感度。用户可以通过定制评分体系,精细指导模型输出质量,增强准确率和一致性。然而,监督微调在使用了更大规模数据集后实现了更优结果,且花费远远低于RFT。具体成本上,RFT训练10条数据花费65美元左右,而同样数据规模下SFT只需不到一美元。若扩大到全量数据,SFT仅需约0.4美元,成本优势更为显著。更重要的是,SFT带来了更快的推理速度和极大减少的运营开支。

第二个实验场景是代理编码任务,旨在让模型在终端环境内完成复杂代码编译、模型训练和多步骤系统配置等任务。这里RFT的优势明显体现。即使仅微调两段对话样本,强化微调极大地提高了模型的成功执行率,而SFT反而在同等及扩大数据下表现稍显退步。此结果表明,代理编码这类需要复杂多步骤规划和执行的场景,强化学习的反馈机制有助于模型建立更合理的策略,避免错误累积和决策失误。尽管RFT成本高昂,约170美元训练费与SFT的0.7美元形成强烈对比,但在实际应用中,高成本换来更可靠的任务完成度,依然可能符合部分企业和研究机构的需求。第三个实验聚焦于客户服务任务,目标是让模型在多轮对话中执行订单管理、取消和修改操作,并遵守安全与身份验证策略。

实验结果揭示了RFT的不足,强化微调在样本数少的条件下反而导致性能下降,不如基线表现,用户的实际操作体验下降。相比之下,监督微调不仅提升了表现,还具备良好的扩展潜力,随着训练数据量增大,模型性能继续改善。该任务对业务场景的要求极高,包括正确执行数据库变更及有效沟通,强化微调在此表现不佳,可能与内容审核策略和样本分布复杂度有关。针对RFT现阶段应用的一大最大制约即是成本。实验显示,RFT平均价格是SFT的100至700倍,这对于频繁迭代调优和试错的研发团队来说,无疑形成明显壁垒。复杂的奖励函数设计和调试过程也面临高额花费,限制了系统性探索和快速优化。

此外,与RFT相关的内容审核严格,往往导致部分训练数据无法通过验证,进一步缩减可用训练样本,影响模型优化效率。反观监督微调,价格亲民,能够处理更大批量数据,结合丰富的训练样本量,往往实现更平衡的性能提升和成本控制。对于大多数应用场景而言,SFT依然是提升语言模型实用性的经济有效选项。当然,从技术角度看,RFT具备独特优势,特别是在设计灵活动态的奖励评分函数时,可以根据具体任务定制精细化指标,发挥强化学习的长项。代理编码任务的成功案例证明,当需模型跨多步骤连贯决策时,强化微调具备较大潜力。未来,通过改进训练机制、优化奖励设计及降低训练成本,RFT或将成为更广泛应用的方案。

对于开发者和企业,建议根据具体场景特点和预算灵活选择。若需求集中在理解格式化数据并保证推理速度,推荐基于大规模数据的监督微调;若面对复杂策略决策或多阶段执行,且预算充足,强化微调值得尝试。TensorZero作为开源微调平台,提供一站式解决方案,涵盖质量数据收集、训练评估、实验管理等多方面,有助于提高SFT和RFT的自动化程度与效率,从而降低使用门槛。总的来说,OpenAI的强化微调目前尚处发展初期,高昂的开发成本和现实挑战限制了其大规模推广。它在小样本复杂任务中展示的优势激励着技术进步,但多数应用场景下,监督微调凭借高性价比与成熟稳定性仍然是主流选择。开发者应密切关注RFT技术的演进,权衡自身需求,理性布局AI模型优化路线图。

一个值得期待的方向是将强化微调与监督微调结合,创造出兼具成本效益与智能表现的混合训练框架,推动LLM应用更进一步走向工业化与普及化。未来,随着计算资源价格下降和训练技术革新,强化微调有望成为打造高性能领域定制语言模型的重要助力。 。