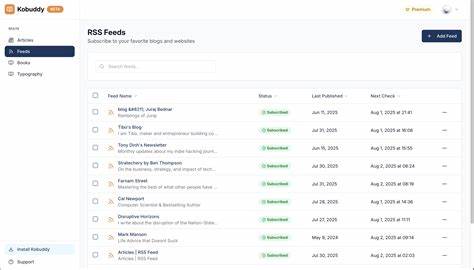

随着人工智能技术的不断进步,尤其是大型语言模型(LLM)和多模态AI的发展,开发高效且灵活的AI应用成为业界关注的重点。面对跨模态输入、多任务异步调用和复杂逻辑组合,传统的代码开发方式往往显得笨重且难以维护。Google DeepMind近期推出的GenAI处理器库,专为解决这类挑战而设计,为开发者带来了全新的开发范式。这一开源的Python库以其模块化设计、异步流处理及对Gemini API的深度整合,极大提升了构建多模态实时应用的效率和灵活性,成为构建下一代智能应用的重要工具。 GenAI处理器的核心理念是将复杂的AI工作流拆解为最小的处理单元——处理器(Processor),每个处理器承担特定的功能,从数据输入、预处理,到模型调用,再到结果输出,均以流式的ProcessorParts进行数据传输。这种基于双向异步流的设计,使得输入输出数据(例如音频片段、视频帧、文本片段)能伴随丰富的元数据在管道中穿梭,实现了高度灵活且实时响应的流水线处理。

由于所有处理单元均采用异步流的方式连接,GenAI处理器自动优化任务的并发执行。这意味着只要某个处理节点的先行依赖已满足,它便可以立即开始处理,而无需等待整体序列完成,从而显著降低了用户等待的首次响应时间(TTFT)。这种设计极大地改进了传统同步或半同步接口的弊端,使得即便是复杂的多模态实时应用,也能保持低延迟和高吞吐。 以一个实时“Live Agent”为例,开发者可以轻松组合摄像头视频流和麦克风音频输入,利用Gemini Live API进行实时模型推理,并将输出音频直接播放。仅需几行代码即可完成整个流程的搭建,极大降低了开发门槛。同时,借助Python的强大异步支持,开发者不用面对繁琐的线程管理和复杂的并发控制,代码更加简洁且易于维护。

除了实时流处理,GenAI处理器对基于文本的LLM交互同样友好。开发者可以构建从语音识别、文本生成到语音合成的全链路双向流处理器,实现高度自然的语音对话系统。结合Google Speech API及Gemini模型,生成的响应可以即时转换为音频播放,满足多种人机交互需求。 该库设计的另一大亮点是极强的扩展性。任何开发者都能基于处理器基类或装饰器轻松定义自定义处理单元,将第三方API、专属数据处理逻辑无缝引入自己的处理流水线。这种开放的架构助力生态繁荣,也为不同AI场景下的个性化需求提供弹性支持。

统一的多模态数据处理接口是GenAI处理器可贵的优势。在传统开发中,音频、图像、文本常需分别处理且格式各异,难以高效融合。GenAI的ProcessorPart统一封装了多种数据类型,既方便流式传输,也支持灵活的数据操作与切分、拼接等高级流操作,极大提升了管道设计的清晰度和复用性。 此外,Google DeepMind团队提供了丰富的学习资源和实践示例。开发者可通过官方GitHub仓库获取完整代码、Colab笔记本及多场景示例,快速上手并深入理解核心设计理念。无论是研究助理、实时评论员,还是旅行计划师,各类复杂应用都能够高效构建。

未来,随着Gemini生态的持续发展和GenAI处理器功能的不断完善,它必将成为连接多模态AI模型与实际应用场景的桥梁。面对AI应用日益增长的实时性和复杂性需求,基于GenAI处理器构建的灵活流水线将引领开发模式变革,一站式解决响应速度、编码复杂性和模块复用难题,助力开发者打造更具创新力和用户体验的AI产品。 总结来说,GenAI处理器不仅让复杂的多模态数据处理变得结构化和模块化,更通过异步流的并行执行优化,实现了低延迟高效输出。它结合了Python丰富的异步特性和Gemini API强大的AI能力,为开源智能应用开发树立了新标准。如果你希望开发具备实时交互能力、支持多模态输入输出且易于扩展维护的先进AI应用,GenAI处理器无疑是必不可少的工具。探索这一平台,你将开启构建未来智能世界的便捷之门。

。