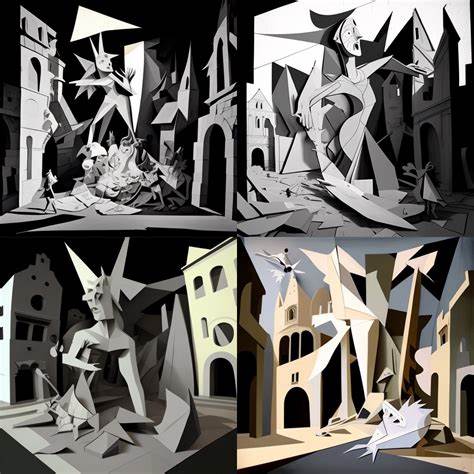

1937年4月26日,西班牙巴斯克小镇格尔尼卡遭遇了惨无人道的空袭,这场空袭标志着现代战争进入了一个新的阶段,战争的残酷和破坏性被前所未有地升级。德意联合空军指挥官们将格尔尼卡作为试验场,彼时的技术与战略突破揭示了未来战争将如何越过传统战线,直接对民众发动致命打击。这一次的历史事件不仅成为反战艺术的永恒象征,也成为后世对战争暴行反思的关键起点。如今,在信息时代的背景下,格尔尼卡的影子正以另一种形式重现,人工智能技术赋能的作战体系正引领着战争模式的根本变革,尤其是在加沙地区的冲突中,人类社会目睹了高度自动化技术带来的恐怖效应。技术不再仅是辅助工具,它已经成为杀戮链条上的核心组件,将战争的执行者与受害者之间的距离彻底拉远,复杂的算法和数据模型在黑暗的操作中决定生命的存亡。以色列国防军利用美国先进的炸弹和人工智能生成的"击杀名单",这背后是庞大的数据监控系统和人工智能平台的支持,例如被称为"Lavender"的AI驱动平台,据传其设计灵感源自美国大数据巨头Palantir。

令人震惊的是,该系统竟将百名平民死亡视为可接受的附带损害,这种冷酷无情的量化标准不仅挑战了国际人道法的底线,更令全球良知为之震动。然而,围绕AI技术在军事实践中的应用,公众话语却被营销宣传和技术吹捧淹没,真正的危害与伦理问题被掩盖在光鲜的广告和技术神话之下。正如一位前Palantir员工所揭露的,这些技术背后隐藏着巨大的危险和人权隐患。前员工描述了他亲身参与构建的AI"杀戮链条",这是一套由人工智能、无人机、数据分析和自动化执行相结合的战争机器。Palantir与美军的密切合作,特别是在"Project Maven"中的角色,使其成为军事AI发展的先锋。起初,这位员工也对公司技术抱有积极期待,期望通过高效数据分析解决世界难题,但随着深入参与,多次目睹技术被用于严重侵犯隐私和助推武装冲突,他逐渐认识到背后的黑暗现实。

商业领域亦不例外,AI和大数据被广泛应用于消费者行为预测、市场营销和公共管理中,企业通过庞大的数字孪生模型(digital twins)模拟真实世界,从而实现对个人和群体的精准监控与操控。军事上的"发现-定位-追踪-锁定-打击-评估"六步杀戮链在商业应用中同样存在,只是最终目标从致命打击转变为提升商品销量和用户黏性,从监控战场变成了监视消费者。此过程构筑了无形的数据信息壁垒和控制垄断,全球数十万家科技公司纷纷角逐人工智能市场,在数字化和自动化的浪潮中埋下深刻的监控陷阱,与此同时,个人隐私与自由空间不断被侵蚀。人工智能技术的军事根源决定了它在伦理和社会影响上的复杂性。正如麻省理工学院人工智能风险数据库和学者凯特·克劳福德的研究指出,军事背景塑造了今天的人工智能工具和方法,也驱动了全球科技巨头与国家权力之间日益紧密的合作。AI所被赋予的高效和自动化表象掩盖了其带来的工具性剥削和威权风险。

具备强烈攻击性的宣传往往包装成明星级的影像和炫酷的科技语言,误导社会对AI技术的理解和接受,而这恰恰是技术资本与军工复合体谋求霸权的策略。加沙冲突与Palantir的案例成为了技术伦理与国际法交汇的焦点。人权组织和联合国专家相继批评这些AI武器化平台涉嫌违反人权和人道主义原则,导致大量无辜平民的伤亡。同时,在美国本土,类似的军事监控与数据控制技术被转用于边境执法和移民驱逐行动,形成了由监视到压迫的闭环。这一现象暴露了人工智能技术渗透社会各层面的趋势,不仅是战争机器的组成部分,也已深深植根在法律、公安、医疗和商业系统中。科技公司的角色备受质疑。

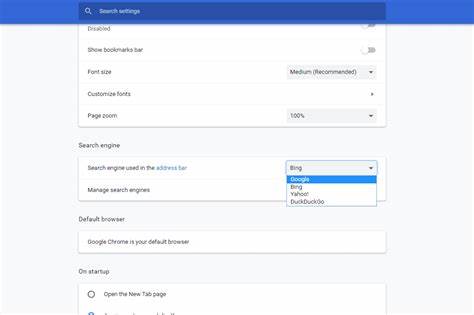

以Palantir、Anduril、SpaceX和OpenAI等为代表的企业正参与形成新的军工科技联合体,积极竞标国防合同,促使AI技术进一步渗透政府和公共机构。尽管谷歌曾承诺不涉足武器系统,现已撤销相关承诺,显示行业整体趋于加速军民融合的方向。政治与技术精英之间交织成新型"技术寡头政治",在华盛顿和硅谷协同推动数字化政府和智能监控的落实。一位前Palantir员工特别指出,企业内普遍存在军事化思维,公司的企业文化甚至被描述为"德国式",并且高管常常使用战争修辞来为公司战略辩护。另有观察者提到,埃隆·马斯克领导的政府效率部门公开招募这些技术人才,显示硅谷与军事及政府机构紧密协作的趋势。这样的发展令人联想到历史上最黑暗的专制体制,电子时代的威权技术似乎正在步步逼近。

对人工智能前景的反思与警醒也来自学界。深度学习权威教授西蒙·普林斯强调,AI的乐观愿景必须警惕,科技工作者应承担起道德责任,防止其被滥用造成社会混乱与结构性伤害。社会可能需要经历一段"技术混乱期"后重新构建更公平的系统。技术的滥用不仅限于军事或监控,未来数字脚印也可能成为限制女性权利的工具,例如用于执法的AI监测可能干涉堕胎法案的实施权。人工智能技术的普及和深度融入日常生活,让人们在不知不觉中被纳入了无形的杀戮链条或控制网络中。每个人既是系统的参与者,也是潜在的受害目标。

现代AI技术已不仅仅是简单的工具,它是经济、政治乃至文化的深刻变革者。面对愈发复杂的技术战争,社会必须更加重视对AI伦理的公开讨论和监督,要反对由技术巨头推动的国家主义与军购加速,提倡透明、负责任且具有人文关怀的科技发展路径。格尔尼卡的悲剧是历史的警钟,而未来的战争可能更为隐蔽和精准,却同样致命。AI时代的"格尔尼卡"不应该仅停留在冲突地区的废墟上,更应成为全球范围内反思技术滥用和倡导和平的象征。我们必须发出清醒的声音,揭露那些以创新和效率之名,掩盖人类苦难的技术阴谋。只有如此,才能让人工智能真正成为服务于人类福祉的利器,而非加剧分裂和暴力的催化剂。

。