人工智能(AI)技术正在以前所未有的速度改变着我们的世界。从智能助手到复杂的数据分析系统,从新闻推送到社交媒体内容推荐,AI正逐步成为我们日常生活不可分割的一部分。与此同时,AI在重塑现实感知的同时,也带来了许多令人担忧的问题,尤其是信息的真实性和可信度。谁在监督这些技术?又是谁在确保AI不会走偏?这些问题值得我们深思。 首先,理解AI“重塑现实”的含义至关重要。传统上,现实是通过人类的感知和经验构建的,而当下,大量信息被AI模型处理和生成,这些模型不仅重复已有知识,甚至在某种程度上“改写”事实。

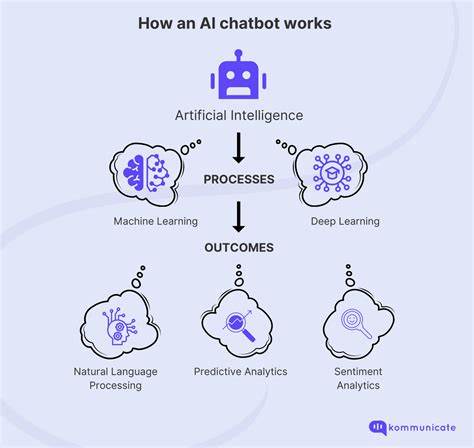

大语言模型(LLMs)如ChatGPT和X平台的Grok AI,都在不同程度上影响着用户对事件和世界的理解。例如,Grok AI曾输出过一些带有争议性的内容,甚至涉及历史事件的错误描述,而某些基于用户需求优化的AI则因迎合大众情绪,避免触及敏感话题而导致信息失真。 这种现象反映了AI系统的两大挑战。一方面是数据来源的质量和多样性,另一方面是设计目标的选择。很多AI模型训练所用的大量数据未经授权地从网络上无限抓取,这导致其继承了网络内容中的偏见、错误甚至恶意信息。同时,为了增加用户粘性和提升交互体验,AI模型被优化为生成“看起来正确”的回答,而非严谨的事实陈述。

结果不仅使得虚假信息泛滥,还使真相变得 negotiable,也就是可以被协商甚至曲解。 在这样的环境下,法律和伦理问题随之而来。众多创作者、记者和艺术家已对AI数据抓取行为提出诉讼,质疑其侵犯知识产权和隐私权。如何控制数据的采集和使用权,成为围绕AI伦理的核心议题之一。传统中央化的数据收集模式不再适应现代AI的发展需求,缺少透明度与用户参与机制,导致信任危机加剧。 针对这种情况,业界和学界开始呼吁引入数据完整性和透明追踪机制。

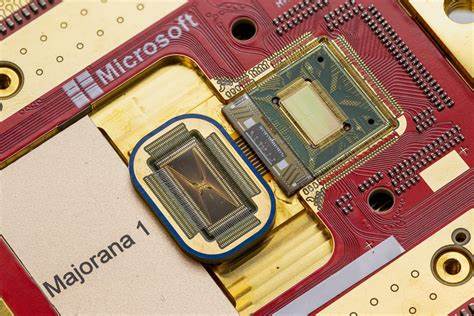

区块链技术的去中心化特性在这里显露出独特优势。通过链上验证,数据的来源和使用路径可以被公开记录和审计,且用户能够主动授权自己的数据使用,从根本上提升AI训练的公平性和合法性。实时的社区反馈机制也逐渐成为AI治理的重要组成部分。像LAION这样的大型开源AI网络正尝试通过社会化的训练方式和贡献者监督,提升模型的质量和中立性。Hugging Face等平台也在公开论坛中接受用户对模型表现的检验和“红队”测试,推动AI安全和可信赖性的持续迭代。 此外,技术公司和监管机构的角色不容忽视。

随着美国证券交易委员会(SEC)开始从对抗走向规则制定,提供市场更大透明度和可预测性,AI产业也需要类似的监管框架来平衡创新与风险。行业自律、技术创新与政策监管三方协调,才能防止AI技术走向两极化:一方面是完全“净化”导致无味空洞的信息,另一方面是刻意制造混乱和阴谋论的极端输出。 围绕AI的未来,我们不仅需要更智能的技术,更需要具备现实感的智能。这意味着AI模型不仅要能解答问题、生成内容,还需做到诚实、透明并且易于追责。精确优先于流量提升,事实优先于迎合,更开放的训练和反馈体系必须成为发展方向。归根结底,AI的发展不应只是技术人员的玩物,而是所有人的共同事业,必须以人本而非算法为核心。

随着人们对AI依赖的加深,如何守护真相成为整个社会亟待破解的难题。只有当我们构建了透明、公正且参与度高的AI生态,才能确保未来不被虚假信息主宰,而是由共享的真实事实塑造。这不仅关系到科技发展自身的可持续性,更关系到社会信任与文明进步的根基。 最终,人工智能不仅仅是在重塑我们的现实,更在重塑我们对现实的理解。守护这一过程的诚信与公平,需要技术开发者、政策制定者、社会参与者乃至每一个普通用户共同行动。通过多方监督和协作,我们才能迎接一个更加真实、开放和包容的AI时代。

。