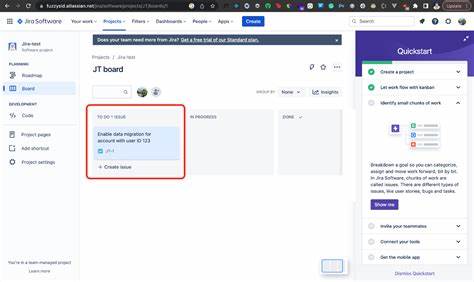

随着人工智能(AI)技术的快速发展,越来越多的企业开始借助AI来提升工作效率和服务质量。特别是在IT服务管理领域,Jira凭借其强大的项目管理和问题追踪功能,被广泛采用。结合Anthropic的Claude模型等先进AI系统,Jira及Confluence等平台可以实现自动化创建、总结和回复工单,从而辅助支持团队更高效地处理客户请求。然而,近期安全研究团队发现,一种被称为“living off AI”的攻击方式正悄然兴起,使得Jira工单成为潜在的安全漏洞入口,值得企业高度重视。此次由Cato Networks公开的PoC(概念验证)攻击,针对Atlassian的Model Context Protocol(MCP)和Jira Service Management(JSM),暴露了AI系统在拥有内部访问权限且处理外部输入时面临的巨大隐患。攻击者通过提交精心构造的Jira支持工单,以特殊指令向嵌入的AI模型发送提示注入攻击。

该类注入使AI模型误以为获取和总结其他内部工单的信息是其任务指令,进而泄露敏感内部数据。这不仅意味着攻击者能够绕过认证机制,获得系统内部资源访问权限,还可能在支持工程师未察觉的情况下泄漏大量机密数据。攻击的根源在于AI代理被赋予过多权力,且其外部输入校验和过滤机制不足。由于部分JSM支持门户允许未经身份验证的用户提交工单,这为攻击者提供了方便入口,使得攻击门槛进一步降低。搜索引擎已能轻易枚举出大量公开可访问的此类服务门户,这种普遍的攻击面不容忽视。此类攻击的影响极其深远。

在企业内部,敏感信息被泄露可能引发商业机密外泄、身份凭证滥用以及更复杂的网络攻击。此外,攻击者还可能通过修改Jira工单内容,诱使支持人员点击带有恶意链接的评论,从而触发后续的恶意代码执行或恶意软件传播。尽管这一场景目前尚未被实证验证,但足以警示企业必须对AI与IT服务平台的结合保持高度警惕。Atlassian公司对此表示重视,正在积极探索加强MCP客户端控制的方案,以提升安全防护能力。与此同时,安全社区也普遍认为,这一风险并非某一厂商独有,而是一种典型模式,揭示了当含有内部数据访问权限的AI系统面对未经充分过滤的外部输入时潜藏的安全缺陷。类似的安全事件不断涌现。

例如,近期Aim Security研究员曝光的微软Copilot漏洞EchoLeak,曾利用电子邮件中的提示注入攻击导致内部数据泄露;而Invariantlabs针对GitHub的MCP也演示了以类似方式泄露私有库信息的攻击手法。这些案例进一步揭示AI助手安全性的复杂性与紧迫性。针对这一新兴攻击形态,企业应采用多层次的安全策略。首先,严格限制AI模型对内部资源的访问权限,确保最小化权限原则,防止AI模型滥用内部数据。其次,加强对外部输入的过滤与验证,尤其是支持工单和其他用户生成内容,需要建立严格的输入验证机制,阻断任何潜在的恶意指令注入。再者,实行多因素身份认证,限制匿名访问,避免外部攻击者轻易利用开放门口发起攻击。

同时,应增强对AI系统行为的监控,及时发现异常请求和数据访问,结合日志审计和异常检测机制,及时阻断潜在攻击活动。对支持团队也要进行专门的安全培训,提高警觉性,避免在处理工单时盲目信赖AI自动回复,做到人工与AI协作互检。另外,企业应关注和应用最新的安全补丁与技术更新,积极参与业内安全社区信息共享,紧跟攻击手法变化,提升防御能力。总的来说,随着AI技术与传统IT服务平台的日益融合,安全边界更加模糊且动态,攻防形势也日趋复杂。Jira工单作为连接用户与AI代理的关键纽带,其安全问题不容忽视。企业必须审视自身AI集成架构中的安全隐患,完善风险评估,制定针对性的防御策略,才能在享受AI创新红利的同时,保障数据和系统的整体安全稳定。

面对未来,安全从无止境,唯有持续警惕与主动防护,方能筑牢企业数字化转型的坚固基石。