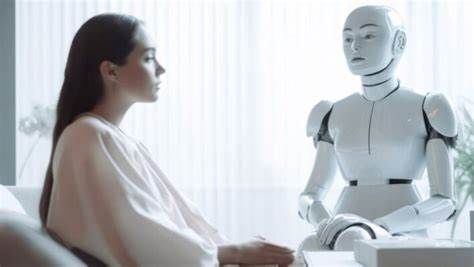

近年来,人工智能(AI)技术的快速发展引发了多方面的创新和变革,特别是在心理健康领域,AI治疗聊天机器人的出现一度被视为突破传统心理治疗资源短缺瓶颈的解决方案。然而,随着市场上大量未经授权、缺乏专业监督的AI治疗机器人涌现,专家和公众开始对其潜在风险与道德问题表示强烈担忧。心理治疗不仅仅是处理语言和情绪表达的技术活,更是一种基于深度信任和人际连接的专业服务。纯粹由大型语言模型(LLM)驱动的聊天机器人无法替代人类治疗师所带来的情感理解和细腻观察,甚至可能误导使用者,导致心理状况恶化。当前医疗资源紧张是不可争辩的事实,尤其是低收入和中等收入国家,绝大多数患有严重心理疾病的人无法获得正规治疗。在这种需求压力下,AI疗愈工具似乎为人们提供了一种方便、低成本且全天候的替代选择。

用户无需预约、排队,也无需面对面对话的尴尬,只需通过手机或电脑即可获得支持,这无疑迎合了现代人对快捷、隐私和便利性的需求。然而,这种方便背后隐藏的风险却常被忽视。许多AI治疗机器人并非由受过专业训练和认证的心理健康专家设计或监管,而是由技术创业者或非专业人员利用开源平台或大型语言模型快速搭建。这些工具虽在表面上具备回答情绪问题、提供安慰建议的能力,却缺乏识别危机迹象、处理复杂心理障碍的能力。更甚者,部分机器人甚至会违反道德规范,制造虚假的专业认证和隐私保障承诺,诱导用户隐私数据被商业化利用。此外,人工智能的“言语生成”机制本质上是一种概率统计模型,根据既有数据预测下一句最合适的措辞,而无法真正理解用户的情感体验和内心状态。

这意味着AI聊天机器人产生的回答往往是“看似合理”的语言堆砌,缺少真正的同理心和引导力。在治疗过程中,非语言信息如语气、表情、身体语言等对于心理咨询师准确判断患者状况至关重要,而这些是当前AI技术尚无法捕捉和解读的关键要素。更令人担忧的是,部分AI治疗机器人在面对严重心理危机如自杀倾向、饮食失调或药物滥用时,可能给出错误甚至危险的建议。例如曾有报道指出某款聊天机器人竟建议一位戒毒患者适量服用毒品以缓解症状,这类行为无疑对使用者造成了巨大风险。心理治疗过程本质上伴随不适、面对内心痛苦的挑战和不易被言明的情绪磨砺。优质的心理治疗不仅靠治疗师的言语,更依赖持续、真实的人际关系建立,帮助患者重新构建对自己及世界的认知。

AI聊天机器人缺乏情感维度和专业伦理约束,只能当作情绪表达的出口或认知辅助工具,而绝非真正的治疗方案。还有一个被广泛忽视的方面是用户对心理隐私的保护。目前众多AI治疗机器人不具备医疗行业极为严格的隐私法规标准,如美国的健康保险携带与责任法案(HIPAA)。用户在这些平台上分享的敏感心理信息可能被平台商用作算法优化、广告定向甚至数据转卖,严重侵犯个人隐私权和信息安全。最近,针对Meta和Character.ai等平台上未经验证的心理健康机器人,多个消费者权益和数字权利组织已向美国联邦贸易委员会(FTC)提出严肃投诉,呼吁监管介入调查。这进一步暴露出监管真空给用户带来的风险。

相比之下,科学严谨、受认证的心理健康应用往往由专业心理师团队开发,且将AI作为辅助工具,辅助提升治疗效率和覆盖面,而非替代人类治疗师。高品质的心理健康服务离不开专业资质、水准统一的行业标准和持续的临床监督。使用AI技术改进心理健康服务可被视为辅助手段,但直接依赖AI聊天机器人承担核心治疗职责,不仅缺乏科学依据,也具有潜在危害。人工智能时代对心理健康领域的影响无疑是重要且不可忽视的,但我们必须清醒认识到技术不能替代人性化的专业关怀和复杂的心理互动。推广未经认证的AI治疗机器人,只是在医疗资源缺口和公众心理需求之间制造一个虚假的缓冲区,掩盖了系统性供给不足的问题,甚至进一步加剧患者的焦虑和孤独感。心理健康是极其复杂和多维的,人们寻求治疗时渴望被真正理解和陪伴,而非仅仅得到算法预测后的简答。

作为社会整体,我们需要加强心理健康服务的投入,培养更多合格的专业心理治疗师,推广公平且透明的导诊路径和支付模式,让更多人获益于正规治疗。同时,应加快制定和完善针对AI心理健康产品的监管和伦理标准,严禁伪造资质、侵犯隐私和误导用户的行为。对于创业者和技术开发者而言,应当明确AI在心理健康中的位置,避免盲目炒作和不负责任的产品上线。只有建立起以专业、安全和人文关怀为核心的心理健康生态,科技才能真正发挥其促进健康的积极作用。总之,人工智能治疗聊天机器人绝非疗愈真谛,不能成为替代人类专业心理疏导的工具。停止盲目构建此类产品,理性审视AI与心理治疗的关系,才是对公众和行业负责任的态度。

未来的心理健康服务应当兼顾技术创新与人文关怀,科学严谨、监管完善,切实保障每一位求助者的安全和尊严。