近年来,人工智能技术的迅猛发展推动了硬件计算能力的持续革新。作为图形计算和AI领域的领军企业,NVIDIA不断突破性能边界,最近推出的Rubin CPX GPU成为业界焦点。与此同时,基于最新Blackwell Ultra架构的GB300 GPU在MLPerf AI推理基准测试中以压倒性优势刷新多项世界记录,再一次确立了NVIDIA在AI基础设施领域的领先地位。Rubin CPX的发布与Blackwell Ultra的卓越表现形成了相辅相成的格局,为AI计算带来了全新的可能性。Rubin CPX定位为专注于"海量上下文推理"的芯片,区别于此前的Rubin GPU,其采用了更为经济且高效的GDDR7显存技术,而非昂贵的HBM3e。显著提升了指数运算速度,达到GB300的三倍,具备30petaFLOPS的NVFP4格式张量计算能力,专门优化用于处理复杂的上下文信息,如对话历史、输入提示等大规模数据。

上下文数据是自然语言处理和生成式AI的关键,Rubin CPX通过其计算密集型架构,加速了大规模上下文信息的处理速度,确保整套AI系统的响应速度和准确性得到质的飞跃。NVIDIA在此次MLPerf推理基准测试中不仅依赖硬件的提升,还结合了创新的软件架构,特别是引入了NVFP4格式,该格式在确保模型精度的同时,大幅降低内存和性能资源消耗。此外,新颖的并行计算策略发挥了关键作用。针对专家混合执行(Mixture of Experts),采用了专门设计的"专家并行",而对于注意力机制部分则引入"数据并行"。这两者的巧妙分工配合NVIDIA提出的"注意力数据并行平衡"方法,能够智能调度任务负载,达到理想的吞吐率和效率。NVIDIA还创新性地提出了"分布式推理"(Disaggregated Serving)理念,将推理过程拆分为两个不同的GPU任务池。

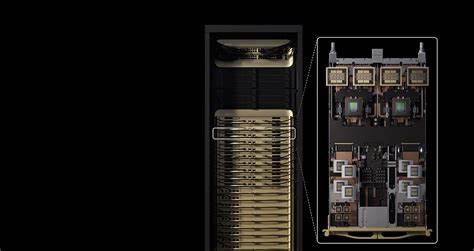

输入上下文处理作为第一阶段,计算强度极高;而输出生成阶段则更多受内存带宽限制。将这两个环节分开处理,不仅提高了单卡的吞吐率,还使整体系统相比传统Hopper架构提升了5.4倍性能,在单个GPU性能上更实现了近1.5倍增长。Rubin CPX因此成为了整套架构中专注上下文处理的关键利器,而传统Rubin GPU则负责生成部分。布置中,标准的Vera Rubin NVL144机架配备72颗Rubin GPU和36颗Vera CPU,整体计算性能达到惊人的3.6 exaFLOPS,而升级版的NVL144 CPX则在每个计算托盘中额外集成8颗Rubin CPX芯片,使得NVFP4格式的计算能力飙升至超过8 exaFLOPS。这一水平在此前几年都是难以想象的。未来,NVIDIA还计划推出"双机架"方案,将Vera Rubin NVL144的标准计算托盘和仅由Rubin CPX与Vera CPU组成的托盘分别放在两个机架中,进一步拓宽了内存容量至150TB,极大满足超大规模AI模型对内存和计算的苛刻需求。

该方案理论性能同样达到8 exaFLOPS,预计将为训练和推理带来更大灵活性和效率。Rubin CPX所采用的GDDR7显存不仅降低了成本,还优化了功耗与带宽的平衡,助力系统在庞大上下文数据面前保持高效能。在生成式AI、自然语言理解、多模态推理等多领域,这种架构能够加快响应速度、提升模型能力,对推动AI产品商业化及大规模部署具有深远影响。综合来看,NVIDIA这次发布的Rubin CPX与Blackwell Ultra的辉煌战绩,代表了AI芯片技术的新高峰。通过精准的任务分割、创新的计算格式和显存配置、协同优化的软件架构,NVIDIA为应对日益复杂的AI推理挑战提供了全方位的硬件支持。全球范围内,越来越多企业和机构将借助这类前沿架构,实现海量数据智能处理、自然语言交互和高效生成式AI的变革。

可以预见,未来几年的AI基础设施正随着Rubin CPX和Blackwell Ultra的加持迎来质的升级,推动人工智能从研究走向更广泛的产业应用。 。