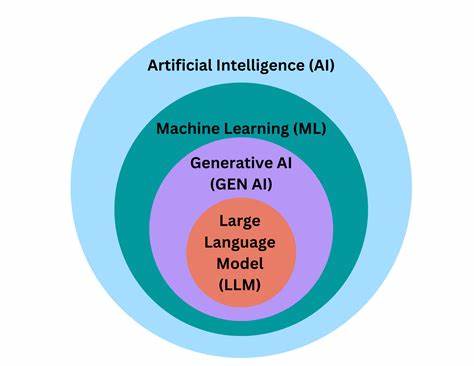

随着人工智能技术的迅猛发展,特别是大型语言模型(LLM)的普及,AI提示(Prompt)作为连接人类意图与模型理解的桥梁,其管理与优化变得尤为关键。传统的版本控制工具如Git,在处理纯文本差异时固然强大,但对于语义层面的细微变化却难以准确捕捉,从而使得提示语的迭代和质量保障存在一定盲区。基于这一需求,LLM Prompt Diff应运而生,成为业界探索语义级别文本比较的创新工具。LLM Prompt Diff是一款命令行界面(CLI)工具,专注于大语言模型提示的管理、打包及语义差异比对。它的设计宗旨是弥补传统文本对比工具的不足,通过语义向量的方式,量化两个版本提示语的语义相似度,精准识别对模型行为可能产生实质影响的变化。该工具的核心优势在于,它能够提供“语义得分”而非简单的文本差异,帮助开发者在提示迭代过程中预防回归,确保功能和效果稳定。

LLM Prompt Diff支持多种嵌入服务提供商,以满足不同的使用场景。开发者既可以使用默认的本地SentenceTransformers模型all-MiniLM-L6-v2进行离线计算,也可接入OpenAI的云端嵌入接口,利用API密钥进行授权。双重嵌入选项不仅提升了灵活度,也保障了对数据隐私和计算资源的弹性管理。使用流程方面,LLM Prompt Diff为用户提供了简洁高效的命令集。比如初始化命令可以迅速生成基础提示模板和规范化的清单文件,为后续开发工作打下基础。当编辑完成后,用户可以通过“prompt pack”命令对单个提示文件进行语义向量的生成和版本管理,同时嵌入语义版本号,方便后续追溯变化。

对于不同版本提示的对比,“prompt diff”命令能够计算两个提示间的语义相似度,并以百分比形式直观呈现结果。通过设置阈值,系统还能自动判断是否通过差异审核,这对于持续集成和持续交付(CI/CD)流程尤为重要,使得AI产品在发布前能有效避免因为提示回归带来的性能波动。此外,LLM Prompt Diff还支持JSON格式的输出,方便集成多样化自动化平台,实现语义差异结果的机器可读性。纲领性的清单文件(.pp.json格式)规范了提示内容、版本号、描述、标签、模型类型以及对应的嵌入向量,从而建立起标准化的数据结构,利于大规模提示资产的管理和共享。安全和隐私方面,LLM Prompt Diff坚持本地优先的设计理念,除非用户显式选择OpenAI云端服务,否则所有数据均保留在本地环境中。API密钥仅通过环境变量读取,不会触发任何隐秘或非授权的网络请求,也无任何遥测功能。

这确保了使用者的数据安全性和合规性,使企业级应用更加放心。这套工具的诞生,极大地推动了AI提示工程领域的版本控制实践。相比传统的文本差异检测,语义层面的比较能够帮助提示开发者更合理地衡量迭代改动的实际影响,支持更加科学的测试和反馈机制。学术界和工业界对此类工具的关注也日益增多,反映了AI提示作为生产力工具和模型接口的重要性。结合示例工作流程,使用者可先初始化一个新提示文件,再按需进行修改和二次打包,最后以差异比对确保改动合理可控。团队协作时也能通过语义相似度判断同事提交的修改是否达标,保障开发效率和质量。

随着大型语言模型的持续升级,提示编写的复杂度快速提升,LLM Prompt Diff在其中发挥的作用也愈发突出。它既是工程师的实用利器,也是AI产品研发环节中不可或缺的质量守护者。未来,随着更多模型支持和语义理解能力的进步,此类工具有望实现更深层次的智能化分析,比如在多轮对话或复杂指令集合中的语义演变跟踪。总结来看,LLM Prompt Diff是一款切实解决AI提示管理难题的高效工具,结合语义计算和版本控制工具的最佳实践,帮助开发者平衡创新效率与稳定性。无论是个人开发者,还是大型AI团队,都能从中受益匪浅。此外,它的开源背景也鼓励社区共建生态,共同推动AI提示工程的标准化进程,是构建未来智能交互系统基础设施的重要组成部分。

。