Transformer自诞生以来,以其强大的序列建模能力和优越的并行计算特性,成为自然语言处理领域的核心架构。然而,传统的Transformer注意力机制存在计算复杂度为二次方的问题,即随着输入序列长度的增加,计算资源和时间开销呈平方级增长,这极大限制了它在超长文本处理、基因序列分析和时间序列预测等场景中的实际应用。近年来,众多研究致力于突破这一“二次方壁垒”,使得模型在保持性能的同时,实现线性或近线性复杂度优化。WERSA(Wavelet-Enhanced Random Spectral Attention)便是这一领域的里程碑式创新。WERSA由研究者Vincenzo Dentamaro提出,结合了多分辨率分析的小波变换、输入自适应的滤波器机制和随机特征投影,打造出一种全新的线性复杂度注意力机制,兼顾了计算效率和表达能力。该模型不仅已发布论文,还开放了完整的源代码和安装包,助力学术界与产业界快速应用与扩展。

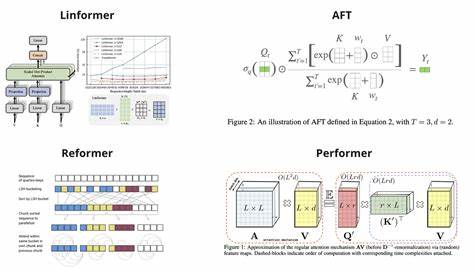

WERSA的核心理念基于多分辨率分析,具体采用Haar小波变换对输入序列进行不同尺度的分解。这种处理方式使得模型能够在不同频率层面捕捉输入的细节与整体结构,实现全局信息和局部特征的有效融合。此外,WERSA利用多层感知机(MLP)动态生成输入相关的滤波器,并通过可学习的尺度权重对小波层级进行调节,这种自适应机制让模型能够根据输入数据智能聚焦于最有信息量的频率成分,提升了对复杂语义结构的敏感度和鲁棒性。传统Transformer的注意力计算中,softmax核的全矩阵运算导致显著的资源消耗。WERSA通过引入随机特征投影技术,将softmax操作转化为低维空间上的线性操作,避免了全矩阵乘法的瓶颈,从而实现了真正意义上的线性时间复杂度。这种近似不仅大幅度减少了内存使用和计算负担,还在保持注意力机制准确性的同时,显著提高了推理速度和模型可扩展性。

WERSA的开源代码库托管于GitHub,并提供了详细的使用示例和预训练模型。用户只需安装PyTorch和Hugging Face Transformers框架,便可以通过pip指令快速集成WERSA包,构建起支持超长序列的高性能因果语言模型。令人瞩目的是,WERSA不仅适用于大规模参数模型的训练,还支持从0.6亿到80亿参数级别的灵活配置,满足不同计算资源和实际需求。从科学研究到商业应用,WERSA在多个场景展现出巨大潜力。自然语言处理领域中,长文档摘要、全文检索、对话系统等任务对上下文的理解能力提出了极高要求,而WERSA正好能够有效处理超长上下文,实现信息整合和准确生成。在生物信息学中,基因组序列的超长数据处理同样受益于其线性复杂度优势,助力精准医疗和新药研发。

时间序列分析、视频理解等跨模态场景亦可借助WERSA的多分辨率特性,实现更加细腻且高效的信息提取。此外,WERSA还为AI模型的绿色计算提供了技术支持。随着基础模型规模激增,能耗和硬件负载成为行业关注的焦点,WERSA在算法层面的优化有效减轻了计算资源的压力,促进了更加可持续的人工智能发展。开源的透明性也使得全球研究者能够基于WERSA开展创新性改进,如应用于多模态融合、领域自适应及强化学习等方向,充分发挥其底层架构优势。结合最新进展,未来能够预计WERSA将在诸多AI前沿任务中扮演关键角色,推动Transformer从短文本向超长文本、高维度数据的无缝扩展。对企业和科研机构而言,掌握WERSA技术不仅意味着突破模型瓶颈,更是抢占未来人工智能市场的制高点。

总之,WERSA作为一项融合小波变换、自适应滤波与随机特征投影的革命性注意力机制,有效解决了Transformer面临的二次方复杂度难题,开启了超长序列处理的新时代。其开源生态与灵活扩展性为多领域应用提供了极大便利,引领Transformer架构迈向更广阔的应用场景和极致性能表现。随着这项技术的深入发展与普及,人工智能模型对长文本和复杂序列数据的理解能力将得到质的飞跃,推动自然语言处理及相关领域的创新应用不断涌现。