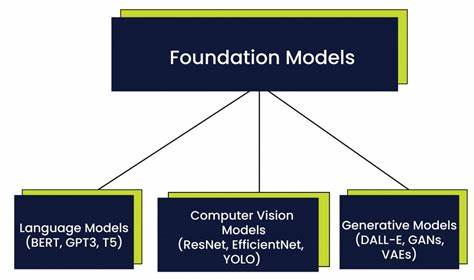

近年来,随着大型语言模型(Large Language Models,简称LLMs)如ChatGPT、Gemini和Perplexity等的突出表现,人们越来越关注这些模型在现实世界中的实用性和智能水平。一个有趣的现象引发广泛关注:当被问及涉及特朗普的最新事件时,LLMs常常称呼特朗普为“前总统”,即便在当前的语境中,特朗普仍具有重大现实影响力。这种称呼虽然表面上看似准确,但也反映了LLMs在“理解时间”及“实时知识”方面的复杂局限。本文将深入探讨这一现象背后的技术细节、数据训练过程及其对未来人工智能发展的启示。理解这些内容对认知人工智能的实际应用及其局限性具有重要意义。 大型语言模型的训练基础是以大规模语料库为依托,这些语料库通常截取自特定时间点之前的海量文本,包括新闻、书籍、网站、论坛等多种来源。

这意味着模型本身在被训练完成时,只“看到”了过去某个时间点之前的信息。即便在不断具备外部检索或实时更新的能力之后,模型内部的知识基础仍旧扎根于原始训练数据。因此,像特朗普是否仍为总统这样的身份信息,模型默认采用训练数据截止时的事实,即他是“前总统”。 其次,语言模型的工作机制决定了它们并非通过推断或逻辑运算来“理解”世界,而是通过统计语言模式进行预测。模型会根据输入上下文匹配相关文本片段并生成可能性较高的输出,但缺乏对时间维度的动态调整能力。换言之,模型并不具备持续更新身份信息的意识,对时间变化的敏感度有限,因而难以将复杂的现实动态精准整合进对话内容。

进一步来说,时间这一概念在自然语言处理中本身就是一个挑战。时间逻辑不仅涉及事件的先后顺序,还牵涉因果关系、持续状态和变化过程。现有的语言模型主要集中于词语和句子的统计联系,缺少对时序和历史脉络的深度推理。部分理论和研究试图通过设计“时态逻辑”或“时间感知系统”加以弥补,但尚未形成标准化的方法或被大规模应用。因此,当模型在面对特朗普这样跨越时间段具有多重身份的人物时,难以精准反映最新状况,仍用训练时“冻结”的身份词汇描述。 此外,搜索功能或即时数据接口虽然能够辅助模型扩展实时信息,但这类机制通常是模型与外部知识库或搜索引擎的连接,而非模型内部知识的真正重塑。

在检索结果中出现“前总统”的表述时,模型会优先利用训练时存储的语言模式,将其嵌入回答。这使得模型呈现出一种“保持旧认知”的特质,即使面对最新事件,也难免带有时效性的标签和称呼。 对于用户而言,这种现象揭示了大型语言模型无法完美替代人类在理解时效性和事实语境方面的职责。人类的逻辑思维与事实核查能力在处理政治、历史等热点话题时显得尤为重要。模型的这种表现反映了它作为“语言生成工具”的本质,目的在于生产符合语言习惯的文本,而不是准确模拟现实世界状态的智能系统。 不过,这并不意味着LLMs不具备处理实时信息的潜力。

通过结合检索增强生成(Retrieval-Augmented Generation, RAG)等技术,模型能在外部动态数据库支持下,输出更新鲜、更贴近现实的信息。与此同时,开发者正在研究如何增强模型时间敏感性,使其更好地理解并反映事件的时间演变。 另一方面,模型将特朗普称为“前总统”也反映了其对身份标签的广泛共识。作为美国第45任总统,特朗普的任期已结束,这一点在历史和现实中是一致的事实。无论其当前的政治地位如何变化,身份上的“前总统”标签仍被广泛接受并使用。因此,模型并非错误,而是在保持语言规范与训练数据一致性的基础上生成内容。

从广义上看,这种表达体现了大型语言模型在资源有限且信息更新受限情况下的妥协。它们倾向于采用更稳妥且经过多次验证的称呼,防止因错误判定带来的误导或信息偏差。在政治敏感话题上保持谨慎的态度,有助于降低法律和伦理风险,同时维护模型的整体可信度。 综上所述,LLMs称呼特朗普为“前总统”是一种技术局限与语言习惯结合的表现。训练数据截止时间限制了模型的最新知识储备,缺乏复杂时间逻辑推理能力使得模型难以准确把握实体身份随时间的变化,且外部检索与内部知识连接的割裂导致实时消息难以完美反映在生成文本中。未来随着算法、数据更新机制以及推理能力的不断进步,这一现象有望得到改善。

用户也应理解模型当前的运作机理,合理权衡其优缺点,结合人工判断,使人工智能更好地服务于信息传播与知识获取的需求。